¶ 1 Конфигурирование RT.DataVision

¶ 1.1 Файл конфигурации

Чтобы настроить приложение, создайте файл superset_config.py. Добавьте этот файл в PYTHONPATH или создайте переменную среды SUPERSET_CONFIG_PATH, указав полный путь к файлу superset_config.py.

Например, при развёртывании RT.DataVision непосредственно в системе на базе Linux, где файл superset_config.py находится в каталоге /app, вы можете запустить:

export SUPERSET_CONFIG_PATH=/app/superset_config.pyЕсли вы используете собственный Dockerfile с официальным образом RT.DataVision в качестве базового образа, вы можете добавить свои переопределения, как показано ниже:

COPY --chown=superset superset_config.py /app/

ENV SUPERSET_CONFIG_PATH /app/superset_config.pyРазвёртывания docker-compose по-разному обрабатывают конфигурацию приложения. Подробности см. здесь.

Ниже приведены некоторые параметры, которые вы можете установить в файле superset_config.py:

# Конфигурация для конкретного RT.DataVision

ROW_LIMIT = 5000

# Конфигурация Flask App Builder

# Секретный ключ приложения будет использоваться для безопасной подписи cookie сессии и шифрования чувствительных данных в базе данных

# Убедитесь, что вы меняете этот ключ для развёртывания с помощью надёжного ключа

# Альтернативно вы можете установить его с помощью переменной среды `SUPERSET_SECRET_KEY`

# Вам необходимо установить ключ для производственных сред, иначе сервер не запустится, и соответственно в логах вы увидите ошибку

SECRET_KEY = 'рандомно_сгенерированный_надёжный_секретный_ключ'

# Строка подключения SQLAlchemy к базе данных

# Это подключение определяет путь к БД, в которой хранятся метаданных RT.DataVision (графики, подключения, таблицы, дашборды и пр.)

# Обратите внимание, что данными для подключения к источникам данных, которые вы хотите изучить, вы должны управлять непосредственно в UI

# Свойство check_same_thread=false гарантирует, что клиент sqlite не обеспечивает однопоточный доступ, что может привести к проблеме

SQLALCHEMY_DATABASE_URI = 'sqlite:////путь/к/rtdatavision.db?check_same_thread=false'

# Флаг Flask-WTF для CSRF

WTF_CSRF_ENABLED = True

# Добавьте эндпоинты, которые должны быть освобождены от защиты CSRF

WTF_CSRF_EXEMPT_LIST = []

# Токен CSRF, срок действия которого истекает через 1 год

WTF_CSRF_TIME_LIMIT = 60 * 60 * 24 * 365

# Установите ключ API, чтобы включить визуализацию Mapbox

MAPBOX_API_KEY = ''Все параметры и значения по умолчанию, определённые в config.py, можно переопределить в локальном файле superset_config.py. Вы можете изучить файл, чтобы понять, что можно настроить локально, а также какие значения установлены по умолчанию.

Поскольку superset_config.py действует как модуль конфигурации Flask, его можно использовать для изменения настроек самого Flask, а также расширений Flask, таких как flask-wtf, flask-caching, flask-migrate и flask-appbuilder. Веб-фреймворк Flask App Builder, используемый RT.DataVision, предлагает множество настроек конфигурации. Обратитесь к документации Flask App Builder для получения дополнительной информации о том, как его настроить.

Обязательно измените следующие параметры:

- SQLALCHEMY_DATABASE_URI — по умолчанию хранится в ~/.superset/superset.db;

- SECRET_KEY — измените на длинную случайную строку.

Если вам нужно исключить эндпоинты из CSRF (например, если вы используете кастомный эндпоинт обратной передачи аутентификации), вы можете добавить эндпоинты в WTF_CSRF_EXEMPT_LIST:

WTF_CSRF_EXEMPT_LIST = [‘’]¶ 1.2 Определение SECRET_KEY

¶ 1.2.1 Определение инициирующего SECRET_KEY

Для запуска RT.DataVision требуется определённый пользователем SECRET_KEY. Добавьте сильный SECRET_KEY в файл superset_config.py, например:

SECRET_KEY = 'рандомно_сгенерированный_надёжный_секретный_ключ'Вы можете создать надёжный безопасный ключ с помощью openssl rand -base64 42.

¶ 1.2.2 Изменение SECRET_KEY

Если вы хотите изменить существующий SECRET_KEY, выполните следующие действия:

1. Добавьте новые SECRET_KEY и PREVIOUS_SECRET_KEY в superset_config.py:

PREVIOUS_SECRET_KEY = 'текущий_ключ'

SECRET_KEY = 'сгенерированный_надёжный_новый_ключ'Вы можете найти свой текущий SECRET_KEY с помощью этих команд (если RT.DataVision работает с docker, выполните их из контейнера с приложением RT.DataVision):

superset shell

from flask import current_app; print(current_app.config["SECRET_KEY"])2. Сохраните файл superset_config.py с этими значениями.

3. Запустите superset re-encrypt-secrets.

4. Удалите параметр PREVIOUS_SECRET_KEY и его значение из superset_config.py в целях безопасности и сохраните файл.

¶ 1.3 Хранилище метаданных в производственной среде

По умолчанию RT.DataVision настроен на использование SQLite, это простой и быстрый способ начать работу (установка не требуется).

Однако в производственных средах использование SQLite крайне не рекомендуется из соображений безопасности, масштабируемости и целостности данных. Важно использовать только поддерживаемые движки баз данных и рассмотреть возможность использования другого выбранного движка базы данных на отдельном хосте или контейнере.

RT.DataVision поддерживает движки/версии баз данных, перечисленные в таблице ниже.

Таблица “Поддерживаемые движки/версии баз данных”

| Движок базы данных | Поддерживаемые версии |

|---|---|

| PostgreSQL | 10.Х, 11.Х, 12.Х, 13.Х, 14.Х, 15.Х |

| MySQL | 5.7, 8.Х |

Используйте драйверы базы данных и строки подключения, представленные в таблице.

Таблица "Драйверы БД и строки подключения"

| База данных | Пакет PyPI | Строка подключения |

|---|---|---|

| PostgreSQL | pip install psycopg2 | postgresql://<UserName>:<DBPassword>@<Database Host>/<Database Name> |

| MySQL | pip install mysqlclient | mysql://<UserName>:<DBPassword>@<Database Host>/<Database Name> |

Чтобы сконфигурировать хранилище метаданных RT.DataVision, задайте для ключа конфигурации SQLALCHEMY_DATABASE_URI в superset_config соответствующую строку подключения.

¶ 1.4 Запуск на HTTP-сервере WSGI

Вы можете запустить RT.DataVision на Nginx или Apache, но рекомендуется использовать Gunicorn в асинхронном режиме. Он обеспечивает эффективный параллелизм и довольно прост в установке и настройке. Обратитесь к документации выбранной вами технологии, чтобы настроить приложение Flask WSGI так, чтобы оно корректно работало в вашей среде. Далее приведена асинхронная настройка, которая успешно работает в производственной среде:

-w 10 \

-k gevent \

--worker-connections 1000 \

--timeout 120 \

-b 0.0.0.0:6666 \

--limit-request-line 0 \

--limit-request-field_size 0 \

--statsd-host localhost:8125 \

"superset.app:create_app()"Обратитесь к документации Gunicorn для получения дополнительной информации. Обратите внимание, что веб-сервер разработки (superset run или flask run) не предназначен для использования в производственной среде.

Если вы не используете Gunicorn, вы можете отключить использование flask-compress, установив COMPRESS_REGISTER = False в superset_config.py.

В настоящее время sdk Python Google BigQuery несовместим с gevent из-за динамических свойств манкипатчинга в основной библиотеке Python со стороны gevent. Итак, когда вы используете BigQuery в качестве источника данных в RT.DataVision с сервером gunicorn, вам необходимо использовать отличный от gevent тип воркера.

¶ 1.5 Конфигурация HTTPS

Вы можете настроить восходящий поток HTTPS через балансировщик нагрузки или обратный прокси-сервер (например, nginx) и выполнить разгрузку SSL\TLS до того, как трафик достигнет приложения RT.DataVision. В этой настройке локальный трафик от воркера Celery, выполняющего снапшот графика для Оповещений и отчётов (Alerts & Reports), может получить доступ к RT.DataVision по URL-адресу http:// из-за точки входа. Вы также можете настроить SSL в Gunicorn (веб-сервере Python), если используете официальный docker-образ RT.DataVision.

¶ 1.6 Конфигурация балансировщика нагрузки

Если вы используете RT.DataVision за балансировщиком нагрузки или обратным прокси-сервером (например, Nginx или ELB на AWS), вам может потребоваться использовать эндпоинт проверки работоспособности, чтобы ваш балансировщик нагрузки знал, работает ли ваш инстанс RT.DataVision. Такая функциональность предоставляется в эндпоинте /health, который вернёт ответ 200, содержащий ОК, если веб-сервер работает.

Если балансировщик нагрузки вставляет заголовки X-Forwarded-For/X-Forwarded-Proto, вам следует установить ENABLE_PROXY_FIX = True в файле конфигурации RT.DataVision (superset_config.py), чтобы извлекать и использовать заголовки.

В случае, если обратный прокси-сервер используется для обеспечения SSL-шифрования, может потребоваться явное определение X-Forwarded-Proto. Для веб-сервера Apache это можно настроить следующим образом:

RequestHeader set X-Forwarded-Proto "https"¶ 1.7 Кастомная конфигурация OAuth2

RT.DataVision построен на Flask-AppBuilder (FAB), который поддерживает множество провайдеров “из коробки” (GitHub, Twitter, LinkedIn, Google, Azure и т.д.). Помимо этого, RT.DataVision можно настроить для соединения с другими имплементациями сервера авторизации OAuth2, которые поддерживают авторизацию с помощью «кода».

Убедитесь, что пакет pip Authlib установлен на веб-сервере.

Сначала сконфигурируйте авторизацию RT.DataVision в superset_config.py:

from flask_appbuilder.security.manager import AUTH_OAUTH

# Установите тип аутентификации на OAuth

AUTH_TYPE = AUTH_OAUTH

OAUTH_PROVIDERS = [

{ 'name':'egaSSO',

'token_key':'access_token', # Имя токена в ответе access_token_url

'icon':'fa-address-card', # Иконка для провайдера

'remote_app': {

'client_id':'myClientId', # Идентификатор клиента (идентификация приложения RT.DataVision)

'client_secret':'MySecret', # Секрет для этого идентификатора клиента (идентификация приложения RT.DataVision)

'client_kwargs':{

'scope': 'read' # Область авторизации

},

'access_token_method':'POST', # Метод HTTP для вызова access_token_url

'access_token_params':{ # Дополнительные параметры для вызовов access_token_url

'client_id':'myClientId'

},

'access_token_headers':{ # Дополнительные заголовки для вызовов access_token_url

'Authorization': 'Basic Base64EncodedClientIdAndSecret'

},

'api_base_url':'https://myAuthorizationServer/oauth2AuthorizationServer/',

'access_token_url':'https://myAuthorizationServer/oauth2AuthorizationServer/token',

'authorize_url':'https://myAuthorizationServer/oauth2AuthorizationServer/authorize'

}

}

]

# Разрешить самостоятельную регистрацию пользователей, что позволит создавать пользователей Flask из авторизованных пользователей

AUTH_USER_REGISTRATION = True

# Роль самостоятельной регистрации пользователя по умолчанию

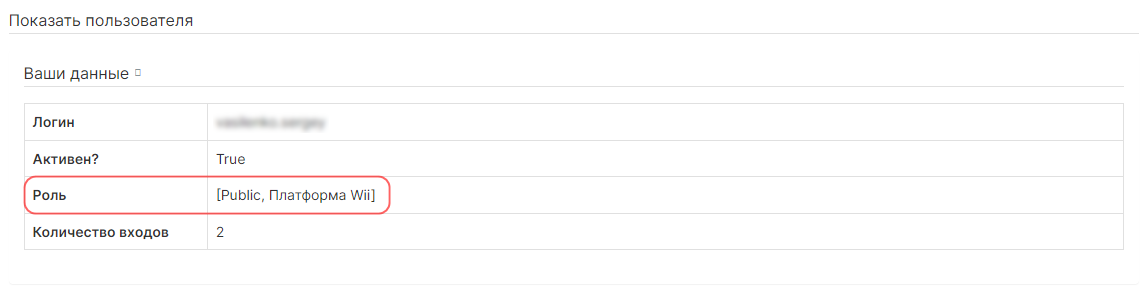

AUTH_USER_REGISTRATION_ROLE = "Public"Затем создайте CustomSsoSecurityManager, который расширяет SupersetSecurityManager и переопределяет oauth_user_info:

import logging

from superset.security import SupersetSecurityManager

class CustomSsoSecurityManager(SupersetSecurityManager):

def oauth_user_info(self, provider, response=None):

logging.debug("Oauth2 provider: {0}.".format(provider))

if provider == 'egaSSO':

# Например, эта строка запрашивает GET для base_url + '/' + userDetails с Bearer Authentication,

# и ожидает, что сервер авторизации проверит токен и ответит данными пользователя

me = self.appbuilder.sm.oauth_remotes[provider].get('userDetails').data

logging.debug("user_data: {0}".format(me))

return { 'name' : me['name'], 'email' : me['email'], 'id' : me['user_name'], 'username' : me['user_name'], 'first_name':'', 'last_name':''}

...Данный файл должен находиться в том же каталоге, что и superset_config.py, с именем custom_sso_security_manager.py. Далее добавьте следующие 2 строки в superset_config.py:

from custom_sso_security_manager import CustomSsoSecurityManager

CUSTOM_SECURITY_MANAGER = CustomSsoSecurityManagerУчитывайте следующие примечания:

- URL-адрес редиректа будет https://<superset-webserver>/oauth-authorized/<provider-name> при настройке провайдера авторизации OAuth2, если это необходимо. Например, для приведённой выше конфигурации URL-адрес редиректа будет https://<superset-webserver>/oauth-authorized/egaSSO.

- Если сервер авторизации OAuth2 поддерживает OpenID Connect 1.0, вы можете настроить только его URL-адрес документа конфигурации, не указывая api_base_url, access_token_url, authorize_url и другие необходимые параметры, такие как эндпоинт информации о пользователе, jwks uri и т.д. Например:

OAUTH_PROVIDERS = [

{ 'name':'egaSSO',

'token_key':'access_token', # Имя токена в ответе access_token_url

'icon':'fa-address-card', # Иконка для провайдера

'remote_app': {

'client_id':'myClientId', # Идентификатор клиента (идентификация приложения RT.DataVision)

'client_secret':'MySecret', # Секрет для идентификатора клиента (идентификация приложения RT.DataVision)

'server_metadata_url': 'https://myAuthorizationServer/.well-known/openid-configuration'

}

}

]¶ 1.8 LDAP-аутентификация

Flask-AppBuilder (FAB) поддерживает аутентификацию учётных данных пользователя на сервере LDAP.

Чтобы использовать LDAP, вам необходимо установить пакет python-ldap. Обратите внимание, что пакет python-ldap поставляется с RT.DataVision версии ≥ 1.3.1.

Подробности смотрите в документации FAB по LDAP.

¶ 1.9 Маппинг групп LDAP\OAUTH на роли RT.DataVision

AUTH_ROLES_MAPPING в Flask-AppBuilder — это справочник, который осуществляет маппинг имён групп LDAP/OAUTH на роли FAB. Он используется для назначения ролей пользователям, которые проходят аутентификацию с помощью LDAP или OAuth.

¶ 1.9.1 Маппинг групп OAUTH на роли RT.DataVision

Следующий справочник AUTH_ROLES_MAPPING выполняет маппинг группы OAUTH superset_users на роли RT.DataVision Gamma и Alpha, а группу OAUTH superset_admins на роль RT.DataVision Admin:

AUTH_ROLES_MAPPING = { "superset_users": ["Gamma","Alpha"], "superset_admins": ["Admin"], }¶ 1.9.2 Маппинг групп LDAP на роли RT.DataVision

Следующий справочник AUTH_ROLES_MAPPING выполняет маппинг DN LDAP cn=superset_users,ou=groups,dc=example,dc=com на роли RT.DataVision Gamma и Alpha, а также DN LDAP cn=superset_admins,ou=groups,dc=example,dc=com на роль RT.DataVision Admin:

AUTH_ROLES_MAPPING = { "cn=superset_users,ou=groups,dc=example,dc=com": ["Gamma","Alpha"], "cn=superset_admins,ou=groups,dc=example,dc=com": ["Admin"], }

Примечание. Для выполнения маппинга необходимо установить AUTH_LDAP_SEARCH. Для получения более подробной информации обратитесь к документации FAB Security.

¶ 1.9.3 Синхронизация ролей при входе в систему

Вы также можете использовать переменную конфигурации AUTH_ROLES_SYNC_AT_LOGIN, чтобы контролировать, как часто Flask-AppBuilder синхронизирует роли пользователя с группами LDAP/OAUTH. Если для AUTH_ROLES_SYNC_AT_LOGIN установлено значение True, Flask-AppBuilder будет синхронизировать роли пользователя при каждом входе в систему. Если для AUTH_ROLES_SYNC_AT_LOGIN установлено значение False, Flask-AppBuilder будет синхронизировать роли пользователя только при их первой регистрации.

¶ 1.10 Конфигурация hook приложения Flask

FLASK_APP_MUTATOR — это функция конфигурации, которая может быть предоставлена в вашей среде, получает объект приложения и может изменять его любым способом. Например, добавьте FLASK_APP_MUTATOR в свой superset_config.py, чтобы установить срок действия cookie-файла сессии на 24 часа:

from flask import session

from flask import Flask

def make_session_permanent():

'''

Enable maxAge for the cookie 'session'

'''

session.permanent = True

# Установите максимальный срок сессии на 24 часа

PERMANENT_SESSION_LIFETIME = timedelta(hours=24)

def FLASK_APP_MUTATOR(app: Flask) -> None:

app.before_request_funcs.setdefault(None, []).append(make_session_permanent)¶ 1.11 Флаги функций

Для поддержки разнообразного набора пользователей в RT.DataVision есть некоторые функции, которые не включены по умолчанию. Например, у одних пользователей более строгие ограничения безопасности, а у других нет. Таким образом, RT.DataVision позволяет пользователям включать или отключать некоторые функции с помощью конфигурации. Для владельцев функций вы можете добавить дополнительные функции в RT.DataVision, но они будут затронуты только подмножеством пользователей.

Вы можете включить или отключить функции с помощью флага из superset_config.py:

FEATURE_FLAGS = {

'PRESTO_EXPAND_DATA': False,

}Текущий список флагов функций можно найти в RESOURCES/FEATURE_FLAGS.md.

¶ 1.12 Конфигурационные настройки RT DataVision

| Настройка | Описание | Значение по умолчанию | |

|---|---|---|---|

| STATS_LOGGER | Логгер для статистики. | DummyStatsLogger() | |

| EVENT_LOGGER | Логгер для событий в RT DataVision. | DBEventLogger() | |

| SUPERSET_LOG_VIEW | Логгер статистики в реальном времени, реализован StatsD. | True | |

| BASE_DIR | Базовая директория приложения. | pkg_resources.resource_filename("superset", "") | |

| VERSION_INFO_FILE | Путь к файлу version_info.json для RT DataVision. | str(files("superset") / "static/version_info.json") | |

| PACKAGE_JSON_FILE | Путь к файлу package.json для RT DataVision. | str(files("superset") / "static/assets/package.json") | |

| ALEMBIC_SKIP_LOG_CONFIG | Если значение True, то вызов для загрузки конфигурации логгера, найденной в alembic.ini, будет пропущен. | False | |

| VERSION_STRING | Строка версии RT DataVision, извлекаемая из файлов. | _try_json_readversion(VERSION_INFO_FILE) or _try_json_readversion(PACKAGE_JSON_FILE ) | |

| VERSION_SHA_LENGTH | Длина сокращённого хэша версии приложения, используемого для отображения в интерфейсе или логах. | 8 | |

| VERSION_SHA | SHA-1 хеш версии. | _try_json_readsha(VERSION_INFO_FILE, VERSION_SHA_LENGTH) | |

| BUILD_NUMBER | Номер сборки, отображаемый в разделе "О программе", если он доступен. Это значение может быть заменено во время сборки, чтобы отобразить информацию о версии сборки. | None | |

| DEFAULT_VIZ_TYPE | Визуализация по умолчанию, используемая в исследователе графиков и в SQL Lab. | "table" | |

| ROW_LIMIT | Лимит строк по умолчанию при запросе данных для графика. | 50000 | |

| SAMPLES_ROW_LIMIT | Лимит строк по умолчанию при запросе выборок из источника данных в режиме исследования. | 1000 | |

| NATIVE_FILTER_DEFAULT_ROW_LIMIT | Лимит строк по умолчанию для нативных фильтров. | 1000 | |

| FILTER_SELECT_ROW_LIMIT | Максимальное количество строк, возвращаемое автозаполнением выбора фильтра. | 10000 | |

| DEFAULT_TIME_FILTER | Фильтр времени по умолчанию в режиме исследования. Значения могут быть, например, "Last day", "Last week", "<ISO date> : now" и т.д. | NO_TIME_RANGE | |

| SUPERSET_WEBSERVER_TIMEOUT | Это важная настройка, и её значение должно быть ниже, чем настройки тайм-аутов для вашего [балансировщика нагрузки / прокси / Envoy / Kong / ...]. Также убедитесь, что тайм-аут для вашего WSGI-сервера (например, gunicorn, nginx, apache, ...) настроен на значение, не превышающее это значение. | int(timedelta(minutes=1).total_seconds()) | |

| SUPERSET_DASHBOARD_PERIODICAL_REFRESH_LIMIT | Эти две настройки используются функцией принудительного периодического обновления дашборда. Когда пользователь выбирает частоту автоматического принудительного обновления, которая меньше значения SUPERSET_DASHBOARD_PERIODICAL_REFRESH_LIMIT, он увидит предупреждающее сообщение в модальном окне выбора интервала обновления. |

0 | |

| SUPERSET_DASHBOARD_PERIODICAL_REFRESH_WARNING_MESSAGE | None | ||

| SUPERSET_DASHBOARD_POSITION_DATA_LIMIT | Лимит данных о положении виджетов на дашборде в RT DataVision. Используется для ограничения размера данных, связанных с размещением элементов на дашборде. | 65535 | |

| CUSTOM_SECURITY_MANAGER | Настройка для указания пользовательского менеджера безопасности. Она позволяет внедрить собственную логику управления безопасностью, заменяя стандартный механизм безопасности в RT DataVision. | None | |

| SQLALCHEMY_TRACK_MODIFICATIONS | Опция отслеживания изменений в SQLAlchemy. Когда установлена в True, SQLAlchemy отслеживает изменения объектов и управляет дополнительной нагрузкой на ресурсы. Обычно рекомендуется оставлять её False для повышения производительности. | False | |

| SECRET_KEY |

Секретный ключ приложения. Убедитесь, что он переопределен в superset_config.py или используется через переменную окружения SUPERSET_SECRET_KEY. Используйте сильную сложную строку, состоящую из букв и цифр, и воспользуйтесь инструментами для генерации случайных последовательностей, например, командой openssl rand -base64 42. |

os.environ.get("SUPERSET_SECRET_KEY") or CHANGE_ME_SECRET_KEY | |

| SQLALCHEMY_DATABASE_URI | URI базы данных для SQLAlchemy. | 'postgresql://superset:superset@localhost/superset' | |

| SQLALCHEMY_CUSTOM_PASSWORD_STORE | Функция для подключения пользовательского хранилища паролей для всех соединений SQLAlchemy. Функция должна принимать единственный аргумент типа sqla.engine.url и возвращать пароль. | None | |

| DEMO_DATA_REPO | Ссылка на репозиторий с демо данными без указания протокола. | "" | |

| DEMO_DATA_LOGIN | Логин для доступа к репозиторию с демо данными. | "" | |

| DEMO_DATA_PASSWORD | Пароль для логина, используемого для доступа к репозиторию с демо данными. | "" | |

| SQLALCHEMY_ENCRYPTED_FIELD_TYPE_ADAPTER | Используется для построения моделей SQLAlchemy, которые включают чувствительные поля, подлежащие шифрованию перед отправкой в базу данных. | (SQLAlchemyUtilsAdapter) | |

| QUERY_SEARCH_LIMIT | Лимит количества запросов для поиска по запросам. | 1000 | |

| WTF_CSRF_ENABLED | Флаг для CSRF защиты в Flask-WTF. | True | |

| WTF_CSRF_EXEMPT_LIST | Список конечных точек, которые не нуждаются в CSRF защите. |

|

|

| DEBUG | Режим отладки для веб-сервера. | os.environ.get("FLASK_DEBUG") | |

| FLASK_USE_RELOAD | Флаг для режима отладки Flask. | True | |

| PROFILING | Включает профилирование Python-вызовов. Чтобы просмотреть стек вызовов, добавьте ?_instrument=1 к URL страницы. | False | |

| SHOW_STACKTRACE | Разрешает отображение трассировки Python для пользователя. В целях безопасности рекомендуется отключить в production. | False | |

| ENABLE_PROXY_FIX | Использовать все заголовки X-Forwarded, когда эта опция включена. | False | |

| PROXY_FIX_CONFIG | Настройки для проксирования при использовании заголовков X-Forwarded. |

|

|

| SCHEDULED_QUERIES | Настройка для планирования запросов из SQL Lab, представляющая собой словарь с ключами типа str и значениями произвольного типа (dict[str, Any]). По умолчанию это пустой словарь, который можно заполнить для задания параметров и правил планирования выполнения SQL-запросов. | {} | |

| Настройки ограничения скорости для предотвращения атак DDoS. | |||

| RATELIMIT_ENABLED | Настройка для включения функции ограничения скорости в Flask. | True | |

| RATELIMIT_APPLICATION | Настройка для определения ограничения скорости запросов к приложению. | "50 per second" | |

| AUTH_RATE_LIMITED | Настройка, которая определяет, требуется ли аутентификация для доступа к приложению с ограничением скорости. Если установлено значение True, то аутентификация является обязательной, и если установлено значение False, то она не требуется. | True | |

| AUTH_RATE_LIMIT | Настройка для определения ограничения скорости для аутентифицированного пользователя. | "5 per second" | |

| RATELIMIT_STORAGE_URI | Настройка, определяющая местоположение хранилища для ограничения скорости. Это URI, указывающее на хранилище, которое используется для хранения информации о запросах. Например, для использования Redis это может быть строка вида "redis://host:port". Схема хранения должна соответствовать спецификации, указанной в документации для библиотеки limits. Например: "redis://host:port" | None | |

| RATELIMIT_REQUEST_IDENTIFIER | Настройка, которая определяет уникальный идентификатор для каждого запроса. Это callable объект, возвращающая идентификатор текущего запроса. Чаще всего используется для отслеживания количества запросов, сделанных определенным пользователем или на определенный ресурс. Например: flask.Request.endpoint | None | |

| Глобальные настройки для конструктора приложения | |||

| APP_NAME | Настройка для задания названия приложения. Это имя будет использоваться для отображения в пользовательском интерфейсе или других местах, где необходимо указать название приложения. | "Superset" | |

| APP_ICON | Логотип приложения. | "/static/assets/images/superset-logo-horiz.png" | |

| LOGO_TARGET_PATH | Ссылка, на которую будет переходить пользователь, кликнув по логотипу. | None | |

| LOGO_TOOLTIP | Подсказка, отображаемая при наведении на иконку или логотип приложения. | "" | |

| LOGO_RIGHT_TEXT |

Текст, отображаемый справа от логотипа. Этот текст может быть как строкой, так и функцией, которая возвращает строку при вызове. Тип данных: Callable[[], str] | str. |

"" | |

| FAB_API_SWAGGER_UI | Включает Swagger UI для спецификации. Принимает значения True или False. | True | |

| Настройки аутентификации | |||

| AUTH_TYPE |

Настройка для выбора типа аутентификации:

|

AUTH_DB | |

| AUTH_ROLE_ADMIN | Название роли, которая будет обладать всеми правами в системе. Например: “Admin”. | None | |

| AUTH_ROLE_PUBLIC | Название публичной роли, доступной без аутентификации. Публичная роль может использоваться для пользователей, не прошедших аутентификацию. Например: “Public”. | None | |

| AUTH_USER_REGISTRATION | Позволяет разрешить пользователям регистрироваться самостоятельно в системе. Принимает значения True или False. | False | |

| AUTH_USER_REGISTRATION_ROLE | Роль, которая будет присваиваться пользователям при их саморегистрации в системе. Например: “Public”. | None | |

| AUTH_LDAP_SERVER | URL-адрес LDAP-сервера для настройки аутентификации через LDAP. Например: "ldap://ldapserver.new". | None | |

| AUTH_LDAP_EMAIL_FIELD | Название поля на LDAP-сервере, содержащее Email пользователя. Например: “mail”. | None | |

| AUTH_LDAP_SEARCH | Базовый DN для поиска на LDAP-сервере. Например: “DC=DOMAIN,DC=RU”. | None | |

| AUTH_LDAP_UID_FIELD | Название поля на LDAP-сервере, содержащее имя пользователя при поиске учетной записи для привязки. Например: “sAMAccountName”. | None | |

| AUTH_LDAP_BIND_USER | DN пользователя, из-под которого RT.DataVision будет производить поиск пользователей на LDAP-сервере при попытке аутентификации. Например: “CN=TUZUser,OU=ServiceAccounts,DC=DOMAIN,DC=RU”. | None | |

| AUTH_LDAP_BIND_PASSWORD | Пароль для пользователя, указанного в параметре AUTH_LDAP_BIND_USER. | None | |

| AUTH_LDAP_GROUP_FIELD | Название поля на LDAP-сервере, содержащее список групп пользователя. Например: "memberOf”. | None | |

| AUTH_ROLES_MAPPING |

Маппинг ролей на сервере аутентификации к ролям RT.Datavision. Записывается в виде словаря, где ключ - название группы (для LDAP это DN группы) на сервере аутентификации, а значение - список ролей, уже созданных в RT.DataVision, которые будут назначены пользователю, если он член группы на сервере аутентификации. Например:

|

{} | |

| OAUTH_PROVIDERS |

Список провайдеров OAUTH, через которые можно выполнить вход в RT.DataVision. Полное описание доступно в документации FAB. Например:

|

[] | |

| AUTH_ROLES_SYNC_AT_LOGIN | Синхронизировать роли пользователя с сервером аутентификации при каждом входе в RT.DataVision. | False | |

| PERMANENT_SESSION_LIFETIME | Время жизни сессии пользователя в секундах. | 360 | |

| OPENID_PROVIDERS |

Список провайдеров OpenID, через которые можно выполнить вход в RT.DataVision. Полное описание доступно в документации FAB. Например:

|

[] | |

| Конфигурация ролей | |||

| PUBLIC_ROLE_LIKE |

Настройка, задающая роль, для которой публичный доступ будет предоставлен с теми же правами, что и у выбранной встроенной роли. Это позволяет разрешить анонимным пользователям просматривать дашборды, но явные права на конкретные датасеты остаются обязательными. Тип данных: str | None. Значение может быть строкой (имя роли) или None для отключения такой настройки. |

None | |

| Настройки локализации с Babel | |||

| BABEL_DEFAULT_LOCALE | Язык приложения по умолчанию. | "ru" | |

| BABEL_DEFAULT_FOLDER | Путь для хранения переводов приложения. | "superset/translations" | |

| LANGUAGES | Языки для приложения. |

|

|

| LANGUAGES | Флаг для отключения i18n по умолчанию, если переводы неполные. |

|

|

| D3_FORMAT |

Переопределяет формат для локализации в D3 (например, для разделителей тысяч, десятичных знаков, валютных символов и т. д.). Подробнее см. в разделе Настройка формата D3. |

{} | |

| Функциональные флаги | |||

| DEFAULT_FEATURE_FLAGS |

Контейнер для всех флагов, которые управляют активацией или деактивацией функций. Настройка представляет собой словарь dict[str, Union[bool, str, list]]. |

||

| CLIENT_CACHE |

Настройка устарела. Включает экспериментальный функционал кеширования на стороне клиента (браузера). |

False | |

| DISABLE_DATASET_SOURCE_EDIT | Настройка устарела. | False | |

| DRUID_JOINS | Включает поддержку JOIN-запросов для новых версий Druid. | False | |

| DYNAMIC_PLUGINS | Включает поддержку динамических плагинов. | False | |

| DISABLE_LEGACY_DATASOURCE_EDITOR | Отключение редактора устаревших источников данных. | True | |

| ENABLE_EXPLORE_JSON_CSRF_PROTECTION |

Настройка устарела. Настройка предназначена для усиления защиты от CSRF-атак (межсайтовой подделки запроса) при отправке запросов к explore_json endpoint. Если значение настройки установлено на true, все запросы к этому endpoint через метод GET будут запрещены, и пользователи смогут использовать только POST-запросы. Эта мера может быть полезна для защиты от злоупотребления GET-запросами, так как flask-csrf по умолчанию защищает только POST-запросы. |

False | |

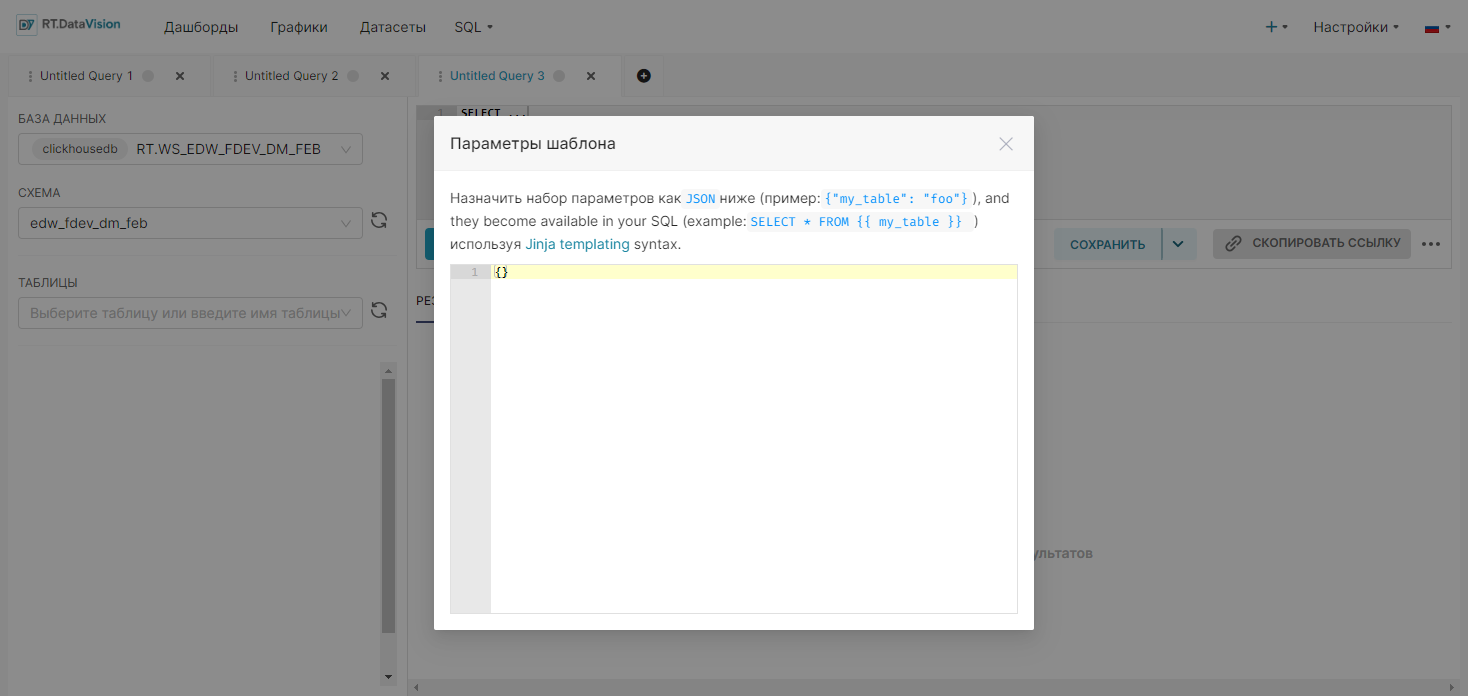

| ENABLE_TEMPLATE_PROCESSING | Включает обработку шаблонов в запросах или отчетах системы. | False | |

| ENABLE_TEMPLATE_REMOVE_FILTERS |

Настройка устарела. Включает обработку шаблонов и автоматически удаляет фильтры, используемые в визуализациях или отчетах. |

True | |

| ENABLE_JAVASCRIPT_CONTROLS | Включает поддержку компонентов управления с возможностью ввода JavaScript и настройки графиков. | False | |

| KV_STORE | Включает поддержку хранения данных в формате ключ-значение. | False | |

| PRESTO_EXPAND_DATA | Включает расширение вложенных типов данных в Presto. | False | |

| THUMBNAILS | Включает API для вычисления миниатюр. | False | |

| DASHBOARD_CACHE |

Настройка устарела. Включает использование кэша для панелей мониторинга. |

False | |

| REMOVE_SLICE_LEVEL_LABEL_COLORS |

Настройка устарела. Отключает использование индивидуальных цветов для меток уровня среза в визуализациях. |

False | |

| SHARE_QUERIES_VIA_KV_STORE | Включает возможность сохранять и делиться выполненными запросами через хранилище KV. | False | |

| TAGGING_SYSTEM | Включает поддержку системы тегов для упрощения классификации и фильтрации объектов в RT DataVision. | False | |

| SQLLAB_BACKEND_PERSISTENCE | Включает возможность сохранять запросы и результаты SQL Lab в бекенд-хранилище для последующего восстановления. | True | |

| LISTVIEWS_DEFAULT_CARD_VIEW | Включает отображение данных в виде карточек по умолчанию в представлениях списка. | False | |

| ESCAPE_MARKDOWN_HTML | Включает экранирование HTML-кода в компонентах Markdown, предотвращая его выполнение. | False | |

| DASHBOARD_NATIVE_FILTERS | Включение нативных фильтров для дашбордов. | True | |

| DASHBOARD_CROSS_FILTERS | Включает поддержку перекрестных фильтров на дашбордах. | True | |

| DASHBOARD_NATIVE_FILTERS_SET | Включает возможность использования предустановленных фильтров для панелей мониторинга. | False | |

| DASHBOARD_FILTERS_EXPERIMENTAL | Включает экспериментальные фильтры в панели мониторинга. | False | |

| DASHBOARD_VIRTUALIZATION | Включает виртуализацию для оптимизации рендеринга панелей мониторинга с большим количеством компонентов. | False | |

| GLOBAL_ASYNC_QUERIES | Включает возможность выполнения глобальных асинхронных запросов. | False | |

| VERSIONED_EXPORT | Включает возможность экспорта версии конфигурации, данных или метаданных RT DataVision. | True | |

| EMBEDDED_SUPERSET | Включает возможность встраивания RT DataVision в сторонние приложения. | False | |

| ALERT_REPORTS | Включает новую реализацию системы оповещений и отчетов. | False | |

| ENABLE_EXPLORE_DRAG_AND_DROP | Включает возможность перетаскивания объектов и элементов в интерфейсе проводника панели мониторинга. | True | |

| ENABLE_ADVANCED_DATA_TYPES | Включает поддержку расширенных типов данных в RT DataVision. | False | |

| ALERTS_ATTACH_REPORTS | Включает отправку скриншотов и ссылок вместе с уведомлениями и отчетами. | True | |

| ALLOW_FULL_CSV_EXPORT | Включает возможность полного экспорта CSV для таблиц. | False | |

| ALLOW_FULL_EXCEL_EXPORT | Включает возможность полного экспорта данных из RT DataVision в формате Excel, включая всю информацию в таблицах или визуализациях. | False | |

| GENERIC_CHART_AXES | Включает отображение общих осей на диаграммах. | True | |

| ALLOW_ADHOC_SUBQUERY | Включает выполнение подзапросов в AdHoc-фильтрах. | False | |

| USE_ANALAGOUS_COLORS | Включает использование аналогичных цветов для визуализаций. | False | |

| RLS_IN_SQLLAB | Включает применение правил RLS (политики безопасности строк) к запросам в SQL Lab. | False | |

| CACHE_IMPERSONATION | Включает кэширование на основе ключа маскировки (например, имени пользователя). | False | |

| CACHE_QUERY_BY_USER | Включает кэширование запросов по ключу пользователя. | False | |

| ENABLE_PDF_EXPORT | Включает возможность экспорта отчетов и панелей мониторинга в формате PDF. | False | |

| ENABLE_FOLDERS_VIEW | Включает возможность просмотра и управления папками в интерфейсе. | False | |

| SENDING_BY_FTP | Включает возможность отправки данных или отчетов по FTP-соединению. | False | |

| ENABLE_SENTRY_DEBUG | Включает отладку RT.DataVision через приложение Sentry. | False | |

| EMBEDDABLE_CHARTS | Включает возможность встраивания диаграмм в другие приложения. | True | |

| DRILL_TO_DETAIL | Включает возможность перехода к деталям данных из визуализации. | True | |

| DRILL_BY | Включает функцию Drill By (просмотр данных через иерархические фильтры). | False | |

| DATAPANEL_CLOSED_BY_DEFAULT | Закрывает панель данных по умолчанию на панелях мониторинга. | False | |

| HORIZONTAL_FILTER_BAR | Включает отображение горизонтальной панели фильтров. | False | |

| ESTIMATE_QUERY_COST | Включает оценку стоимости выполнения запросов. | False | |

| SSH_TUNNELING | Включает возможность настройки SSH-туннелей при создании базы данных. | False | |

| AVOID_COLORS_COLLISION | Включает предотвращение конфликта цветов в визуализациях. | True | |

| MENU_HIDE_USER_INFO | Скрывает информацию о пользователе в меню. | False | |

| ENABLE_SUPERSET_META_DB | Включает возможность использования метабазы RT DataVision. | False | |

| PLAYWRIGHT_REPORTS_AND_THUMBNAILS | Включает использование Playwright вместо Selenium для генерации отчетов и миниатюр. | False | |

| SENTRY_DEBUG | Настройки интеграции с Sentry. Используется при включенном флаге ENABLE_SENTRY_DEBUG. | ||

| SENTRY_HOSTNAME | Имя хоста сервера. | "" | |

| SENTRY_SERVER_NAME | Идентификатор сервера. | "" | |

| SENTRY_FLASK_DSN | URL подключения Sentry для бэкенда на Flask. | "" | |

| SENTRY_CELERY_DSN | URL подключения Sentry для задач Celery. | "" | |

| SENTRY_REACT_DSN | URL подключения Sentry для фронтенда на React. | "" | |

| SENTRY_FLASK_TRACE_RATE | Процент запросов Flask, включаемых в трассировку. | 0.0 | |

| SENTRY_FLASK_SAMPLE_RATE | Доля запросов Flask, используемых для мониторинга. | 0.0 | |

| SENTRY_FLASK_PROFILES_SAMPLE_RATE | Процент запросов Flask для глубокого профилирования. | 0.0 | |

| SENTRY_CELERY_TRACE_SAMPLE_RATE | Доля задач Celery, отслеживаемых для анализа. | 0.0 | |

| SENTRY_REACT_TRACE_RATE | Процент пользовательских действий на фронтенде, включённых в трассировку. | 0.0 | |

| SENTRY_REACT_PROFILES_RATE | Доля действий React, отслеживаемых для анализа производительности. | 0.0 | |

| SENTRY_REACT_REPLAYS_SESSION_RATE | Частота записи пользовательских сессий для повторного воспроизведения. | 0.0 | |

| SENTRY_REACT_REPLAYS_ONERROR_RATE | Частота записи повторов ошибок фронтенда. | 0.0 | |

| SENTRY_TRACE_PROPAGATION_TARGETS | Определяет сервисы, куда передаются трассировки. | ["localhost", "https://youserver.io/api"] | |

| DASHBOARDS_LOGOS_PATHS | Пути к изображениям логотипов для отображения в интерфейсе приложения. |

|

|

| DG_LOGO_PATH | Путь к изображениям логотипов RT Data Governance для отображения в интерфейсе приложения. |

|

|

| Настройки SSH-туннелей | |||

| SSH_TUNNEL_MANAGER_CLASS | Класс менеджера SSH туннелей. | "superset.extensions.ssh.SSHManager" | |

| SSH_TUNNEL_LOCAL_BIND_ADDRESS | Локальный адрес привязки для SSH туннелей. | "127.0.0.1" | |

| SSH_TUNNEL_TIMEOUT_SEC | Тайм-аут для соединения SSH туннеля. | 10.0 | |

| SSH_TUNNEL_PACKET_TIMEOUT_SEC | Тайм-аут для пакетов SSH туннеля. | 1.0 | |

| EXTRA_CATEGORICAL_COLOR_SCHEMES |

Настройка, позволяющая добавлять пользовательские цветовые схемы для визуализаций. Схемы задаются в виде словаря, где ключами являются названия схем, а значениями — списки цветов. Это расширяет стандартный набор цветовых схем RT DataVision, предоставляя возможность использовать уникальные палитры для анализа данных. Тип данных: list[dict[str, Any]] Пример:

|

[] | |

| THEME_OVERRIDES |

Настройка, позволяющая задавать пользовательские значения для ключей темы, таких как цвета, шрифты, размеры и другие элементы визуального оформления. Изменения, внесённые в этот словарь, применяются поверх базовой темы, позволяя кастомизировать интерфейс без изменения исходного кода. Тип данных: dict[str, Any] Пример:

|

{} | |

| EXTRA_SEQUENTIAL_COLOR_SCHEMES |

Настройка, позволяющая добавлять настраиваемые цветовые палитры для создания последовательных градиентов, которые применяются к различным типам графиков и диаграмм. Цветовые схемы вносятся в виде словарей, где указываются название схемы и её значения. Тип данных: list[dict[str, Any]] Пример:

|

[] | |

| Конфигурация миниатюр (зависит от функционального флага) | |||

| THUMBNAIL_EXECUTE_AS | Список типов исполнителей для рендеринга миниатюр. | [ExecutorType.CURRENT_USER, ExecutorType.SELENIUM] | |

| THUMBNAIL_SELENIUM_USER | Имя пользователя для создания миниатюр через Selenium. | "admin" | |

| THUMBNAIL_CACHE_CONFIG | Конфигурация кеша для миниатюр. |

|

|

| SCREENSHOT_LOCATE_WAIT | Время ожидания, чтобы Selenium дождался появления элемента на странице для скриншота. | int(timedelta(seconds=10).total_seconds()) | |

| SCREENSHOT_LOAD_WAIT | Время ожидания для исчезновения всех DOM элементов с классом "loading". | int(timedelta(minutes=1).total_seconds()) | |

| SCREENSHOT_SELENIUM_RETRIES | Количество попыток перезапуска Selenium при сбое. | 5 | |

| SCREENSHOT_SELENIUM_HEADSTART | Время (в секундах), которое Selenium будет ждать до начала захвата скриншота. | 3 | |

| SCREENSHOT_SELENIUM_ANIMATION_WAIT | Время (в секундах), которое Selenium будет ждать для завершения анимации на графике. | 5 | |

| SCREENSHOT_REPLACE_UNEXPECTED_ERRORS | Включает замену неожиданных ошибок в процессе создания скриншотов на информативные сообщения об ошибках. | False | |

| SCREENSHOT_WAIT_FOR_ERROR_MODAL_VISIBLE | Время (в секундах), которое Selenium будет ждать, чтобы увидеть модальное окно с ошибкой. | 5 | |

| SCREENSHOT_WAIT_FOR_ERROR_MODAL_INVISIBLE | Время (в секундах), которое Selenium будет ждать, чтобы модальное окно с ошибкой исчезло. | 5 | |

| SCREENSHOT_PLAYWRIGHT_WAIT_EVENT | Событие Playwright, на которое он будет ожидать при загрузке новой страницы. | "load" | |

| SCREENSHOT_PLAYWRIGHT_DEFAULT_TIMEOUT | Тайм-аут по умолчанию для всех операций в контексте браузера Playwright. | int(timedelta(seconds=30).total_seconds() * 1000 ) | |

| Конфигурация изображений и файлов | |||

| UPLOAD_FOLDER | Папка для загрузки файлов. | BASE_DIR + "/app/static/uploads/" | |

| UPLOAD_CHUNK_SIZE | Максимальный размер фрагмента данных (в байтах), который может быть загружен за один раз. | 4096 | |

| IMG_UPLOAD_FOLDER | Папка для загрузки изображений. | BASE_DIR + "/app/static/uploads/" | |

| IMG_UPLOAD_URL | URL для доступа к загруженным изображениям | "/static/uploads/" | |

| IMG_SIZE |

Максимальный размер изображения, который может быть обработан или сохранен в системе. Например: (300, 200, True) |

() | |

| CACHE_DEFAULT_TIMEOUT | Время ожидания по умолчанию для кеша. | int(timedelta(days=1).total_seconds()) | |

| CACHE_CONFIG | Конфигурация кеша для объектов RT DataVision. | {"CACHE_TYPE": "NullCache"} | |

| DATA_CACHE_CONFIG | Конфигурация кеша для метаданных и результатов запросов. | {"CACHE_TYPE": "NullCache"} | |

| FILTER_STATE_CACHE_CONFIG | Конфигурация кеша для состояния фильтров дашбордов. |

|

|

| CACHE_TYPE | Тип используемого кэша | "SupersetMetastoreCache" | |

| CACHE_DEFAULT_TIMEOUT | Время (в секундах), в течение которого кэшированные данные остаются актуальными. | int(timedelta(days=90).total_seconds()) | |

| REFRESH_TIMEOUT_ON_RETRIEVAL | Включает обновление времени жизни (таймаута) кэшированных данных при их извлечении. | True | |

| CODEC | Определяет способ сериализации и десериализации данных для хранения в кэше. | JsonKeyValueCodec() | |

| EXPLORE_FORM_DATA_CACHE_CONFIG | Конфигурация кеша для состояния данных форм исследования (Explore). |

|

|

| CACHE_TYPE | Тип используемого кэша | "SupersetMetastoreCache" | |

| CACHE_DEFAULT_TIMEOUT | Время (в секундах), в течение которого кэшированные данные остаются актуальными. | int(timedelta(days=7).total_seconds()) | |

| REFRESH_TIMEOUT_ON_RETRIEVAL | Включает обновление времени жизни (таймаута) кэшированных данных при их извлечении. | True | |

| CODEC | Определяет способ сериализации и десериализации данных для хранения в кэше. | JsonKeyValueCodec() | |

| STORE_CACHE_KEYS_IN_METADATA_DB | Включает сохранение ключей кеша в базе данных метаданных для дальнейшей обработки и аннулирования кеша. | False | |

| ENABLE_CORS | Включает поддержку CORS (кросс-оригинальных запросов). | False | |

| CORS_OPTIONS |

Опции для настройки CORS. Тип данных: dict[Any, Any] |

{ } | |

| HTML_SANITIZATION | Включает или выключает санитацию HTML контента для предотвращения XSS атак при рендеринге markdown. | True | |

| HTML_SANITIZATION_SCHEMA_EXTENSIONS |

Позволяет расширить схему санитации HTML, например, для добавления атрибутов или протоколов. Тип данных: dict[str, Any] Пример:

|

{} | |

| SUPERSET_WEBSERVER_DOMAINS | Разрешенные домены для выполнения кросс-доменных запросов. | None | |

| EXCEL_EXTENSIONS | Разрешенные расширения файлов для загрузки на страницу базы данных (форматы Excel). | {"xlsx", "xls"} | |

| CSV_EXTENSIONS | Разрешенные расширения файлов для загрузки на страницу базы данных (форматы CSV). | {"csv", "tsv", "txt"} | |

| COLUMNAR_EXTENSIONS | Разрешенные расширения файлов для загрузки на страницу базы данных (форматы для колонковых данных). | {"parquet", "zip"} | |

| ALLOWED_EXTENSIONS | Объединяет разрешенные расширения для всех типов загрузок (Excel, CSV, Columnar). | {*EXCEL_EXTENSIONS, *CSV_EXTENSIONS, *COLUMNAR_EXTENSIONS} | |

| CSV_UPLOAD_MAX_SIZE | Максимальный размер файла для загрузки CSV в байтах. | None | |

| CSV_EXPORT |

Опции для экспорта CSV, передаваемые в метод DataFrame.to_csv. Тип данных: dict[str, Any] |

|

|

| EXCEL_EXPORT |

Опции для экспорта Excel, передаваемые в метод DataFrame.to_excel. Тип данных: dict[str, Any] |

|

|

| EXCEL_DATA_WORKSHEET_NAME | Имя листа Excel, которое будет использоваться по умолчанию при экспорте данных из RT DataVision. | "Data" | |

| EXCEL_CHART_WORKSHEET_NAME | Имя рабочего листа Excel, содержащего диаграмму, при экспорте данных. | "Chart" | |

| Конфигурации временной гранулярности | |||

| TIME_GRAIN_DENYLIST |

Список временных интервалов (time grain), использование которых запрещено. Эти интервалы не будут отображаться в интерфейсе RT DataVision и не будут доступны для выбора в фильтрах и визуализациях. Тип данных: list[str] Пример: ['PT1S'] |

[] | |

| TIME_GRAIN_ADDONS |

Настройка, позволяющая добавлять пользовательские временные интервалы (time grain) для использования в RT DataVision. Это расширяет стандартный набор интервалов, предоставляя возможность настройки временной детализации для анализа данных. Тип данных: dict[str, str] Пример: {'PT2S': '2 second'} |

{} | |

| TIME_GRAIN_ADDON_EXPRESSIONS |

Настройка, позволяющая добавлять пользовательские выражения для временных интервалов (time grain) в запросах к базе данных. Эти выражения задают форматирование временных данных на уровне базы, предоставляя гибкость при обработке нестандартных временных интервалов. Тип данных: dict[str, str] Пример:

|

{} | |

| TIME_GRAIN_JOIN_COLUMN_PRODUCERS |

Настройка, определяющая функции, которые могут быть использованы для генерации колонок с временными интервалами (time grain) в операциях объединения данных (join). Тип данных: dict[str, Callable[[str], str]] Пример: {"P1F": join_producer} |

{} | |

| Ограничение типов визуализаций | |||

| VIZ_TYPE_DENYLIST |

Настройка, определяющая список визуализаций, которые должны быть недоступны для использования в интерфейсе пользователя. Тип данных: list[str] Пример: ['pivot_table', 'treemap'] |

[] | |

| VIZ_TYPE_NO_AUTO_MIGRATE_LIST |

Настройка, позволяющая задать список типов визуализаций, для которых следует отключить автоматическое обновление типа визуализации при импорте из .zip архива. Тип данных: list[str] Пример: ['pivot_table_v2'] |

[] | |

| Модули, источники данных и промежуточное ПО для регистрации | |||

| DEFAULT_MODULE_DS_MAP | Сопоставление модулей с источниками данных, которые будут зарегистрированы по умолчанию. |

|

|

| ADDITIONAL_MODULE_DS_MAP |

Дополнительные модули и источники данных, которые будут зарегистрированы. Тип данных: dict[str, list[str]] |

{} | |

| ADDITIONAL_MIDDLEWARE |

Список дополнительных промежуточных слоев (middleware), которые будут зарегистрированы. Тип данных: list[Callable[..., Any]] |

[] | |

| LOGGING_CONFIGURATOR | Конфигуратор для настройки логирования, использующий параметры LOG_*. | DefaultLoggingConfigurator() | |

| LOG_FORMAT | Формат записи в журнал логирования. | "%(asctime)s:%(levelname)s:%(name)s:%(message)s" | |

| LOG_LEVEL | Уровень логирования (DEBUG, INFO, WARNING, ERROR, CRITICAL). | "DEBUG" | |

| Включение обработчика логов с временной ротацией | |||

| LOG_LEVEL | Уровень логирования (DEBUG, INFO, WARNING, ERROR, CRITICAL). | DEBUG | |

| ENABLE_TIME_ROTATE | Включает поддержку ротации логов по времени. | False | |

| TIME_ROTATE_LOG_LEVEL | Уровень логирования для времени ротации. | "DEBUG" | |

| FILENAME | Путь к файлу логирования. | os.path.join(DATA_DIR, "superset.log") | |

| ROLLOVER | Включает ротацию логов на основе времени или объема данных. | "midnight" | |

| INTERVAL | Интервал ротации логов. | 1 | |

| BACKUP_COUNT | Количество резервных копий для ротации логов. | 30 | |

| QUERY_LOGGER | Управляет логированием SQL-запросов, выполненных в SQL Lab и при генерации диаграмм/дашбордов. | None | |

| MAPBOX_API_KEY | API ключ для использования визуализаций Mapbox. | os.environ.get("MAPBOX_API_KEY", "") | |

| MAP_CONNECTIONS | Настройка для синхронизации карт с другими элементами дашборда. | [] | |

| SQL_MAX_ROW | Максимальное количество строк, возвращаемых для любого аналитического запроса в базе данных. | 100000 | |

| FULL_CSV_MAX_ROW | Настройка ограничивает количество строк, которые могут быть экспортированы в CSV-файл при полном экспорте данных. | 100000 | |

| FULL_EXCEL_MAX_ROW | Настройка ограничивает количество строк, которые могут быть экспортированы в EXCEL-файл при полном экспорте данных. | 100000 | |

| DISPLAY_MAX_ROW | Максимальное количество строк, отображаемых в SQL Lab UI. | 10000 | |

| DEFAULT_SQLLAB_LIMIT | Стандартный лимит строк для запросов в SQL Lab. | 1000 | |

| SUPERSET_META_DB_LIMIT | Ограничивает количество данных, возвращаемых из мета-базы данных при работе с несколькими источниками. | 1000 | |

| SQLLAB_SAVE_WARNING_MESSAGE | Предупреждение, отображаемое при сохранении запроса в SQL Lab. | None | |

| SQLLAB_SCHEDULE_WARNING_MESSAGE | Предупреждение, отображаемое при планировании запроса в SQL Lab. | None | |

| DASHBOARD_AUTO_REFRESH_MODE |

Настройка, которая управляет режимом автоматического обновления данных на панели мониторинга. Тип данных: Literal["fetch", "force"] |

"force" | |

| DASHBOARD_AUTO_REFRESH_INTERVALS | Список интервалов для автоматического обновления дашборда. |

|

|

| CELERY_BEAT_SCHEDULER_EXPIRES | Время жизни задачи планировщика Celery, используемое как временное решение для задачи "alerts & reports". | timedelta(weeks=1) | |

| CELERY_CONFIG | Настройка конфигурации для Celery, отвечающая за параметры обработки фоновых задач | CeleryConfig | |

| DEFAULT_HTTP_HEADERS |

Стандартные HTTP-заголовки для сервера RT DataVision. Тип данных: dict[str, Any] |

{} | |

| OVERRIDE_HTTP_HEADERS |

Заголовки HTTP, которые будут переопределять стандартные значения. Тип данных: dict[str, Any] |

{} | |

| HTTP_HEADERS |

Итоговые HTTP-заголовки, которые будут отправляться с ответами сервера. Тип данных: dict[str, Any] |

{} | |

| DEFAULT_DB_ID | Идентификатор базы данных по умолчанию для SQL Lab. | None | |

| SQLLAB_TIMEOUT | Время ожидания для синхронных запросов в SQL Lab. | int(timedelta(seconds=3000).total_seconds()) | |

| SQLLAB_VALIDATION_TIMEOUT | Время ожидания для проверки запросов в SQL Lab. | int(timedelta(seconds=1000).total_seconds()) | |

| SQLLAB_DEFAULT_DBID | Идентификатор базы данных по умолчанию для SQL Lab. | None | |

| SQLLAB_ASYNC_TIME_LIMIT_SEC | Максимальное время выполнения асинхронного запроса в SQL Lab. | int(timedelta(hours=6).total_seconds()) | |

| SQLLAB_QUERY_COST_ESTIMATE_TIMEOUT | Время ожидания для запроса оценки стоимости выполнения в SQL Lab. | int(timedelta(seconds=1000).total_seconds()) | |

| QUERY_COST_FORMATTERS_BY_ENGINE |

Настройка для определения форматирования стоимости запросов в зависимости от типа используемой базы данных. Тип данных: dict[str, Callable[[list[dict[str, Any]]], list[dict[str, Any]]]] Пример: {"postgresql": postgres_query_cost_formatter} |

{} | |

| SQLLAB_CTAS_NO_LIMIT | Настройка, регулирующая возможность отключения ограничения на количество строк при выполнении запросов типа CREATE TABLE AS (CTAS). | False | |

| SQLLAB_CTAS_SCHEMA_NAME_FUNC |

Настройка, представляющая функцию, которая позволяет динамически определять схему для запросов типа CREATE TABLE AS (CTAS) в SQL Lab. Тип данных: None | (Callable[[Database, models.User, str, str], str]) |

None | |

| RESULTS_BACKEND |

Включает сохранение результатов долгих запросов, запущенных через Run Async в SQL Lab. Тип данных: BaseCache | None |

None | |

| RESULTS_BACKEND_USE_MSGPACK | Если True, для сериализации результатов будет использоваться формат MessagePack вместо JSON. | True | |

| CSV_TO_HIVE_UPLOAD_S3_BUCKET | Имя S3 бакета для хранения внешних таблиц Hive, созданных из CSV файлов. | None | |

| CSV_TO_HIVE_UPLOAD_DIRECTORY | Папка в S3, в которой будут храниться внешние таблицы. | "EXTERNAL_HIVE_TABLES/" | |

| UPLOADED_CSV_HIVE_NAMESPACE |

Пространство имен Hive для таблиц, созданных из загруженных CSV файлов. Тип данных: str | None |

None | |

| CSV_DEFAULT_NA_NAMES | Список значений, которые следует воспринимать как NULL при загрузке CSV. | list(STR_NA_VALUES) | |

| JINJA_CONTEXT_ADDONS |

Словарь дополнительных функций для контекста Jinja в SQL Lab. Эти функции могут быть использованы в запросах, но требуют осторожности с точки зрения безопасности. Тип данных: dict[str, Callable[..., Any]] |

{} | |

| CUSTOM_TEMPLATE_PROCESSORS |

Словарь макросов для обработки шаблонов, зависящих от используемой СУБД. Позволяет определить пользовательскую логику обработки запросов на уровне конкретного движка. Тип данных: dict[str, type[BaseTemplateProcessor]] |

{} | |

| DEFAULT_META_DATABASE_ENABLED_ADAPTERS |

Настройка определяет статусы (включен/выключен) адаптеров для библиотеки Shillelagh, доступных для обработки запросов к базе метаданных. Тип данных: dict[str, bool] |

|

|

| META_DATABASE_ENABLED_ADAPTERS |

Список баз данных, которые поддерживаются платформой по умолчанию. Тип данных: dict[str, bool] |

{} | |

| ROBOT_PERMISSION_ROLES | Роли, управляемые API / RT DataVision, которые не должны изменяться вручную. | ["Public", "Gamma", "Alpha", "Admin", "sql_lab"] | |

| CONFIG_PATH_ENV_VAR | Переменная окружения, которая указывает путь к конфигурационному файлу RT DataVision. | "SUPERSET_CONFIG_PATH" | |

| FLASK_APP_MUTATOR | Настройка, позволяющая передать функцию (callable), которая будет вызываться при запуске приложения Flask. | None | |

| ENABLE_ACCESS_REQUEST | Настройка, определяющая, могут ли пользователи запрашивать или предоставлять доступ к источникам данных другим пользователям. Если значение установлено в False, такие действия будут недоступны. | False | |

| FTP_CONNECTIONS | Настройка, управляющая параметрами для интеграции с FTP-серверами. Она позволяет настраивать соединение для загрузки или выгрузки файлов через FTP, включая указание хоста, порта, имени пользователя, пароля и других параметров безопасности. | [] | |

| EMAIL_NOTIFICATIONS | Включение уведомлений по электронной почте. | False | |

| SMTP_HOST | Адрес SMTP-сервера для отправки уведомлений. | "localhost" | |

| SMTP_STARTTLS | Использование TLS для подключения к SMTP-серверу. | True | |

| SMTP_SSL | Использование SSL для подключения к SMTP-серверу. | False | |

| SMTP_USER | Имя пользователя для подключения к SMTP-серверу. | "superset" | |

| SMTP_PORT | Порт для подключения к SMTP-серверу. | 25 | |

| SMTP_PASSWORD | Пароль для подключения к SMTP-серверу. | "superset" | |

| SMTP_MAIL_FROM | Адрес отправителя для почтовых уведомлений. | "superset@superset.com" | |

| SMTP_SSL_SERVER_AUTH | Использование SSL-сертификата для подключения. | False | |

| ENABLE_CHUNK_ENCODING | Включение кодирования с использованием чанков. | False | |

| SILENCE_FAB | Уменьшение количества логов, генерируемых Flask App Builder (FAB). Если True, уровень логирования FAB будет повышен до ERROR. | True | |

| FAB_ADD_SECURITY_VIEWS | Включение стандартных страниц безопасности в RT DataVision для управления пользователями и ролями. | True | |

| FAB_ADD_SECURITY_PERMISSION_VIEW | Добавление представления безопасности для управления разрешениями. | False | |

| FAB_ADD_SECURITY_VIEW_MENU_VIEW | Добавление представления безопасности для меню. | False | |

| FAB_ADD_SECURITY_PERMISSION_VIEWS_VIEW | Добавление представления безопасности для разрешений на представления. | False | |

| TROUBLESHOOTING_LINK | Ссылка на страницу с инструкциями по устранению ошибок. | "" | |

| WTF_CSRF_TIME_LIMIT | Время жизни CSRF-токена в секундах. | int(timedelta(weeks=1).total_seconds()) | |

| PERMISSION_INSTRUCTIONS_LINK | Ссылка на страницу с инструкциями по получению доступа к источникам данных в случае ошибки разрешений. | "" | |

| BLUEPRINTS |

Позволяет интегрировать внешние модули (Blueprints) в приложение, добавляя их в список. Эти модули автоматически подключаются к основному приложению во время его настройки. Тип данных: list[Blueprint] |

[] | |

| TRACKING_URL_TRANSFORMER | Трансформация URL-ов для отслеживания запросов. Например, преобразования URL для Hadoop или Presto. | lambda url: url | |

| DB_POLL_INTERVAL_SECONDS |

Словарь, который задает интервалы между опросами для каждого движка базы данных. Тип данных: dict[str, int] |

{} | |

| PRESTO_POLL_INTERVAL | Интервал опроса для подключения к серверу Presto. | int(timedelta(seconds=1).total_seconds()) | |

| ALLOWED_EXTRA_AUTHENTICATIONS |

Дополнительные методы аутентификации для каждого движка базы данных. Тип данных: dict[str, dict[str, Callable[..., Any]]] |

{} | |

| DASHBOARD_TEMPLATE_ID | ID шаблона панели, который будет копироваться для каждого нового пользователя. | None | |

| DB_CONNECTION_MUTATOR | Позволяет динамически изменять параметры подключения, например, использовать адрес электронной почты пользователя в качестве имени пользователя для подключения. | None | |

| MUTATE_AFTER_SPLIT | Указывает, применять ли изменения через SQL_QUERY_MUTATOR до или после разбиения SQL-запроса на отдельные операторы | False | |

| EXCLUDE_USERS_FROM_LISTS |

Список пользователей, которые будут исключены из всех выпадающих списков пользователей, например, при создании графиков или отчетов. Тип данных: list[str] | None |

None | |

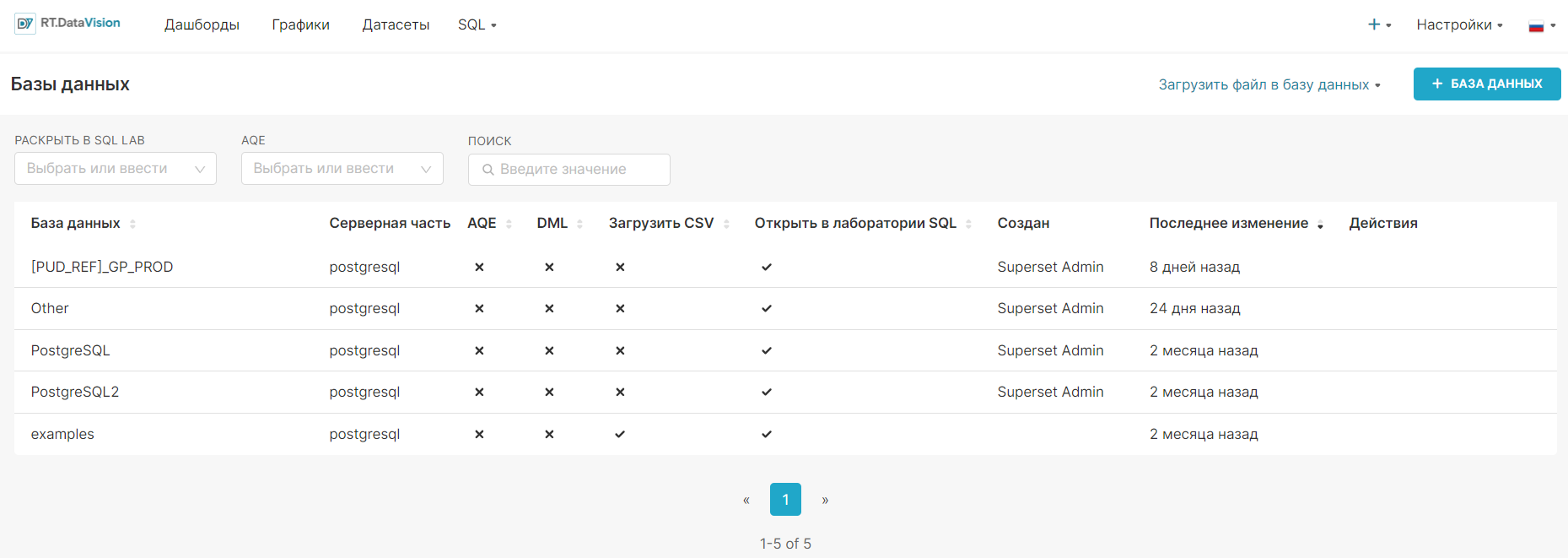

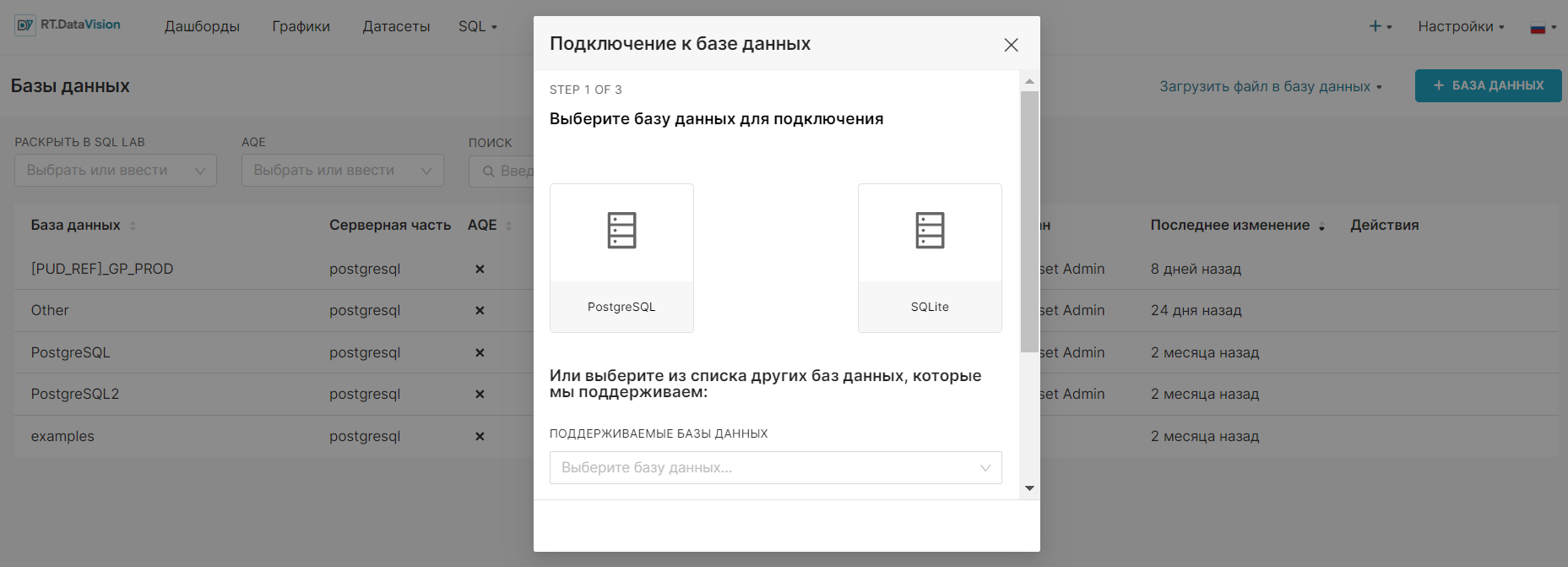

| DBS_AVAILABLE_DENYLIST |

Словарь с базами данных, которые не должны отображаться в списке доступных для подключения в интерфейсе. Тип данных: dict[str, set[str]] |

{} | |

| MACHINE_AUTH_PROVIDER_CLASS | Определяет механизм аутентификации для фона, который может быть переопределен пользователями для поддержания кастомных механизмов аутентификации. | "superset.utils.machine_auth.MachineAuthProvider" | |

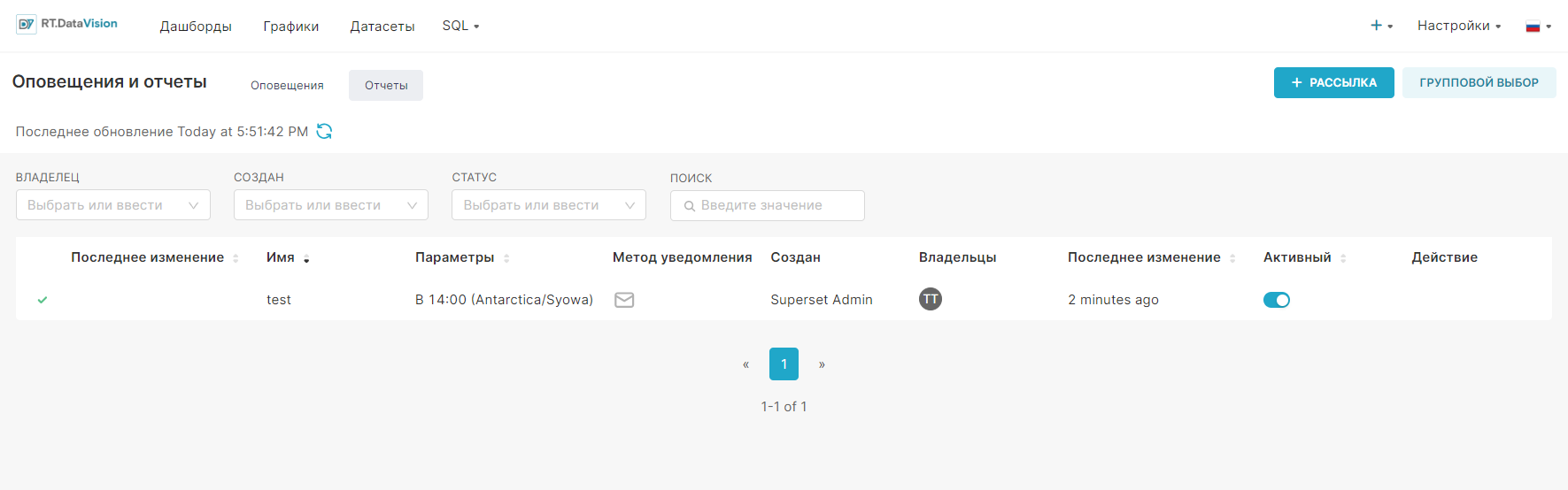

| ALERT_REPORTS_CRON_WINDOW_SIZE | Размер скользящего окна cron для оповещений и отчетов (минус 1 секунда от конфигурации celery). | 59 | |

| ALERT_REPORTS_WORKING_TIME_OUT_KILL | Завершение задачи, если она превысит время работы. | True | |

| ALERT_REPORTS_EXECUTE_AS |

Список ролей пользователей, от имени которых будут выполняться оповещения/отчеты. Тип данных: list[ExecutorType] |

[ExecutorType.OWNER] | |

| ALERT_REPORTS_WORKING_TIME_OUT_LAG | Настройка для задания дополнительного времени ожидания сверх основного тайм-аута работы оповещений и отчетов. Это значение добавляется к стандартному рабочему тайм-ауту, чтобы учесть возможные задержки в процессе выполнения задач. | int(timedelta(seconds=10).total_seconds()) | |

| ALERT_REPORTS_WORKING_SOFT_TIME_OUT_LAG | Дополнительное время ожидания, которое добавляется к "мягкому" тайм-ауту задач оповещений и отчетов. Это значение учитывает возможные незначительные задержки, не приводя к немедленному завершению задачи. | int(timedelta(seconds=1).total_seconds()) | |

| ALERT_REPORTS_DEFAULT_WORKING_TIMEOUT | Задает стандартное время ожидания для выполнения задач оповещений и отчетов. Это время используется в качестве базового при создании новых задач. | 3600 | |

| ALERT_REPORTS_DEFAULT_RETENTION | Определяет стандартный срок хранения данных отчетов и оповещений, после которого они будут удалены или архивированы. | 90 | |

| ALERT_REPORTS_DEFAULT_CRON_VALUE | Значение cron для периодичности выполнения отчетов (по умолчанию - каждый день). | "0 * * * *" | |

| ALERT_REPORTS_NOTIFICATION_DRY_RUN | Включение тестового режима для уведомлений об оповещениях и отчетах. | False | |

| ALERT_REPORTS_QUERY_EXECUTION_MAX_TRIES | Максимальное количество попыток выполнения запроса перед возвратом ошибки. | 1 | |

| ALERT_REPORTS_MIN_CUSTOM_SCREENSHOT_WIDTH | Задает минимальную ширину пользовательских скриншотов, которые можно использовать в задачах оповещений и отчетов. | 600 | |

| ALERT_REPORTS_MAX_CUSTOM_SCREENSHOT_WIDTH | Определяет максимальную допустимую ширину пользовательских скриншотов для тех же задач. | 2400 | |

| EMAIL_REPORTS_SUBJECT_PREFIX | Префикс для темы письма отчетов. | "[Report] " | |

| EMAIL_REPORTS_CTA | Текст кнопки действия в email-уведомлениях отчетов. | "Explore in Superset" | |

| SLACK_API_TOKEN |

API токен для Slack отчетов. Тип данных: Callable[[], str] | str | None |

None | |

| SLACK_PROXY | Прокси-сервер для интеграции с Slack. | None | |

| WEBDRIVER_TYPE | Тип веб-драйвера для создания миниатюр и отчетов. | "firefox" | |

| WEBDRIVER_WINDOW | Настройки окна браузера для веб-драйвера. |

|

|

| WEBDRIVER_AUTH_FUNC | Аутентификация для использования с Selenium или Playwright в отчетах и миниатюрах. | None | |

| WEBDRIVER_CONFIGURATION |

Дополнительные настройки для webdriver, передаваемые как словарь. Тип данных: dict[Any, Any] |

{"service_log_path": "/dev/null"} | |

| WEBDRIVER_OPTION_ARGS | Задаёт дополнительные параметры, которые передаются объекту конфигурации веб-драйвера. Например, для работы с браузером Chrome можно добавить аргумент "--marionette". | ["--headless"] | |

| WEBDRIVER_BASEURL | URL для веб-драйвера Selenium. | "http://0.0.0.0:8080/" | |

| WEBDRIVER_BASEURL_USER_FRIENDLY | Базовый URL, используемый для создания гиперссылок в email-отчётах. | WEBDRIVER_BASEURL | |

| EMAIL_PAGE_RENDER_WAIT | Время ожидания, в течение которого Selenium будет ждать загрузки и отрисовки страницы, используемой для создания email-отчёта. Это время учитывается перед созданием снимка или извлечением данных. | int(timedelta(seconds=30).total_seconds()) | |

| BUG_REPORT_URL | Ссылка, по которой пользователи могут сообщать об ошибках. | None | |

| BUG_REPORT_TEXT | Текст ссылки для отчета об ошибке. | "Report a bug" | |

| BUG_REPORT_ICON | Иконка для ссылки на отчет об ошибке (рекомендуемый размер: 16x16). | None | |

| DOCUMENTATION_URL | Ссылка на документацию RT DataVision. | None | |

| DOCUMENTATION_TEXT | Текст ссылки для документации. | "Documentation" | |

| DOCUMENTATION_ICON | Иконка для ссылки на документацию (рекомендуемый размер: 16x16). | None | |

| DEFAULT_RELATIVE_START_TIME | Определяет начальное время для фильтра "Последние N дней". Установка на "сегодня" означает, что началом будет полночь (00:00:00) локального часового пояса. Используется для создания временных рамок с фиксированной или плавающей точкой отсчёта. | "today" | |

| DEFAULT_RELATIVE_END_TIME | Определяет конечное время для фильтра "Последние N дней". Установка на "сейчас" делает окончание временного периода относительным к моменту выполнения запроса. Если начало и конец установлены на "сейчас", фильтр создаёт скользящее временное окно. | "today" | |

| SQL_VALIDATORS_BY_ENGINE | Определяет, какой валидатор SQL будет использоваться для каждой базы данных. |

|

|

| PREFERRED_DATABASES |

Список предпочитаемых баз данных для отображения в диалоге "Добавить базу данных". Тип данных: list[str] |

|

|

| TEST_DATABASE_CONNECTION_TIMEOUT | Время ожидания для тестирования подключения к базе данных. | timedelta(seconds=30) | |

| CONTENT_SECURITY_POLICY_WARNING | Включение или отключение предупреждений по безопасности контента (CSP). | True | |

| TALISMAN_ENABLED | Включение или отключение использования Talisman для защиты приложения. | utils.cast_to_boolean(os.environ.get("TALISMAN_ENABLED", True)) | |

| TALISMAN_CONFIG | Основные настройки политики Talisman - безопасности контента, включая CSP и настройку для HTTP/HTTPS. |

|

|

| TALISMAN_DEV_CONFIG | Конфигурация Talisman для разработки, где включены настройки для работы с eval, что необходимо для React в режиме разработки. |

|

|

| SESSION_COOKIE_HTTPONLY | Указывает, что cookie не может быть прочитано JavaScript. | True | |

| SESSION_COOKIE_SECURE | Указывает, что cookie передаются только по HTTPS. | False | |

| SESSION_COOKIE_SAMESITE |

Устанавливает политику SameSite для cookies (предотвращает отправку cookies в запросах с других сайтов). Тип данных: Literal["None", "Lax", "Strict"] | None |

"Lax" | |

| SESSION_SERVER_SIDE | Включает серверное хранение сессий с использованием Flask-сессий. | False | |

| SESSION_USE_SIGNER | Активирует использование подписанных cookie-файлов для сессий, чтобы защитить данные от подделки. | False | |

| SESSION_TYPE | Определяет хранилище для данных сессии. Например, "redis" для использования Redis, "filesystem" для локального хранения, "null" для отключения сессий. | None | |

| SESSION_REDIS |

Содержит настройки подключения к серверу Redis, который используется для хранения данных сессии при выборе соответствующего типа. Пример: Redis(host="localhost", port=6379, db=0) |

None | |

| SEND_FILE_MAX_AGE_DEFAULT | Время хранения кеша для статических ресурсов. | int(timedelta(days=365).total_seconds()) | |

| SQLALCHEMY_EXAMPLES_URI | URI для базы данных, в которой хранится пример данных. | "sqlite:///" + os.path.join(DATA_DIR, "examples.db") | |

| STATIC_ASSETS_PREFIX | Добавляет необязательный префикс ко всем путям статических ресурсов при рендеринге интерфейса пользователя. | "" | |

| PREVENT_UNSAFE_DB_CONNECTIONS | Запрещает использование небезопасных соединений с базой данных. | True | |

| PREVENT_UNSAFE_DEFAULT_URLS_ON_DATASET | Запрещает использование небезопасных URL для загрузки данных. | True | |

| ALLOWED_IMPORT_URL_DOMAINS |

Определяет список разрешенных URL-адресов для импорта данных датасетов (v1). Пример:

|

||

| DATASET_IMPORT_ALLOWED_DATA_URLS | Регулярные выражения для разрешенных URL-адресов для импорта данных. | [r".*"] | |

| SSL_CERT_PATH |

Путь к хранилищу SSL сертификатов. Тип данных: str | None |

None | |

| SQLA_TABLE_MUTATOR | Функция для изменения объектов таблиц в базе данных перед их использованием. | lambda table: table | |

| GLOBAL_ASYNC_QUERY_MANAGER_CLASS | Класс для управления асинхронными запросами. | ("superset.async_events.async_query_manager.AsyncQueryManager" ) | |

| GLOBAL_ASYNC_QUERIES_REDIS_CONFIG | Конфигурация Redis для хранения данных асинхронных запросов. |

|

|

| GLOBAL_ASYNC_QUERIES_REDIS_STREAM_PREFIX | Префикс для Redis stream, используемого для асинхронных запросов. | "async-events-" | |

| GLOBAL_ASYNC_QUERIES_REDIS_STREAM_LIMIT | Ограничение на количество событий в Redis stream. | 1000 | |

| GLOBAL_ASYNC_QUERIES_REDIS_STREAM_LIMIT_FIREHOSE | Ограничивает максимальное количество записей, сохраняемых в Redis для потока запросов Firehose в асинхронном режиме. | 1000000 | |

| GLOBAL_ASYNC_QUERIES_REGISTER_REQUEST_HANDLERS | Включает регистрацию обработчиков запросов для асинхронного выполнения. | True | |

| GLOBAL_ASYNC_QUERIES_JWT_COOKIE_NAME | Название cookie для хранения JWT токена асинхронных запросов. | "async-token" | |

| GLOBAL_ASYNC_QUERIES_JWT_COOKIE_SECURE | Указывает, будет ли cookie с JWT передаваться только по HTTPS (для обеспечения безопасности). | False | |

| GLOBAL_ASYNC_QUERIES_JWT_COOKIE_SAMESITE |

Определяет политику отправки cookie в кросс-доменных запросах для защиты от атак CSRF. Тип данных: None | ( Literal["None", "Lax", "Strict"] ) |

None | |

| GLOBAL_ASYNC_QUERIES_JWT_COOKIE_DOMAIN | Устанавливает домен для доступности cookie, например, для всех поддоменов. | None | |

| GLOBAL_ASYNC_QUERIES_JWT_SECRET | Секрет для подписи JWT. | "test-secret-change-me" | |

| GLOBAL_ASYNC_QUERIES_TRANSPORT | Протокол транспортировки асинхронных запросов, может быть polling или ws (websocket). | "polling" | |

| GLOBAL_ASYNC_QUERIES_POLLING_DELAY | Задержка для опроса в режиме polling, в миллисекундах. | int(timedelta(milliseconds=500).total_seconds() * 1000 ) | |

| GLOBAL_ASYNC_QUERIES_WEBSOCKET_URL | Указывает URL для подключения к WebSocket серверу, используемому для асинхронных запросов. | "ws://127.0.0.1:8080/" | |

| GUEST_ROLE_NAME | Имя роли для гостей (неавторизованных пользователей). | "Public" | |

| GUEST_TOKEN_JWT_SECRET | Секрет для подписи токенов гостя. | "test-guest-secret-change-me" | |

| GUEST_TOKEN_JWT_ALGO | Определяет алгоритм подписи для JSON Web Token (JWT), который используется для создания токенов гостей. | "HS256" | |

| GUEST_TOKEN_HEADER_NAME | Название заголовка для передачи токена гостя. | "X-GuestToken" | |

| GUEST_TOKEN_JWT_EXP_SECONDS | Время жизни токена гостя в секундах. | 300 | |

| GUEST_TOKEN_JWT_AUDIENCE |

Определяет целевую аудиторию (audience) для гостевого токена JWT в embedded RT DataVision. Тип данных: Callable[[], str] | str | None |

None | |

| DATASET_HEALTH_CHECK |

Проверка состояния датасета (например, проверки, если запросы работают только с одной таблицей). Тип данных: Callable[[SqlaTable], str] | None |

None | |

| ADVANCED_DATA_TYPES |

Ключ для указания расширенных типов данных, который должен соответствовать значению, заданному в метаданных столбца. Тип данных: dict[str, AdvancedDataType] |

|

|

| WELCOME_PAGE_LAST_TAB | Конфигурация для отображаемой вкладки на приветственной странице. | (Literal["examples", "all"] | tuple[str, list[dict[str, Any]]] ) = "all" | |

| ZIPPED_FILE_MAX_SIZE | Максимально допустимый размер загружаемого сжатого файла. | 100 * 1024 * 1024 | |

| ZIP_FILE_MAX_COMPRESS_RATIO | Максимальное допустимое сжатие для загружаемого файла. | 200.0 | |

| ENVIRONMENT_TAG_CONFIG | Конфигурация для отображения тега окружения на панели навигации. Устанавливает цвет и текст в зависимости от окружения. |

|

|

| EXTRA_RELATED_QUERY_FILTERS |

Фильтры, которые можно применить к связанным объектам в UI. Пример: {"user": user_filter} |

{} | |

| OSM_CONNECTIONS |

Интеграция данных и сервисов OpenStreetMap с приложением. Пример:

|

[] | |

| EXTRA_DYNAMIC_QUERY_FILTERS |

Фильтры, которые могут быть применены к объектам в UI до применения других фильтров. Пример: {"database": initial_database_filter} |

{} | |

¶ 1.12.1 Настройка фавикона (favicon)

Фавикон — это небольшая иконка, которая отображается рядом с заголовком страницы в браузере, на вкладках, в закладках, а также в некоторых местах интерфейса, где используется изображение для представления веб-сайта.

Настройка, отвечающая за фавикон – FAVICONS:

FAVICONS = [{"href": "/static/assets/images/favicon.png"}]При необходимости, существует возможность задать несколько фавиконов.

Свойство href обязательно для заполнения, так как в нем указывается путь к файлу изображения фавикона. Свойства sizes, type и rel являются опциональными.

Пример:

{

"href":path/to/image.png",

"sizes": "16x16",

"type": "image/png"

"rel": "icon"

}¶ 1.12.2 Настройка формата D3

Настройка D3_FORMAT используется для изменения формата чисел и валюты в приложении. Она позволяет настроить, как будут отображаться числа в визуализациях, используя библиотеку D3.

По умолчанию формат включает следующие параметры:

- decimal: символ для разделения десятичных чисел (например, "." в большинстве стран);

- thousands: символ, используемый для разделения тысяч (например, ",");

- grouping: определяет группировку цифр, обычно [3], что означает разделение после каждой третьей цифры (например, 1,000);

- currency: список с двумя строками — символом валюты, который ставится перед или после числа (например, ["$", ""] для долларов).

Настройка D3_FORMAT в системе по умолчанию:

class D3Format(TypedDict, total=False):

decimal: str

thousands: str

grouping: list[int]

currency: list[str]

D3_FORMAT: D3Format = {}

CURRENCIES = ["USD", "EUR", "GBP", "INR", "MXN", "JPY", "CNY"]¶ 1.12.3 Обновление функциональных флагов

Метод DEFAULT_FEATURE_FLAGS.update() обновляет функциональные флаги, используя переменные окружения с префиксом SUPERSET_FEATURE_. Эти переменные предоставляют возможность динамически изменять функциональность приложения без необходимости редактирования кода или перезапуска сервера. Значения флагов интерпретируются как булевы (True/False) с помощью функции parse_boolean_string.

DEFAULT_FEATURE_FLAGS.update(

{

k[len("SUPERSET_FEATURE_"):]: parse_boolean_string(v)

for k, v in os.environ.items()

if re.search(r"^SUPERSET_FEATURE_\w+", k)

}

)

DEFAULT_FEATURE_FLAGS.update(DASHBOARDS_LOGOS_PATHS)

DEFAULT_FEATURE_FLAGS.update(DG_LOGO_PATH)

DEFAULT_FEATURE_FLAGS.update(SENTRY_DEBUG)¶ 1.12.4 Обработка функциональных флагов

Функция GET_FEATURE_FLAGS_FUNC предназначенная для обработки словаря функциональных флагов. Она позволяет кастомизировать их значения и задавать поведение приложения на основе текущих конфигураций. Функция принимает словарь с флагами и возвращает модифицированный словарь. Не рекомендуется использовать её одновременно с IS_FEATURE_ENABLED_FUNC, чтобы избежать конфликтов при оценке флагов.

GET_FEATURE_FLAGS_FUNC: Callable[[

dict[str, bool]], dict[str, bool]] | None = None¶ 1.12.5 Проверка функциональных флагов

Функция IS_FEATURE_ENABLED_FUNC выполняет проверку состояния отдельного функционального флага. Она принимает два параметра: имя флага и необязательное значение по умолчанию.

IS_FEATURE_ENABLED_FUNC: Callable[[str, bool | None], bool] | None = None¶ 1.12.6 Переопределение общих настроек Bootstrap

Функция COMMON_BOOTSTRAP_OVERRIDES_FUNC предназначена для изменения или переопределения общих параметров Bootstrap, используемых в приложении. Позволяет настроить такие элементы, как стили, темы или дополнительные параметры, обеспечивая уникальные настройки интерфейса.

COMMON_BOOTSTRAP_OVERRIDES_FUNC: Callable[

[dict[str, Any]], dict[str, Any]

] = lambda data: {} # default: empty dict¶ 1.12.7 Функции для генерации идентификаторов миниатюр

Функция THUMBNAIL_DASHBOARD_DIGEST_FUNC предназначена для вычисления уникального хеш-суммы для миниатюр дашбордов. Получает объект дашборда, тип исполнителя и имя пользователя.

THUMBNAIL_DASHBOARD_DIGEST_FUNC: None | (

Callable[[Dashboard, ExecutorType, str], str]

) = NoneФункция THUMBNAIL_CHART_DIGEST_FUNC предназначена для вычисления уникальной хеш-суммы для миниатюр графиков. Получает объект графика, тип исполнителя и имя пользователя.

THUMBNAIL_CHART_DIGEST_FUNC: Callable[[

Slice, ExecutorType, str], str] | None = None¶ 1.12.8 Настройка фоновых задач с использованием Celery

Класс CeleryConfig отвечает за настройку фоновой обработки задач с использованием библиотеки Celery. Он включает следующие параметры для конфигурации:

- broker_url – указывает адрес брокера сообщений, например, для использования базы данных SQLite.

- imports – список импортируемых задач, например, для SQL Lab или планировщика.

- result_backend – хранилище для результатов задач (по умолчанию SQLite).

- worker_prefetch_multiplier – количество задач, которые могут быть загружены для одного рабочего процесса.

- task_acks_late – определяет момент подтверждения выполнения задачи (до или после ее завершения).

- task_annotations – настройки для ограничения скорости выполнения задач (например, "100/s" для SQL-запросов).

- beat_schedule – периодические задачи, выполняемые по расписанию (например, выполнение отчетов).

class CeleryConfig: # pylint: disable=too-few-public-methods

broker_url = "sqla+sqlite:///celerydb.sqlite"

imports = ("superset.sql_lab", "superset.tasks.scheduler")

result_backend = "db+sqlite:///celery_results.sqlite"

worker_prefetch_multiplier = 1

task_acks_late = False

task_annotations = {

"sql_lab.get_sql_results": {

"rate_limit": "100/s",

},

}

beat_schedule = {

"reports.scheduler": {

"task": "reports.scheduler",

"schedule": crontab(minute="*", hour="*"),

"options": {"expires": int(CELERY_BEAT_SCHEDULER_EXPIRES.total_seconds())},

},

"reports.prune_log": {

"task": "reports.prune_log",

"schedule": crontab(minute=0, hour=0),

},

}¶ 1.12.9 Форматирование стоимости запросов

Функция postgres_query_cost_formatter демонстрирует, как можно форматировать данные о стоимости запросов для PostgreSQL. Она вычисляет относительную стоимость и определяет её позицию в рамках заранее заданных пороговых значений, возвращая отформатированный результат.

Эта функция полезна для наглядного анализа производительности запросов, показывая, как запросы сравниваются с заранее определёнными уровнями затрат.

# def postgres_query_cost_formatter(

# result: List[Dict[str, Any]]

# ) -> List[Dict[str, str]]:

# # 25, 50, 75% percentiles

# percentile_costs = [100.0, 1000.0, 10000.0]

#

# out = []

# for row in result:

# relative_cost = row["Total cost"]

# percentile = bisect.bisect_left(percentile_costs, relative_cost) + 1

# out.append({

# "Relative cost": relative_cost,

# "Percentile": str(percentile * 25) + "%",

# })

#

# return out¶ 1.12.10 Настройка схем для CTAS-запросов

Настройка SQLLAB_CTAS_SCHEMA_NAME_FUNC позволяет задавать пользовательскую логику определения целевой схемы для операций CREATE TABLE AS (CTAS) в SQL Lab. Она принимает функцию, которая динамически определяет схему назначения на основе переданных параметров, таких как база данных, пользователь, исходная схема и SQL-запрос.

# postgres_query_cost_formatterSQLLAB_CTAS_SCHEMA_NAME_FUNC = lambda database, user, schema, sql: user.username

# This is move involved example where depending on the database you can leverage data

# available to assign schema for the CTA query:

# def compute_schema_name(database: Database, user: User, schema: str, sql: str) -> str:

# if database.name == 'mysql_payments_slave':