Важно: Данный раздел актуален для Платформы данных в Публичном облаке.

¶ 1. Проверка статуса компонентов

¶ 1.1 Проверка статуса zookeeper

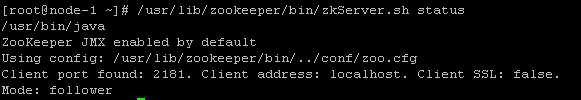

Для проверки статуса zookeeper на каждом хосте, на котором установлен сервис zookeeper server можно воспользоваться командой:

/usr/lib/zookeeper/bin/zkServer.sh statusПри корректно работающем сервисе в выводе должен быть упомянут путь до файла конфигурации, используемый сетевой порт, сетевой адрес/имя, статус SSL и режим работы сервиса (Mode: leader или follower. На одном хосте должен быть режим – leader, на остальных – follower) :

¶ 1.2 Проверка статуса HDFS

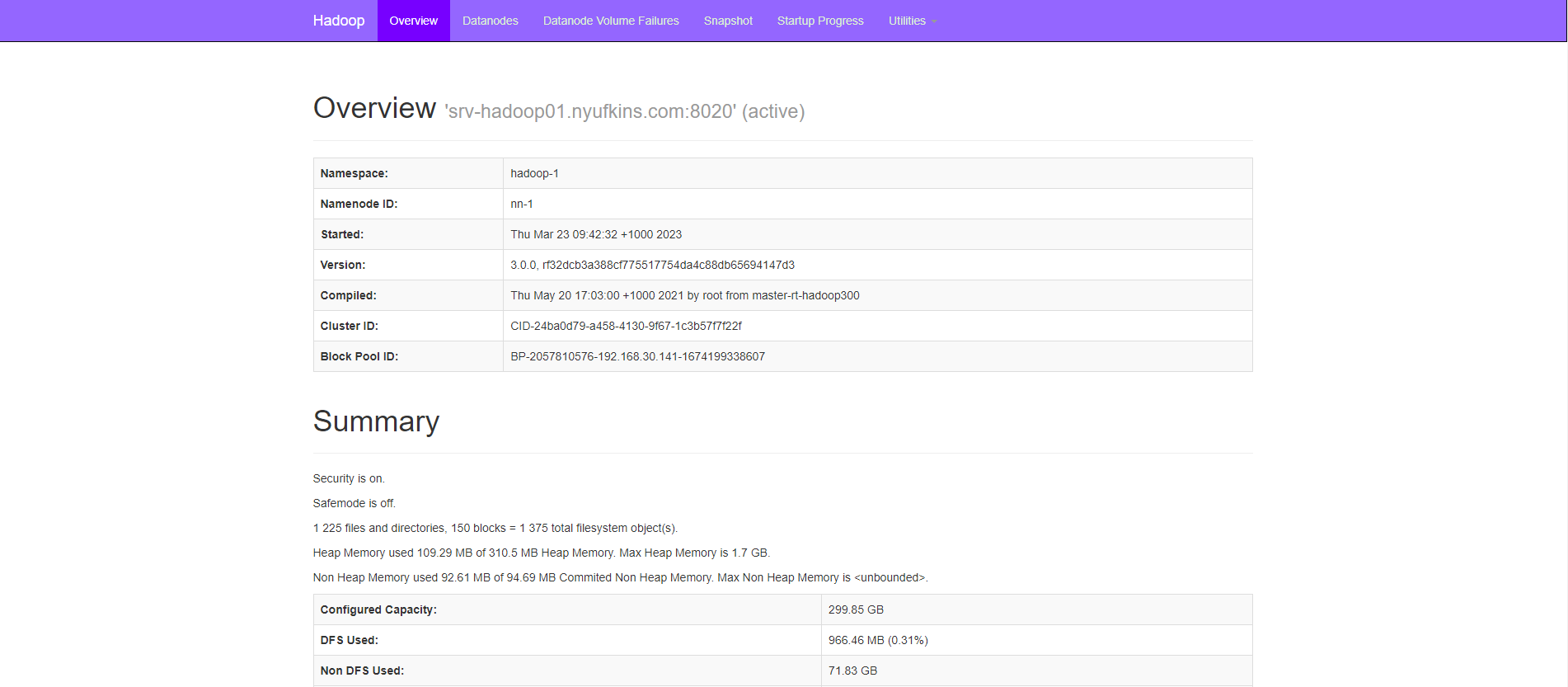

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса namenode по протоколу http (или https в случае включенного режима SSL), порт 9870:

- Работоспособность UI;

- Именное пространство (namespace);

- Статус распределённой файловой системы;

- Работоспособность, статус (состояние керберизации и безопасного режима);

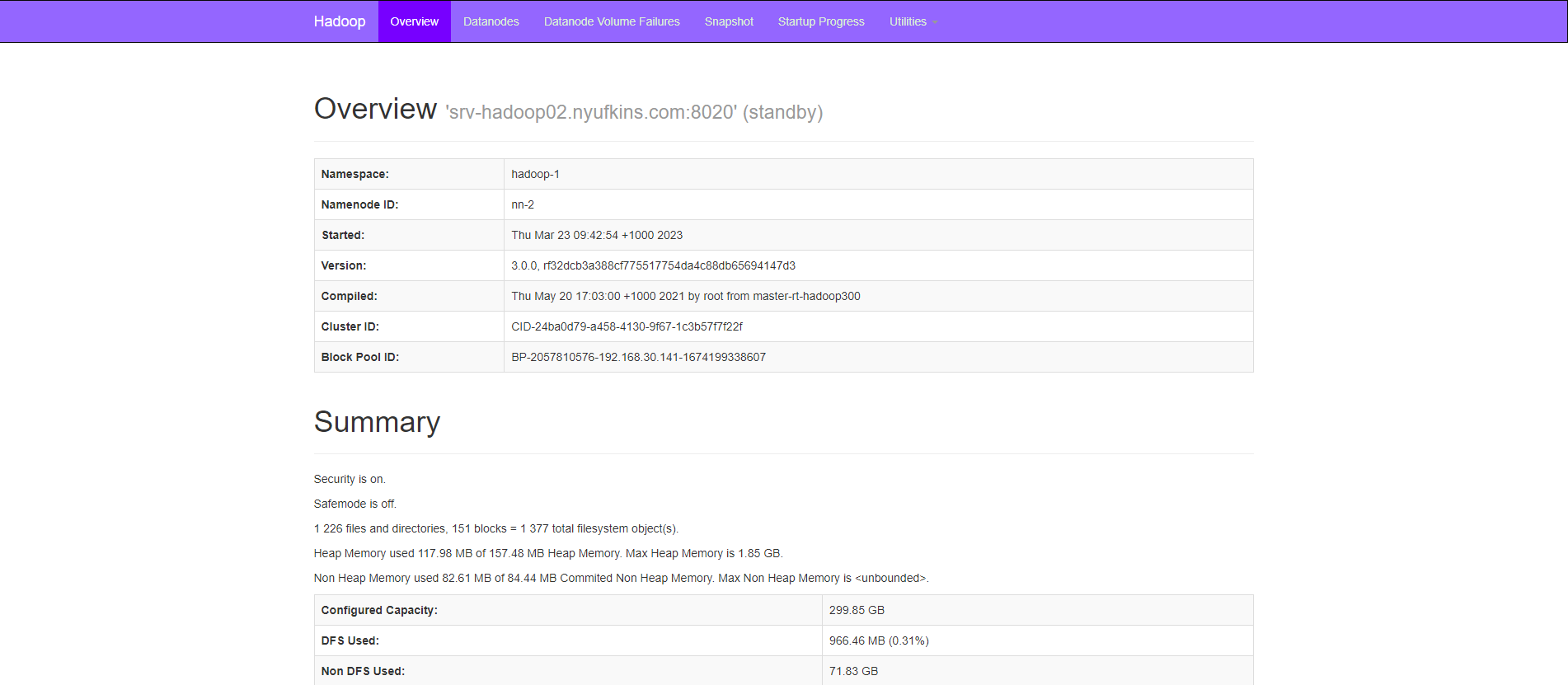

- В случае включенного режима "Высокая доступность" возможно проверить состояние дублирующего сервиса namenode (в режиме standby) на хосте, где так же как на главном хосте компонента HDFS установлен сервис namenode (согласно таблице распределения сервисов по нодам– например, m-2), порт 9870:

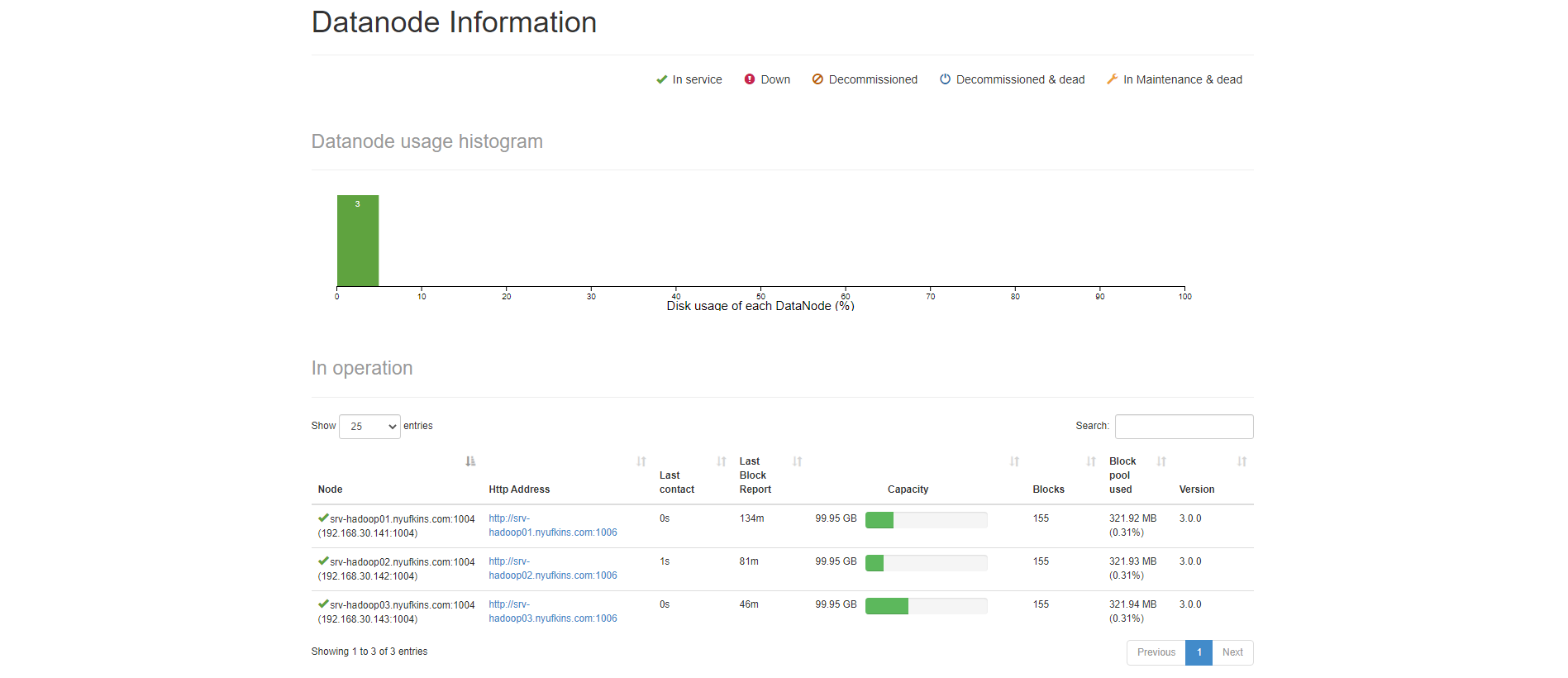

- Состояние заполненности datanodes:

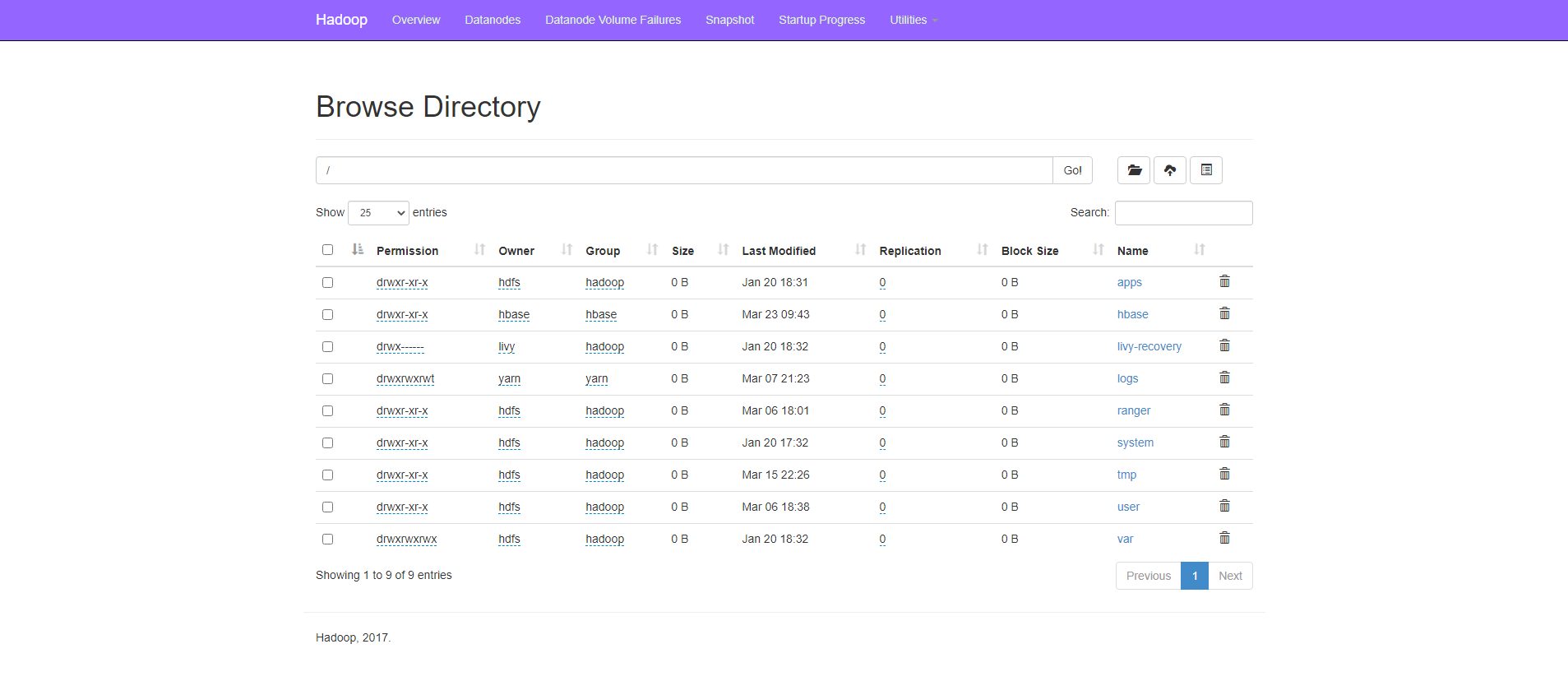

- Просмотр и редактирование файлов и директорий в hdfs:

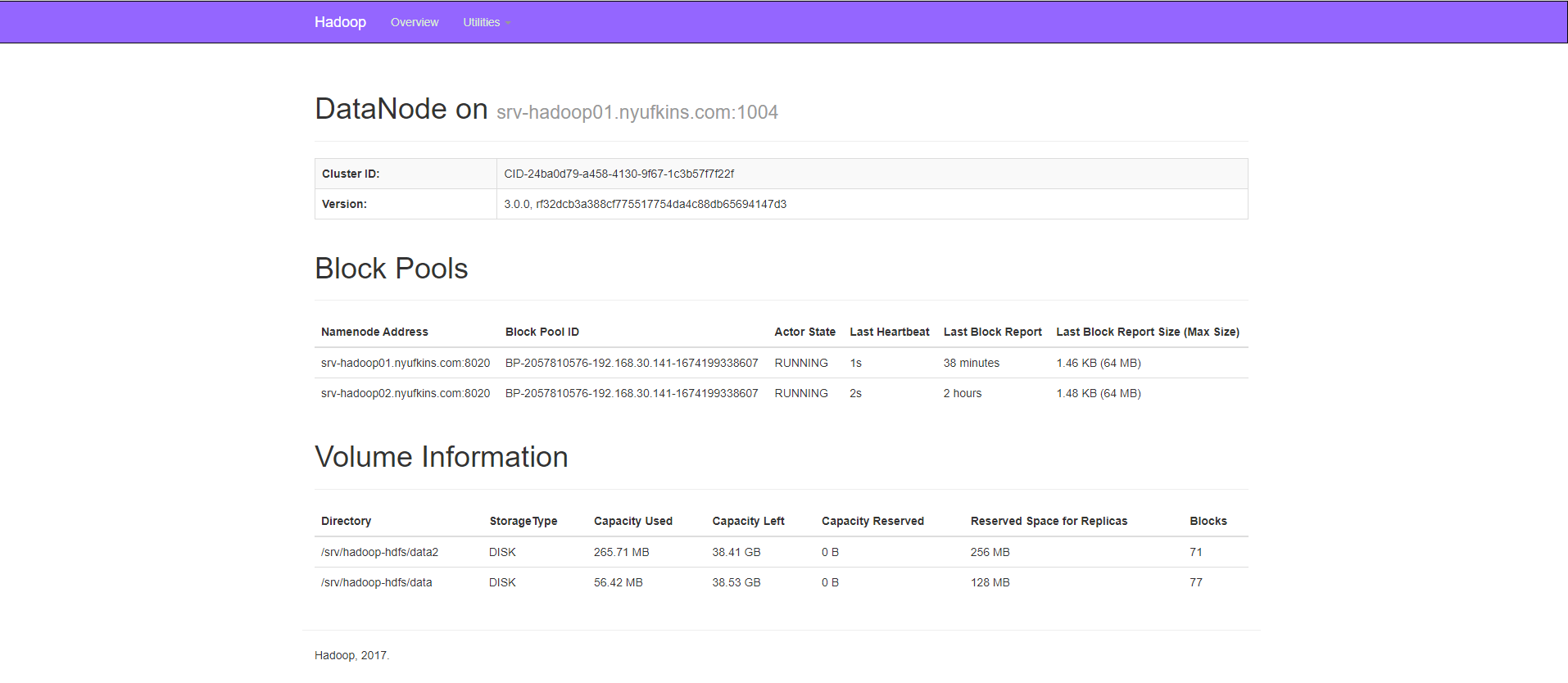

- Графический интерфейс datanode доступен на машинах, где установлен сервис datanode (порт 1006):

В случае выключенного режима "Высокая доступность" возможно проверить состояние вспомогательного сервиса secondarynamenode на хосте, где установлен одноимённый сервис, порт 9868.

¶ 1.3 Проверка статуса Yarn

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса resourcemanager по протоколу http (или https в случае включенного режима SSL), порт 8088:

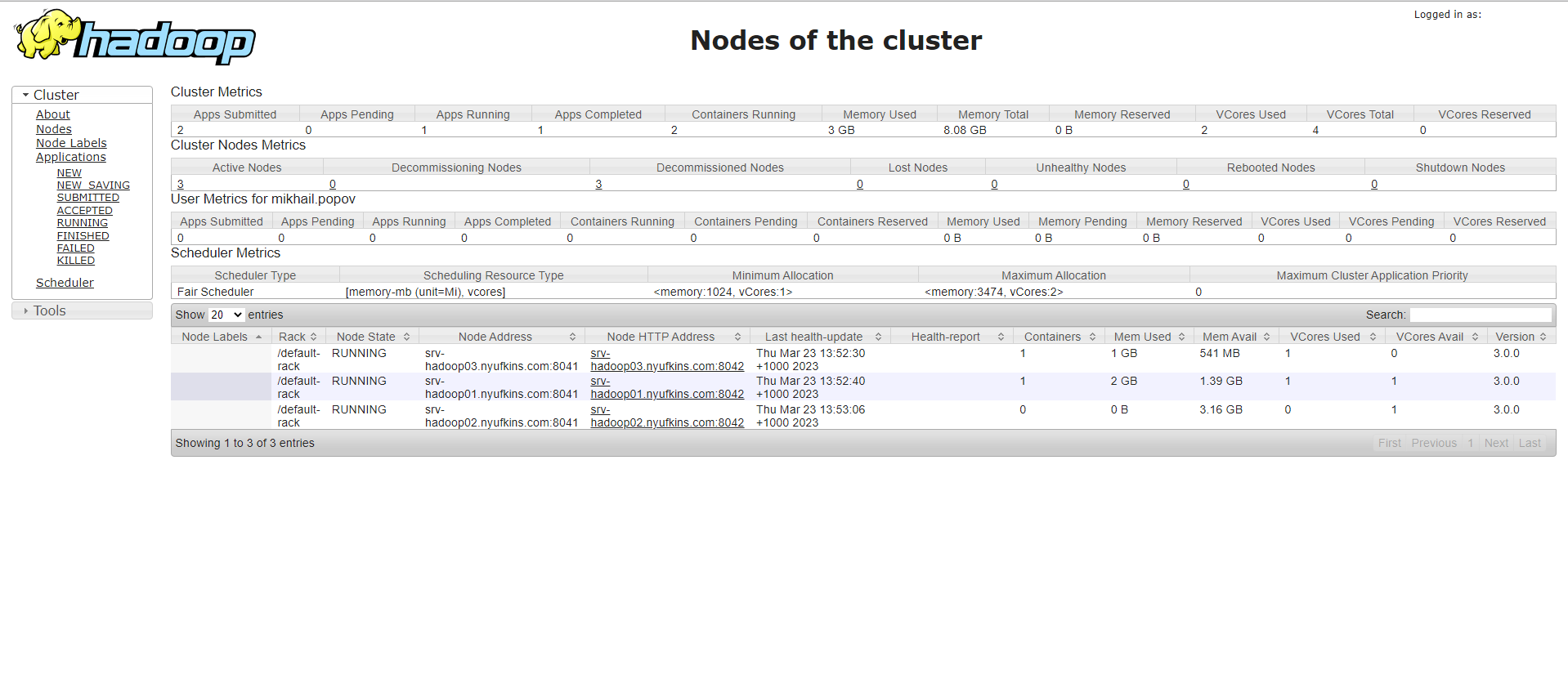

- Состояние подчинённых нод (nodemanagers):

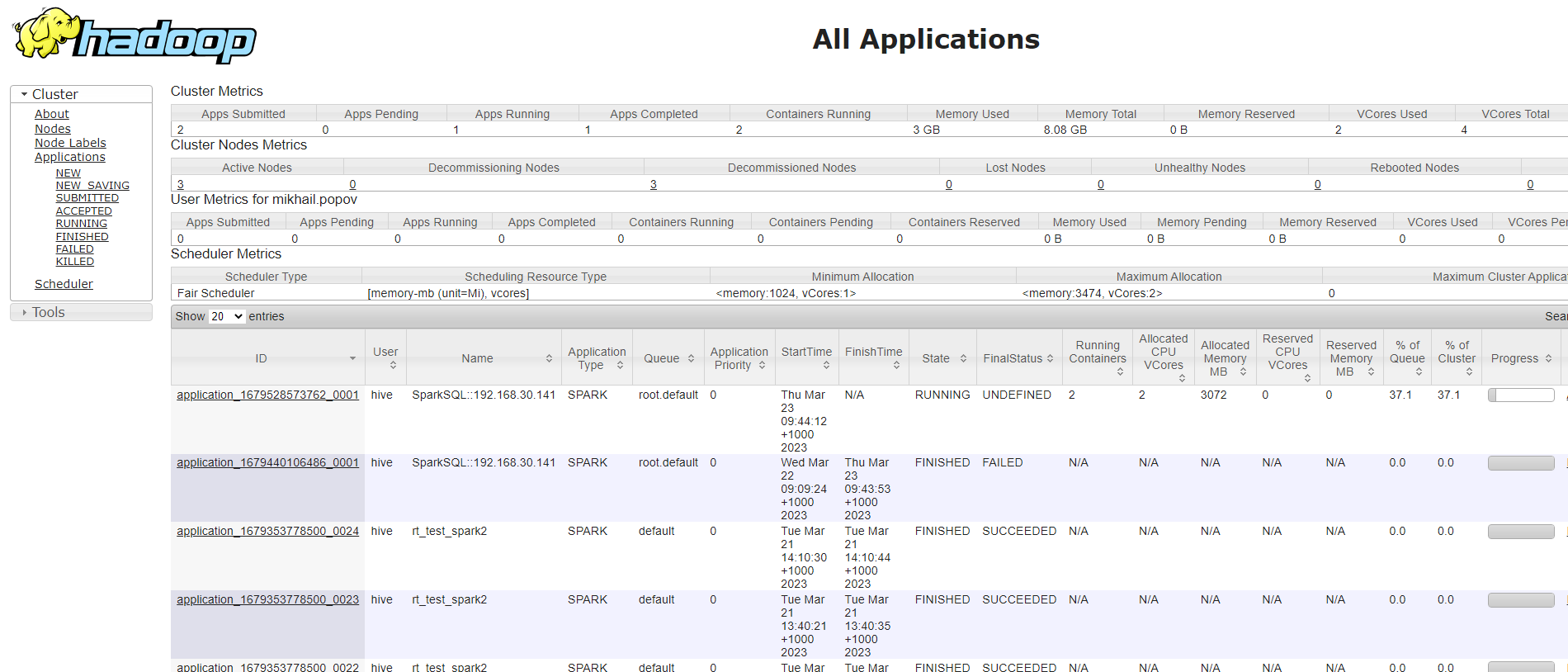

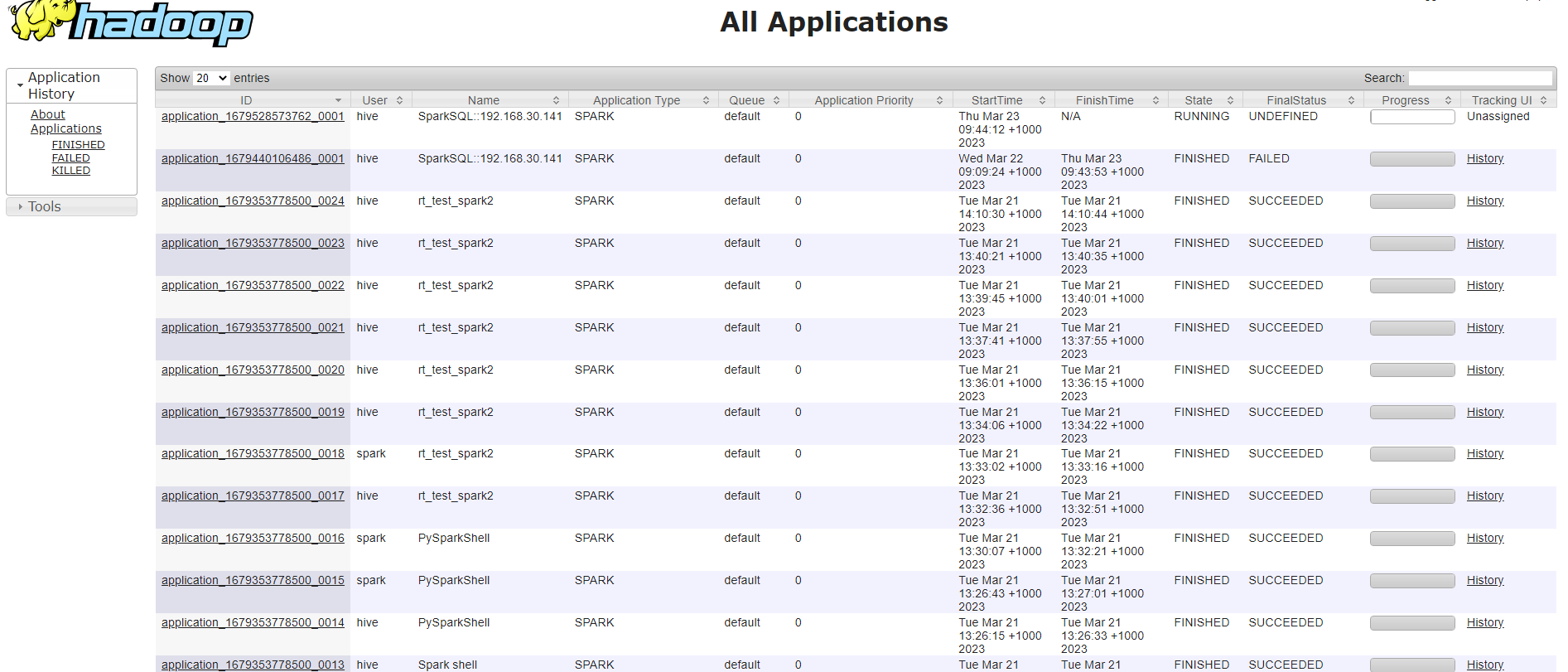

- Перечень всех задач с возможностью фильтровать по выбранному в контекстном меню слева статусу (NEW/NEW SAVING/SUBMITTED/ACCEPTED/RUNNING/FINISHED/FAILED/KILLED):

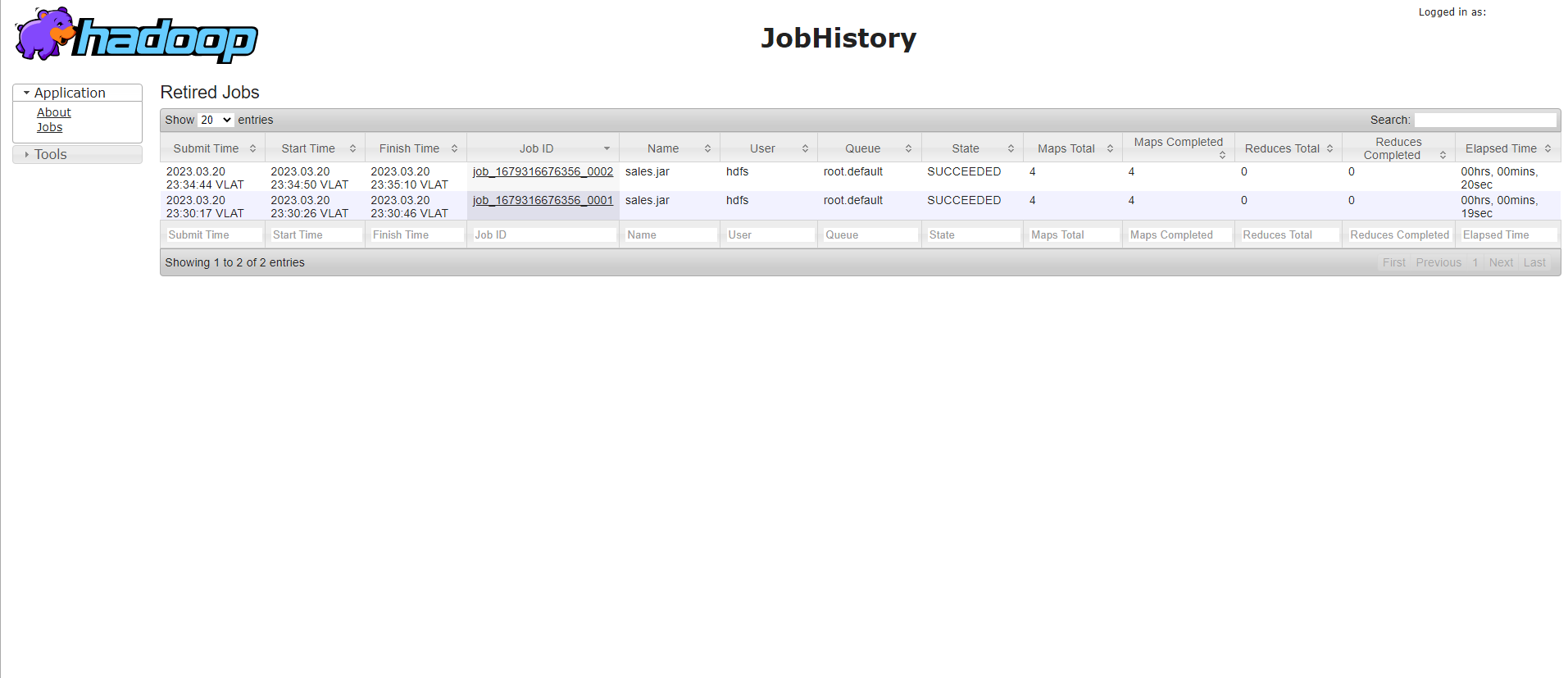

- historyserver, порт 19888:

- timelineserver, порт 8188:

¶ 1.4 Проверка статуса Hive

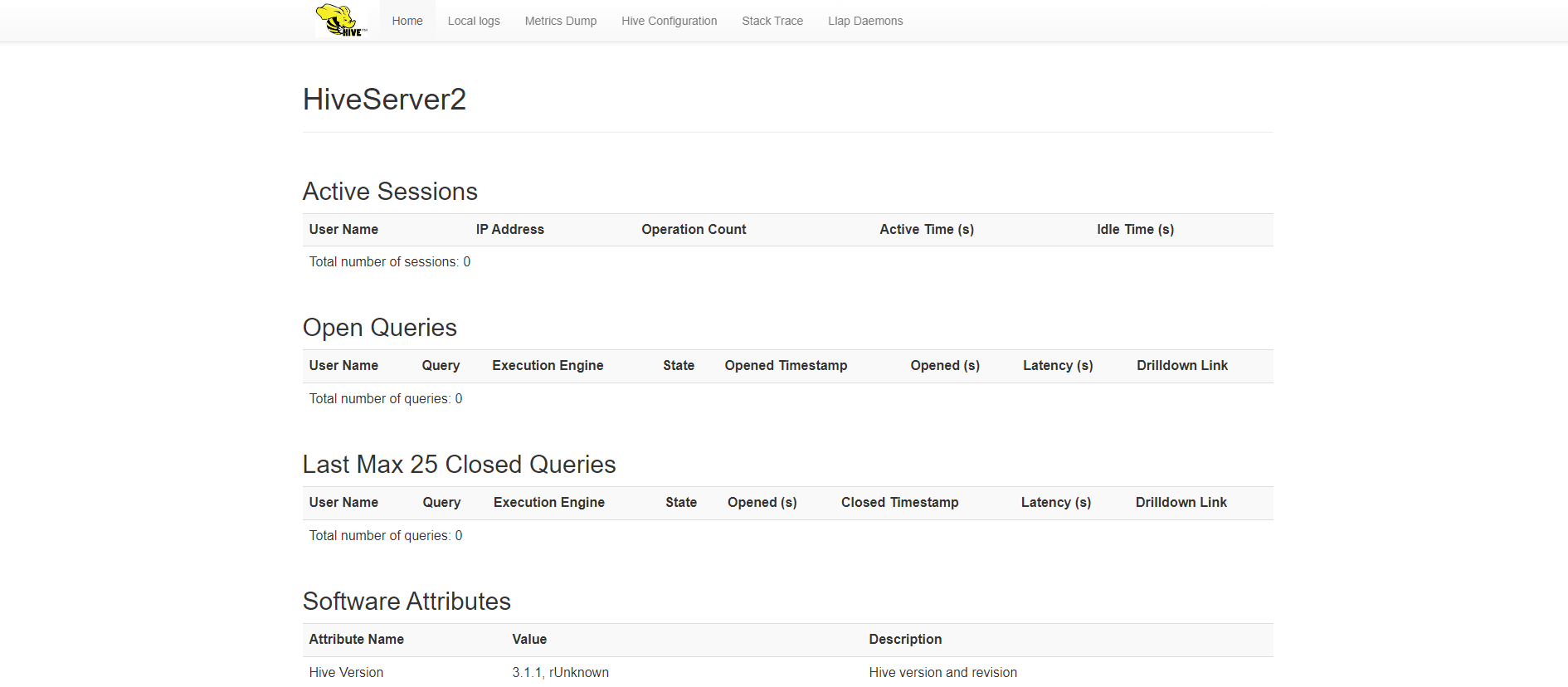

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса hiveserver2 по протоколу http (или https в случае включенного режима SSL), порт 10002:

- Графический интерфейс Hive tez, порт 9999:

¶ 1.5 Проверка статуса HBase

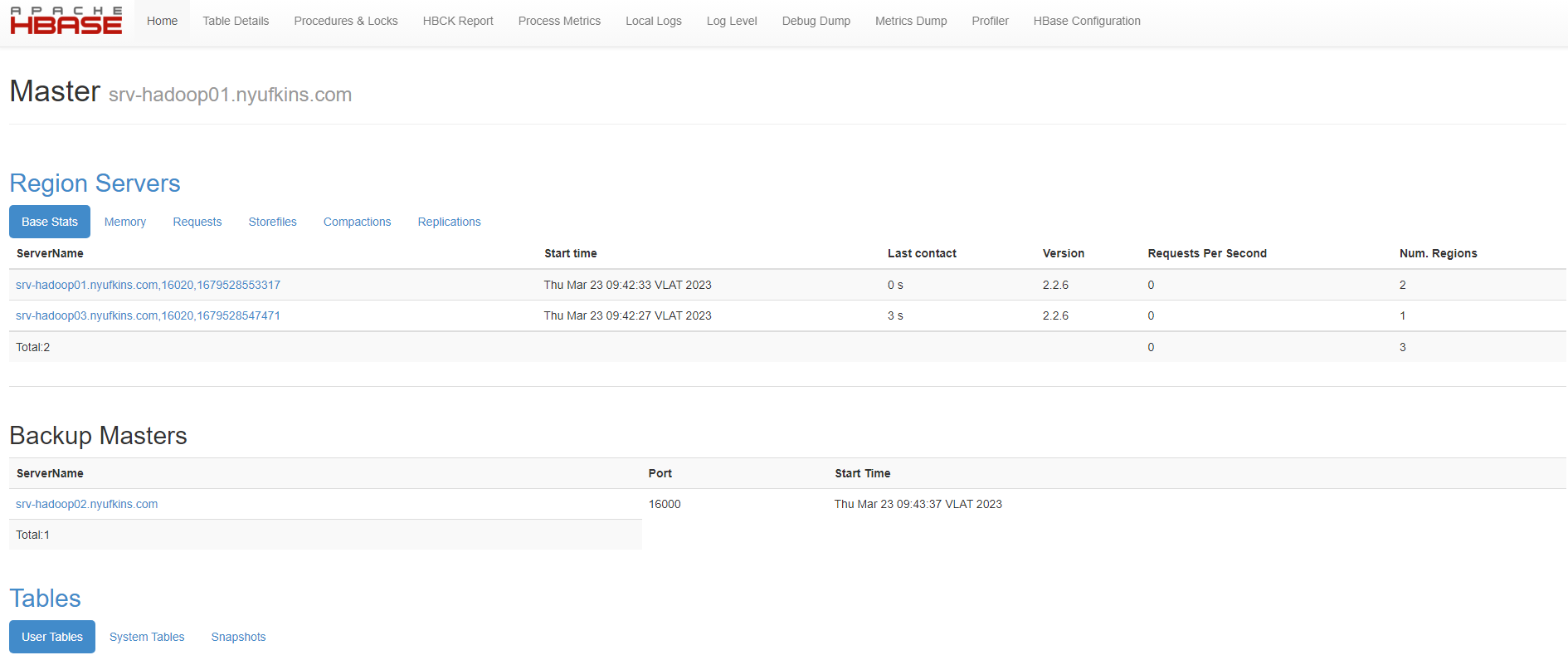

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса HBase master по протоколу http (или https в случае включенного режима SSL), порт 16010:

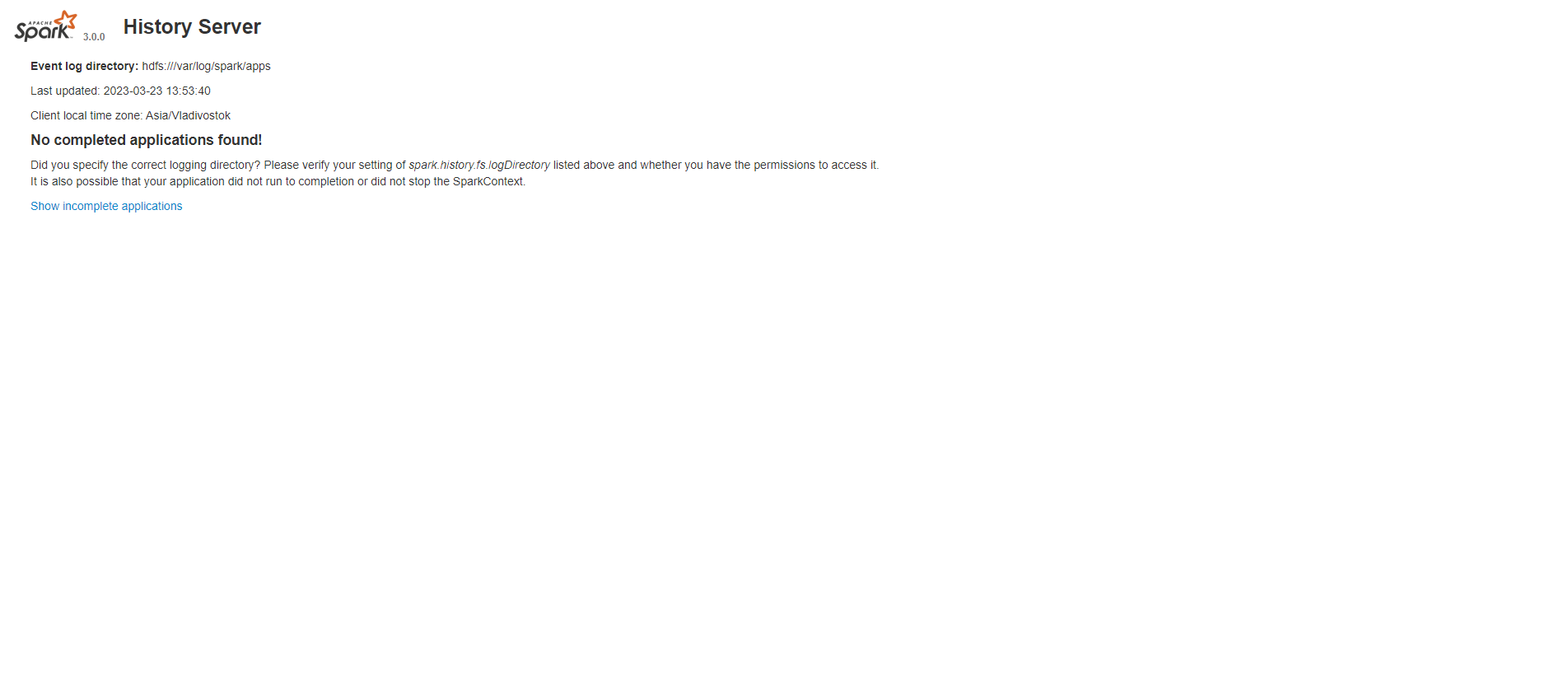

¶ 1.6 Проверка статуса Spark

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса Spark historyserver по протоколу http (или https в случае включенного режима SSL), порт 18082:

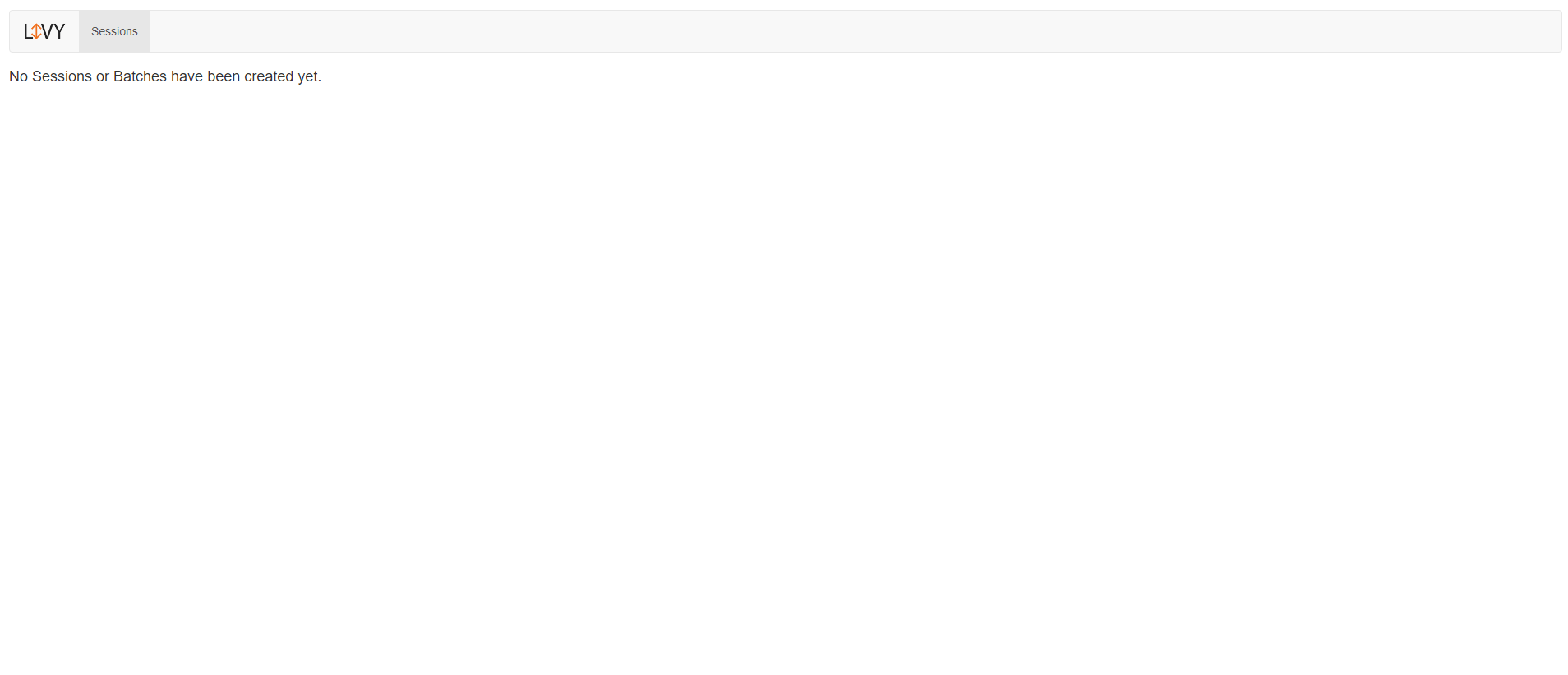

Графический интерфейс Spark livy, порт 8998:

¶ 1.7 Проверка статуса Spark24

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса Spark historyserver по протоколу http (или https в случае включенного режима SSL), порт 18073.

Графический интерфейс Spark livy, порт 8997.

¶ 1.8 Проверка статуса Sqoop

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса Sqoop metastore по протоколу http (или https в случае включенного режима SSL), порт 16100.

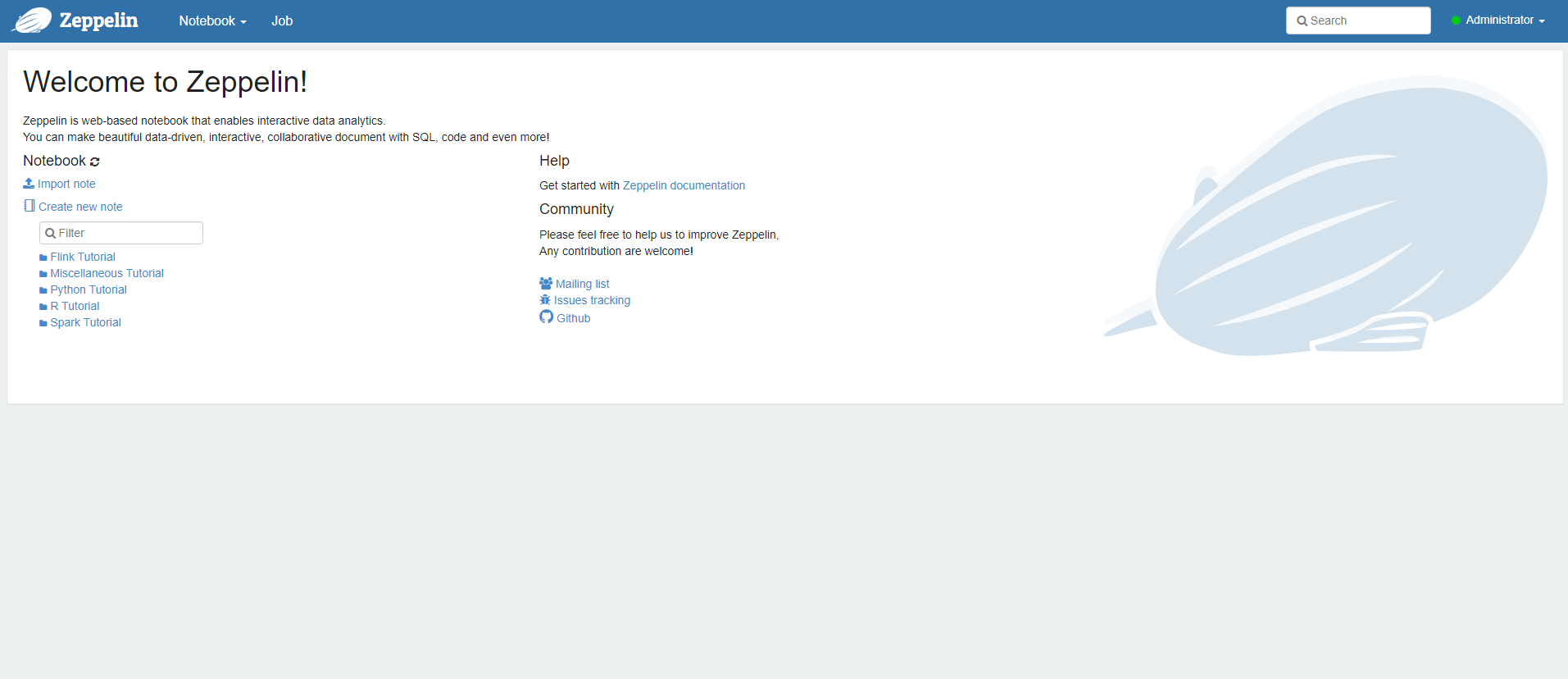

¶ 1.9 Проверка статуса Zeppelin

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса Zeppelin server по протоколу http (или https в случае включенного режима SSL), порт 8180:

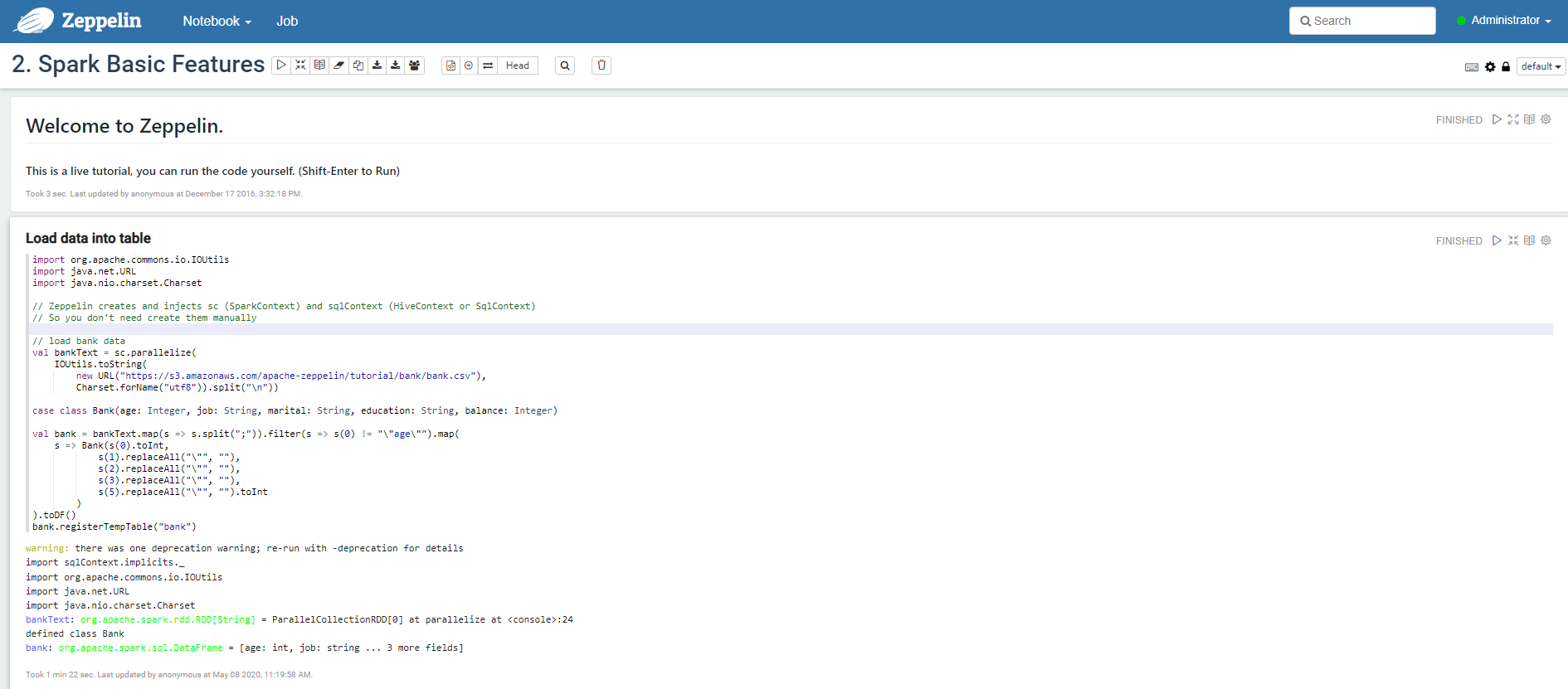

Вкладка Zeppelin Notebook:

¶ 1.10 Проверка статуса Ranger

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса Ranger admin по протоколу http (или https в случае включенного режима SSL), порт 6080 (6182 для https):

Учётные данные по умолчанию

логин: admin

пароль: admin

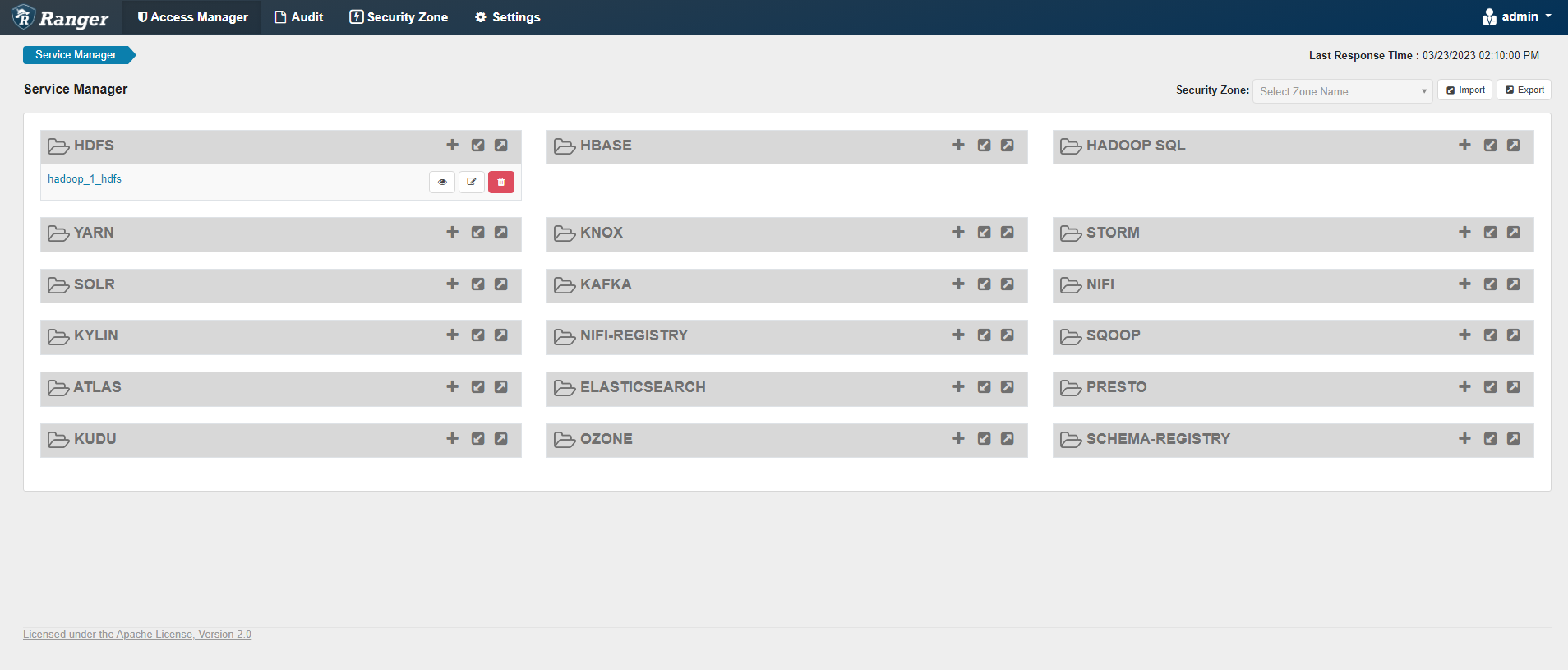

Домашняя страница сервиса:

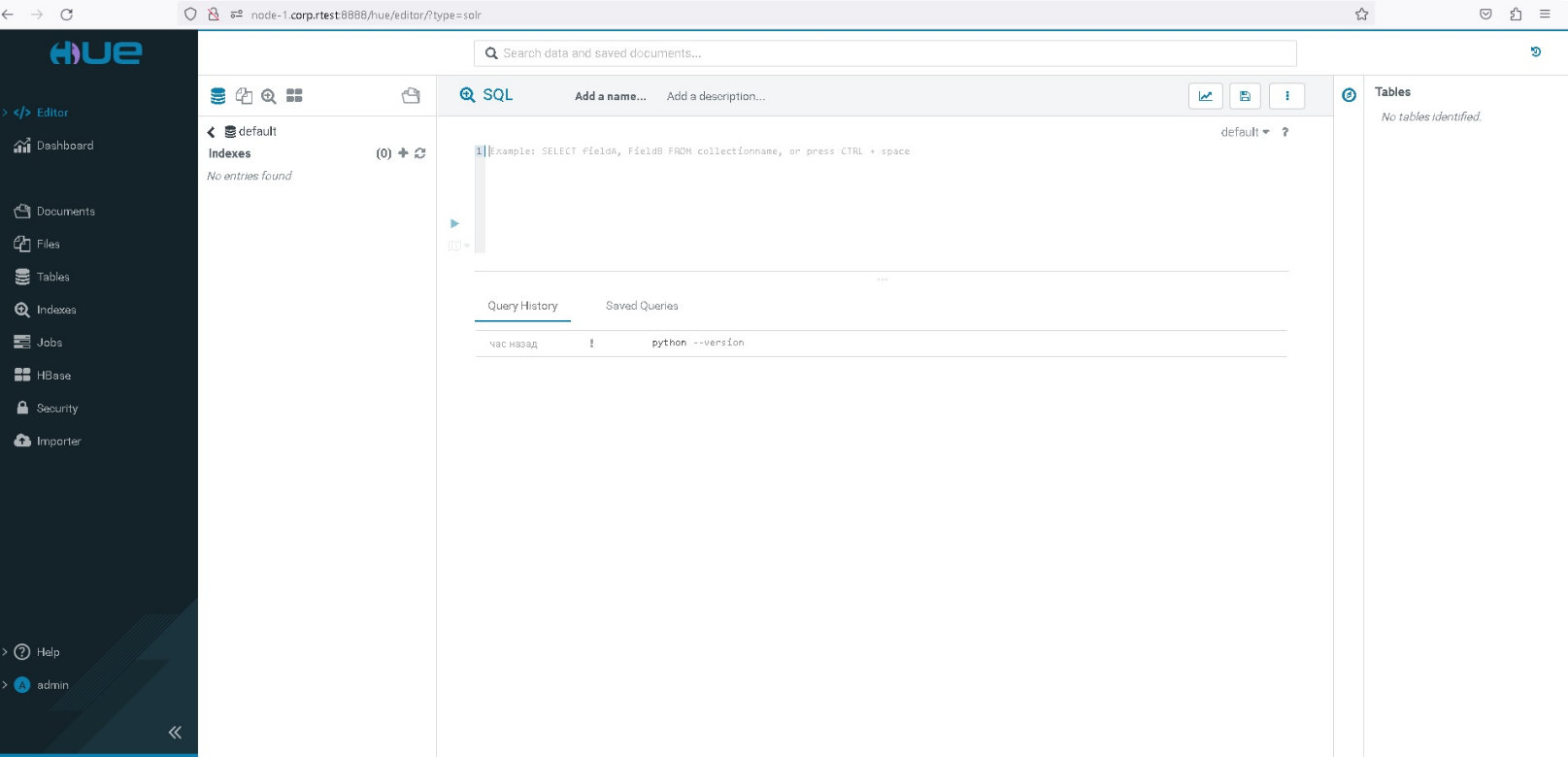

¶ 1.11 Проверка статуса Hue

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса Hue server по протоколу http (или https в случае включенного режима SSL), порт 8888:

Домашняя страница сервиса:

¶ 1.12 Проверка статуса Knox

Доступность сервиса можно проверить как посредством графического интерфейса admin-ui, так и на хосте с установленной компонентой с помощью команды:

По умолчанию сервис расположен на порту 8443

admin

admin-password

Логин и пароль рекомендуем изменить на свои, соответствующие используемой политике безопасности, во вкладке конфигурация компонента Knox

admin-ui:

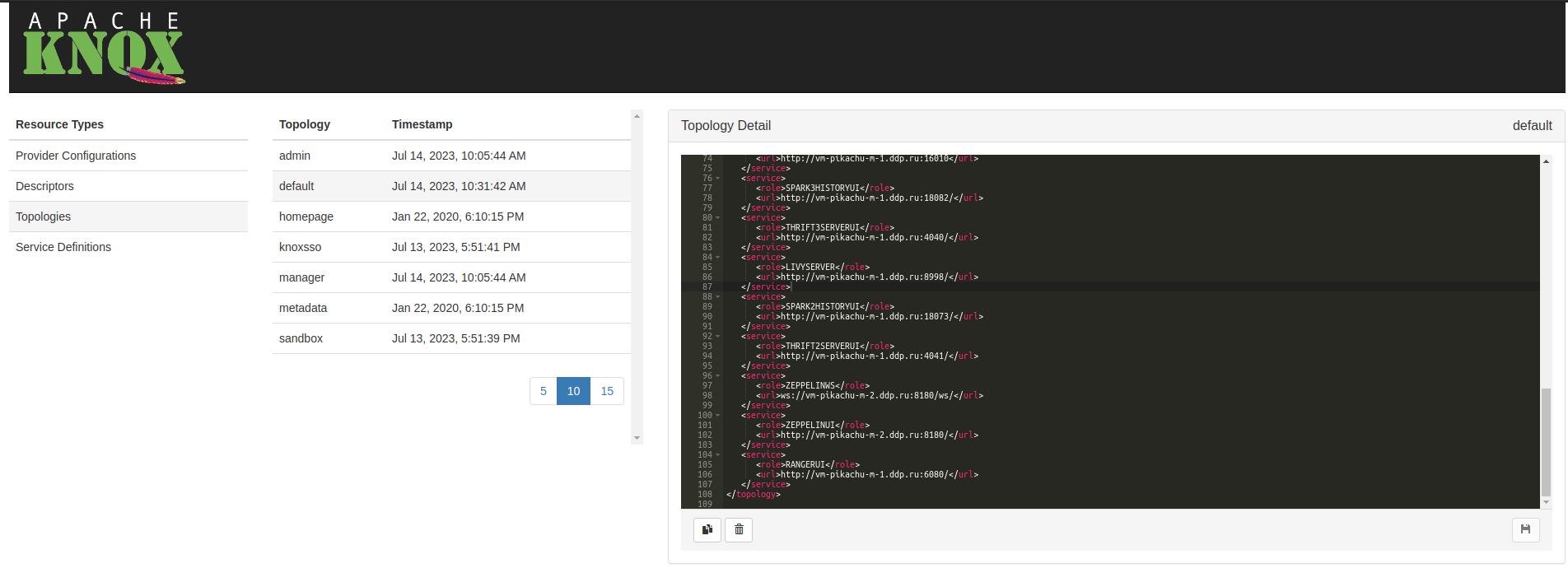

Домашняя страница админ панели:

Доступы в сервисы кластера:

<host> – хост, на котором расположен сервис,

<port> – порт, на котором расположен сервис.

hdfsui:

http://<host>:<port>/gateway/default/hdfs/hdfsui2:

http://<host>:<port>/gateway/default/hdfs2/ hdfsui3:

в сервисе hdfsui3 требуется дополнительно указывать параметры host=<имя хоста namenode> и port=<port namenode>

http://<host>:<port>/gateway/default/hdfs3/?host=<имя хоста namenode>&port=<port namenode>Пример rest api запроса к webhdfs топологии:

curl -k https://vm-pikachu-m-3.ddp.ru:8443/gateway/default/webhdfs/v1/\?op\=LISTSTATUSyarn v1:

http://<host>:<port>/gateway/default/yarn/clusteryarn v2:

http://<host>:<port>/gateway/default/yarnuiv2hiveserver2:

http://<host>:<port>/gateway/default/hiveserver2tez:

https://<host>:<port>/gateway/default/tez/spark3history:

http://<host>:<port>/gateway/default/spark3historyspark2history:

http://<host>:<port>/gateway/default/spark2historyspark2thrift:

http://<host>:<port>/gateway/default/thrift2spark3thrift:

http://<host>:<port>/gateway/default/thrift3livy:

http://<host>:<port>/gateway/default/livyzeppelin:

http://<host>:<port>/gateway/default/zeppelin/ranger:

http://<host>:<port>/gateway/default/ranger/hbase:

в сервисе hbase требуется дополнительно указывать параметры host=<имя хоста hbase> и port=<port hbase>

- hbase master

http://<host>:<port>/gateway/default/hbase/webui/master/master-status?host=<имяхоста hbase master>&port=<port hbase master>- hbase regionserver

https://<host>:<port>/gateway/default/hbase/webui/regionserver/rs-status?host=<имяхоста hbase regionserver>&port=<port hbase regionserver>в случае некорректного запроса к несуществующему сервису будет выдаваться ошибка 500.

¶ 1.13 Проверка статуса Checkeragent

Проверить доступность данного компонента можно посредством графического интерфейса (UI) косвенно устанавливаемого сервиса (в процессе установки zookeeper) checkeragent по протоколу http (или https в случае включенного режима SSL), порт 8118:

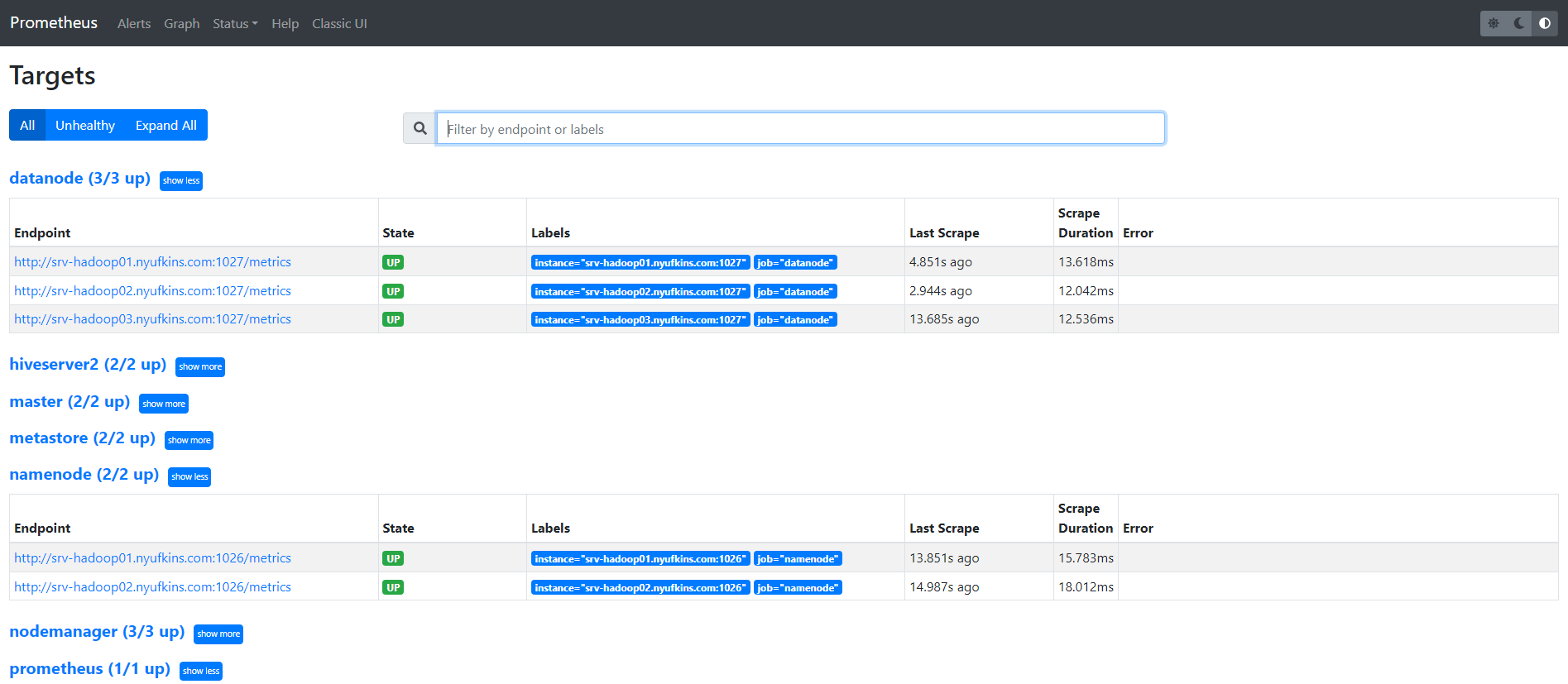

¶ 1.14 Проверка статуса Prometheus

Проверить доступность данного компонента можно посредством графического интерфейса (UI) программы Prometheus, работающей в докер-контейнере, входящем в состав группы контейнеров "rtcm" на докер-хост машине, подготовленной для установки RT.ClusterManager (cm) по протоколу http, порт 9090:

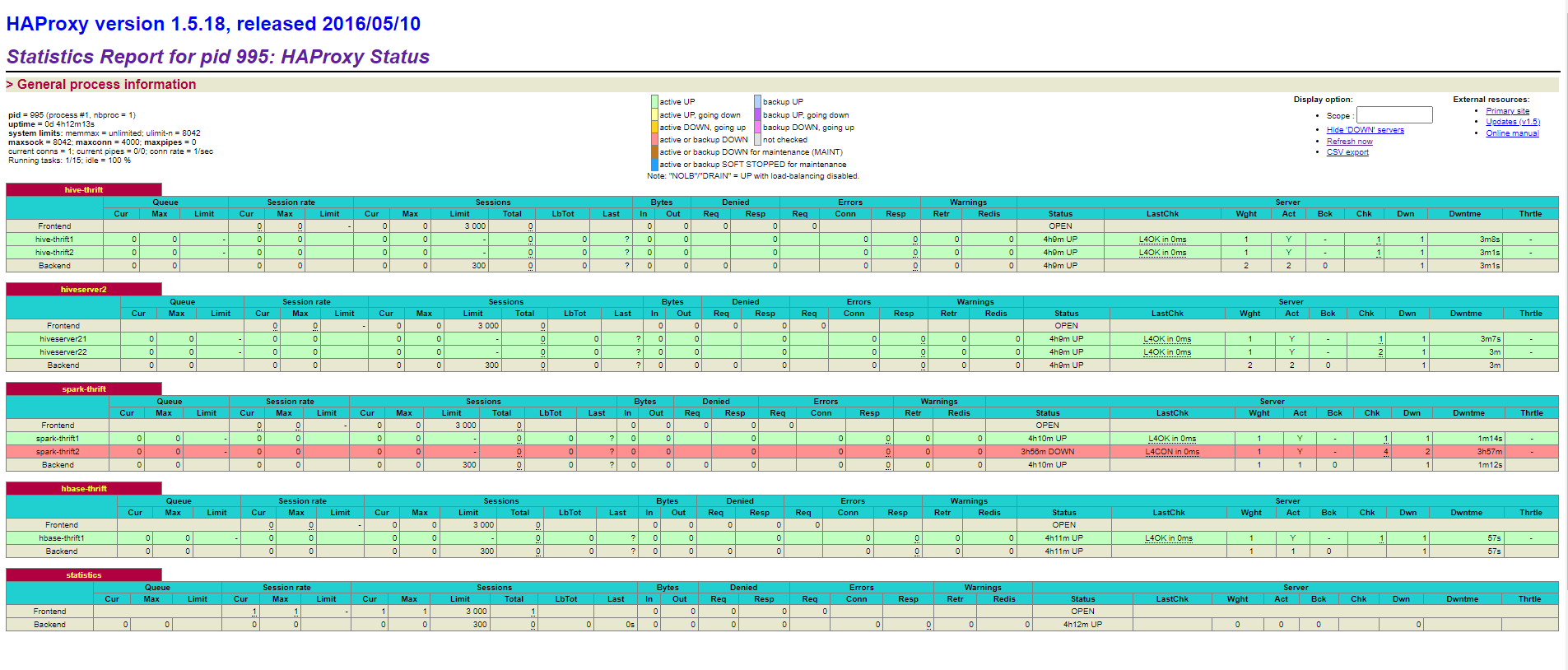

¶ 1.15 Проверка статуса haproxy

Проверить доступность данного компонента можно посредством графического интерфейса (UI) управляющего сервиса haproxy по протоколу http (или https в случае включенного режима SSL), порт 8778:

¶ 2. Настройка компонентов

¶ 2.1 Apache Ranger, настройка аутентификации с помощью LDAP /Active Directory

Авторизованные пользователи Active Directory должны быть настроены для получения доступа к службам и ресурсам, предоставляемым в кластере служб больших данных. Для этого Apache Ranger должен быть настроен таким образом, чтобы пользователи Active Directory могли синхронизироваться с Apache Ranger в службе больших данных. Кроме того, пользователи могут захотеть войти в пользовательский интерфейс Apache Ranger как пользователи Active Directory.

¶ 2.1.1 Для интеграций с пользователями из Active Directory, необходимо указать настройки:

"ranger_ugsync_site": {

...

"ranger.usersync.source.impl.class": "LDAP",

"ranger.usersync.ldap.binddn": "CN=admin,CN=Users,DC=dcp,DC=local", - УЗ администратора AD

"ranger.usersync.ldap.ldapbindpassword": "password", - пароль администратора AD

"ranger.usersync.ldap.url": "ldap://vm-dcp-dc-1.dcp.local:389",

"ranger.usersync.ldap.user.groupnameattribute": "memberOf",

"ranger.usersync.ldap.user.nameattribute": "sAMAccountName",

"ranger.usersync.ldap.user.objectclass": "person",

"ranger.usersync.ldap.user.searchbase": "CN=Users,DC=dcp,DC=local",

"ranger.usersync.ldap.user.searchfilter": "cn=*",

"ranger.usersync.ldap.user.searchscope": "sub",

"ranger.usersync.ldap.username.caseconversion": "lower",

"ranger.usersync.group.memberattributename": "member",

"ranger.usersync.group.nameattribute": "cn",

"ranger.usersync.group.objectclass": "group",

"ranger.usersync.group.search.first.enabled": false,

"ranger.usersync.group.searchbase": "CN=Groups,DC=dcp,DC=local",

"ranger.usersync.group.hierarchylevels": 2,

"ranger.usersync.group.searchenabled": true,

"ranger.usersync.group.searchfilter": "cn=*",

"ranger.usersync.group.searchscope": "sub",

"ranger.usersync.group.usermapsyncenabled": true

},¶ 2.1.2 Настройки для авторизаций в веб интерфейсе ranger admin:

"ranger_admin_site": {

...

"ranger.authentication.method": "LDAP",

...

"ranger.ldap.base.dn": "DC=dcp,DC=local",

"ranger.ldap.bind.dn": "admin@ad.local",

"ranger.ldap.bind.password": "password",

"ranger.ldap.group.roleattribute": "cn",

"ranger.ldap.group.searchbase": "DC=dcp,DC=local",

"ranger.ldap.group.searchfilter": "(|(CN=production))",

"ranger.ldap.referral": "ignore",

"ranger.ldap.url": "ldap://vm-dcp-dc-1.dcp.local:389",

"ranger.ldap.user.dnpattern": "sAMAccountName={0}",

"ranger.ldap.user.searchfilter": "sAMAccountName={0}"

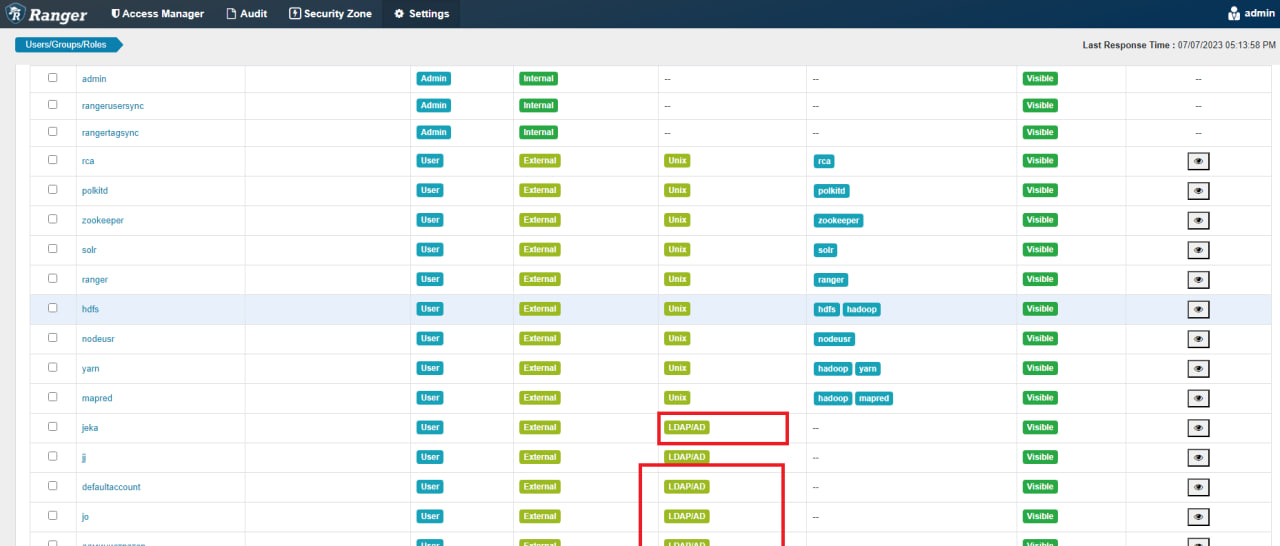

},¶ 2.1.3 Проверка результата:

¶ 2.1.4 Настройки в RT.ClusterManager

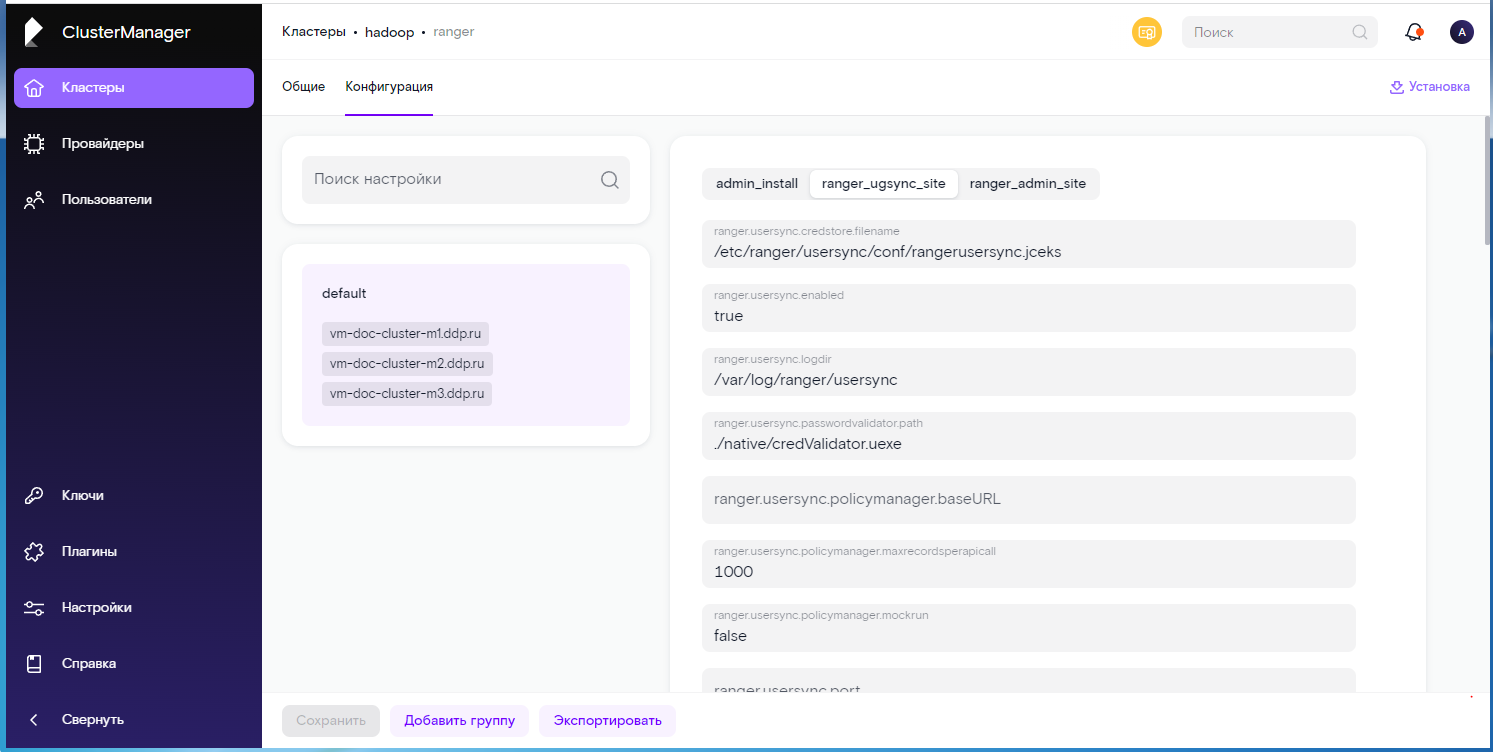

Настройки “ranger_ugsync_site” и “ranger_admin_site” из п. 4.1.1 и п. 4.1.2 должны быть проставлены в RT.ClusterManager в настройке конфигурации компонента Ranger (см. п. 8.4.3 документа “RT.ClusterManager. Руководство администратора”), во вкладках соответствующих названиям (см. Рисунок ниже).

Для вступление в действие настроек в RT.ClusterManager необходимо выполнить операцию “Переконфигурировать" (см. п. 8.4.5 документа “RT.ClusterManager. Руководство администратора”).