Важно: Данный раздел актуален для Платформы данных On-Premise.

¶ 1. ОБЩИЕ СВЕДЕНИЯ

Информация об установке, настройке и обновлении программного обеспечения RT.Warehouse и настройке хост-компьютеров RT.Warehouse.

¶ 2. ТРЕБОВАНИЯ RT.WAREHOUSE

В этом разделе описаны требования к платформе RT.Warehouse и программному обеспечению операционной системы.

¶ 2.1 Требования к операционной системе

RT.Warehouse работает на следующих платформах операционных систем:

- CentOS 64-бит 7.x.

- CentOS 64-бит 6.x.

- РЕД ОС 7.

- Astra linux 1.7.3 (в редакции “Воронеж”)

Сервер RT.Warehouse поддерживает TLS версии 1.2 в системах РЕД ОС, RHEL/CentOS.

¶ 2.2 Требования к программному обеспечению

RT.Warehouse требует следующих программных пакетов в системах РЕД ОС, RHEL/CentOS, которые устанавливаются автоматически в качестве зависимостей при установке RPM-пакета RT.Warehouse:

- apr;

- apr-util;

- bash;

- bzip2;

- curl;

- krb5;

- libcurl;

- libevent;

- libxml2;

- libyaml;

- zlib;

- openldap;

- openssh;

- openssl;

- openssl-libs (RHEL7/Centos7);

- perl;

- readline;

- rsync;

- sed (used by gpinitsystem);

- tar;

- zip.

RT.Warehouse использует Python 2.7.12, который включён в установку продукта (и не устанавливается как зависимость пакета).

|

Внимание. SSL можно использовать только на хосте мастера системы RT.Warehouse. SSL нельзя использовать на хостах сегментов системы. |

|

Внимание. Для всех хостов системы RT.Warehouse необходимо отключить SELinux. Вам также следует отключить программное обеспечение файрвола, хотя программное обеспечение файрвола можно включить, если это требуется в целях безопасности. См. Отключение программного обеспечения SELinux и файрвола. |

¶ 2.3 Требования к JDK

RT.Warehouse может использовать следующие версии Java для PL/Java и PXF:

- Open JDK 8 или Open JDK 11, доступный на AdoptOpenJDK.

¶ 2.4 Требования к оборудованию и сети

В следующей таблице перечислены минимальные рекомендуемые спецификации для аппаратных серверов, предназначенных для поддержки RT.Warehouse в системах Linux.

Все хост-серверы в вашей системе RT.Warehouse должны иметь одинаковую конфигурацию оборудования и программного обеспечения.

Таблица 1— Минимальные требования к оборудованию

|

Наименование |

Значение |

|---|---|

| CPU | Любой CPU, совместимый с x86_64. Не менее 4 ядер на хост |

| RAM | Не менее 16 ГБ RAM на сервер. |

| Дисковое пространство |

|

| Сеть |

|

¶ 2.5 Требования к хранилищу

RT.Warehouse следует запускать в файловой системе XFS.

RT.Warehouse может работать в сети или в общем хранилище, если общее хранилище представлено как блочное устройство серверам, на которых запущен RT.Warehouse, а файловая система XFS смонтирована на блочном устройстве. Использование сетевых файловых систем не рекомендуется. При использовании сетевого или общего хранилища необходимо использовать зеркальное отображение RT.Warehouse так же, как и локальное хранилище, и не следует вносить никаких изменений в схему зеркального отображения или схему восстановления сегментов.

Другие функции общего хранилища, такие как дедупликация и/или репликация, могут использоваться с RT.Warehouse, если они не мешают ожидаемой работе RT.Warehouse.

RT.Warehouse может быть развёрнут в виртуализированных системах только в том случае, если хранилище представлено как блочные устройства, а файловая система XFS смонтирована для хранения каталогов сегментов.

RT.Warehouse может работать на серверах Amazon Web Services (AWS) с использованием хранилища экземпляров Amazon (Amazon использует имена томов ephemeral[0-20]) или хранилища Amazon Elastic Block Store (Amazon EBS). При использовании хранилища Amazon EBS хранилище должно представлять собой RAID томов Amazon EBS и подключаться к файловой системе XFS.

¶ 2.6 Распределения Hadoop

RT.Warehouse обеспечивает доступ к HDFS с помощью Platform Extension Framework (PXF).

PXF v5.8.1 интегрирован с RT.Warehouse и обеспечивает доступ к Hadoop, хранилищу объектов и внешним хранилищам данных SQL.

PXF может использовать Cloudera, Hortonworks Data Platform, MapR и общие дистрибутивы Apache Hadoop.

PXF объединяет все файлы JAR, от которых он зависит, включая следующие библиотеки Hadoop:

- Hadoop версии 2.9.2;

- Hive версии 1.2.2;

- HBase версии 1.3.2.

|

Примечание. Если вы планируете получить доступ к данным в формате JSON, хранящимся в кластере Cloudera Hadoop, для PXF требуется дистрибутив Hadoop Cloudera версии 5.8 или более поздней. |

¶ 3 АРХИТЕКТУРА RT.WAREHOUSE

Ниже представлен общий обзор архитектуры системы RT.Warehouse.

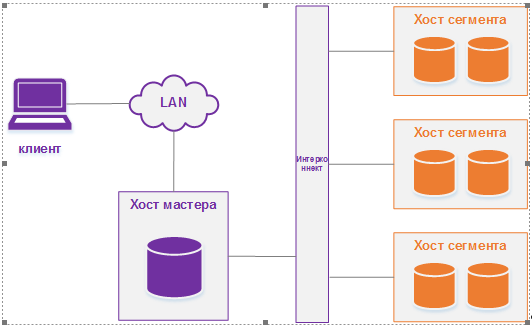

RT.Warehouse хранит и обрабатывает большие объёмы данных, распределяя нагрузку между несколькими хостами. Логически RT.Warehouse — это массив отдельных баз данных PostgreSQL, работающих вместе для представления единого образа базы данных.

Мастер — это точка входа в систему RT.Warehouse. Это инстанс базы данных, к которому пользователи подключаются и отправляют команды SQL. Мастер координирует рабочую нагрузку в других инстансах базы данных в системе, называемых Сегментами, которые обрабатывают и хранят данные.

Сегменты связываются друг с другом и с мастером через Интерконнект, сетевой уровень RT.Warehouse.

RT.Warehouse — это только программное решение. Аппаратное обеспечение и программное обеспечение базы данных не связаны.

RT.Warehouse работает на различных серверных платформах от сертифицированных поставщиков оборудования. Производительность зависит от оборудования, на котором он установлен.

Поскольку база данных распределена по нескольким машинам в системе RT.Warehouse, правильный выбор и конфигурация оборудования важны для достижения максимальной производительности.

В этом разделе описываются основные компоненты системы RT.Warehouse, а также соображения и концепции оборудования, связанные с каждым компонентом: Мастер, Сегменты и Интерконнект. Кроме того, в системе могут быть дополнительные Хосты ETL для загрузки данных и #topic_e5t_whm_kbb для мониторинга рабочей нагрузки и производительности запросов.

¶ 3.1 Мастер

¶ 3.1.1 Основной мастер

Мастер — это точка входа в систему RT.Warehouse. Это процесс сервера базы данных, который принимает клиентские соединения и обрабатывает команды SQL, которые передают пользователи системы. Пользователи подключаются к RT.Warehouse через мастера с помощью клиентской программы, совместимой с PostgreSQL, например, psql или ODBC-приложение.

Мастер ведёт системный каталог (набор системных таблиц, содержащих метаданные о самой системе RT.Warehouse), однако мастер не содержит никаких пользовательских данных. Данные хранятся только на сегментах. Мастер аутентифицирует клиентские соединения, обрабатывает входящие команды SQL, распределяет рабочую нагрузку между сегментами, координирует результаты, возвращаемые каждым сегментом, и представляет окончательные результаты клиентской программе.

Поскольку мастер не содержит никаких пользовательских данных, он имеет очень небольшую нагрузку на диск. Для мастера требуется быстрый выделенный ЦПУ для загрузки данных, обработки соединений и планирования запросов, поскольку часто требуется дополнительное пространство для загрузки файлов загрузки и файлов резервных копий, особенно в производственных средах. Клиенты могут также решить запустить ETL и инструменты отчётности на мастере, что требует большего дискового пространства и вычислительной мощности.

¶ 3.1.2 Резервный мастер

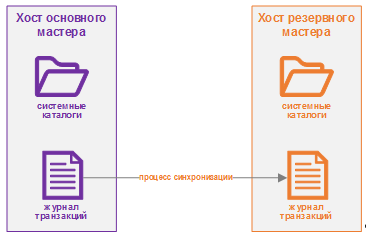

При желании вы можете развернуть резервную копию или зеркало инстанса мастера. Резервный мастер служит в качестве горячего резерва, если основной мастер становится неработоспособным. Вы можете развернуть резервный мастер на назначенном хосте резервного мастера или на одном из хостов сегментов.

Резервный мастер поддерживается в актуальном состоянии с помощью процесса репликации журнала транзакций, который выполняется на резервном мастере и синхронизирует данные между основным мастером и резервным мастером. Если основной мастер выходит из строя, процесс репликации журнала завершается, и администратор может активировать резервный мастер вместо него. Когда резервный мастер активен, реплицированные журналы используются для восстановления состояния основного мастера на момент последней успешно зафиксированной транзакции.

Поскольку мастер не содержит никаких пользовательских данных, необходимо синхронизировать только таблицы системного каталога между основной и резервной копиями. Когда эти таблицы обновятся, изменения автоматически будут скопированы на резервный мастер, поэтому он всегда синхронизирован с основным.

¶ 3.2 Сегменты

¶ 3.2.1 Основные сегменты

В RT.Warehouse в сегментах хранятся данные и выполняется большая часть обработки запросов. Пользовательские таблицы и их индексы распределяются по доступным сегментам в системе RT.Warehouse. Каждый сегмент содержит отдельную часть данных. Инcтансы сегментов — это процессы сервера базы данных, которые обслуживают сегменты. Пользователи не взаимодействуют напрямую с сегментами в системе RT.Warehouse, а делают это через мастера.

В эталонных конфигурациях оборудования RT.Warehouse количество инстансов сегментов на сегмент-хост определяется количеством эффективных CPU или ядер CPU. Например, если сегмент-хост имеет два двухъядерных процессора, вы можете расположить два или четыре основных сегмента на хосте. Если сегмент-хост имеет три четырехъядерных процессора, вы можете расположить три, шесть или двенадцать сегментов на хосте. Тестирование производительности поможет выбрать лучшее количество сегментов для выбранной аппаратной платформы.

¶ 3.2.2 Резервные сегменты

При развёртывании системы RT.Warehouse у вас есть возможность настроить зеркальные сегменты. Зеркальные сегменты позволяют запросам базы данных переключаться на резервный сегмент, если основной сегмент становится недоступным.

Зеркальный сегмент всегда должен находиться на другом хосте, нежели его основной сегмент. Зеркальные сегменты могут быть расположены по хостам в системе в одной из двух стандартных конфигураций или в пользовательской конфигурации, которую вы создаёте. Конфигурация по умолчанию, называемая групповым зеркалированием, размещает зеркальные сегменты для всех основных сегментов одного хоста на другом хосте. Другой вариант, называемый распределённым зеркалированием, распределяет зеркала для основных сегментов каждого хоста по остальным хостам. Распределённое зеркалирование требует, чтобы в системе было больше хостов, чем основных сегментов на хосте. На хостах с несколькими сетевыми интерфейсами основной и зеркальный сегменты равномерно распределяются между интерфейсами.

На рисунке ниже показано, как таблицы данных распределяются по сегментам при настройке параметра группового зеркалирования по умолчанию.

¶ 3.2.3 Отказоустойчивость сегментов и восстановление

Если в системе RT.Warehouse включено зеркалирование, система автоматически переключается на зеркальную копию, если основная копия становится недоступной. Система RT.Warehouse может оставаться работоспособной в случае отказа инстанса сегмента или хоста, только если все части данных доступны на оставшихся активных сегментах.

Если мастеу не удаётся подключиться к инстансу сегмента, он отмечает этот инстанс сегмента как недействительный в системном каталоге RT.Warehouse. Инстанс сегмента остаётся недействительным и не работает, пока администратор не вернёт этот сегмент обратно онлайн. Администратор может восстановить отказавший сегмент, пока система работает. В процессе восстановления копируются только те изменения, которые были пропущены, пока сегмент не работал.

Если у вас не включено зеркалирование и сегмент становится недействительным, система автоматически выключается. Перед продолжением операций администратор должен восстановить все отказавшие сегменты.

¶ 3.2.4 Пример аппаратного стека хоста сегмента

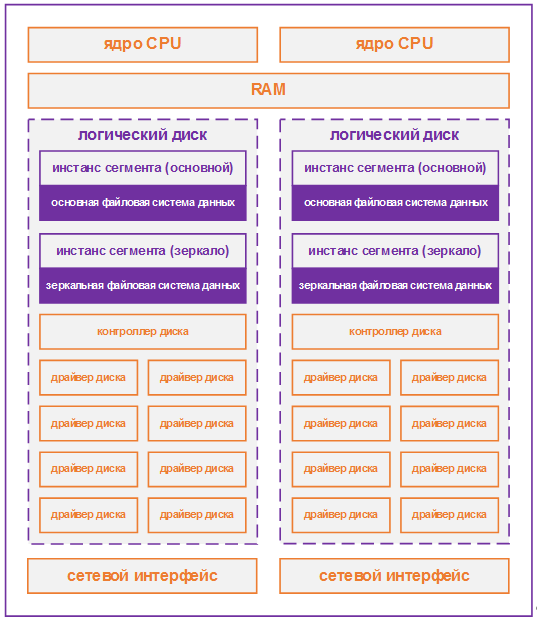

Независимо от выбранной вами аппаратной платформы рабочая нода обработки RT.Warehouse (хост сегмента) настраивается типично, как описано в этом разделе.

Хосты сегментов выполняют большую часть обработки базы данных, поэтому серверы хоста сегмента настроены таким образом, чтобы обеспечить максимальную производительность системы RT.Warehouse. Производительность RT.Warehouse будет такой же высокой, как и у самого медленного сервера сегмента в массиве. Поэтому важно убедиться, что базовое оборудование и операционные системы, на которых работает RT.Warehouse, работают на оптимальном уровне производительности. Также рекомендуется, чтобы все хосты сегмента в массиве RT.Warehouse имели идентичные аппаратные ресурсы и конфигурации.

Узлы сегмента также должны быть предназначены только для операций с RT.Warehouse. Чтобы получить наилучшую производительность запросов, вы не хотите, чтобы RT.Warehouse конкурировал с другими приложениями за ресурсы компьютера или сети.

На следующей схеме показан пример аппаратного стека хоста сегмента RT.Warehouse. Количество эффективных процессоров на хосте является основой для определения того, сколько инстансов основных сегментов RT.Warehouse развернуть на каждом хосте сегмента. В этом примере показан хост с двумя эффективными CPU (один двухъядерный CPU). Обратите внимание, что на каждое ядро CPU приходится одининстанс основного сегмента (или пара основной/зеркальный при использовании зеркалирования).

¶ 3.2.5 Пример схемы сегментного диска

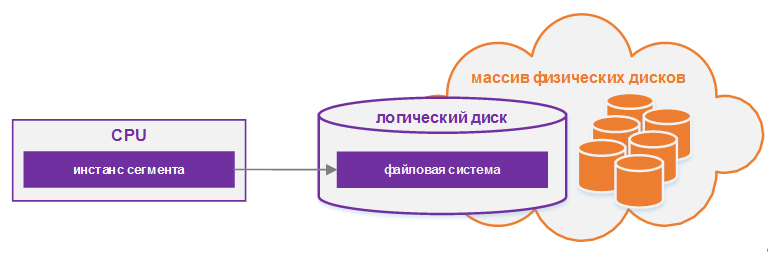

Каждый CPU обычно отображается на логический диск. Логический диск состоит из одной основной файловой системы (и, возможно, зеркальной файловой системы), получающей доступ к пулу физических дисков через канал ввода-вывода или контроллер диска. Логический диск и файловая система предоставляются операционной системой. Большинство операционных систем предоставляют возможность логическому диску использовать группы физических дисков, организованных в RAID-массивы.

¶ 3.3 Интерконнект

Интерконнект — это сетевой уровень RT.Warehouse. Когда пользователь подключается к базе данных и отправляет запрос, в каждом из сегментов создаются процессы для обработки этого запроса. Интерконнект относится к межпроцессному взаимодействию между сегментами, а также к сетевой инфраструктуре, от которой зависит это взаимодействие. Интерконнект использует стандартную коммутационную матрицу 10 Gigabit Ethernet.

По умолчанию соединение с RT.Warehouse использует UDP (User Datagram Protocol) с управлением потоком для межсетевого трафика для отправки сообщений по сети. Программное обеспечение RT.Warehouse выполняет дополнительную проверку пакетов, не выполняемую UDP, поэтому надежность эквивалентна TCP (Transmission Control Protocol), а производительность и масштабируемость превосходят TCP.

¶ 3.3.1 Резервный интерконнект

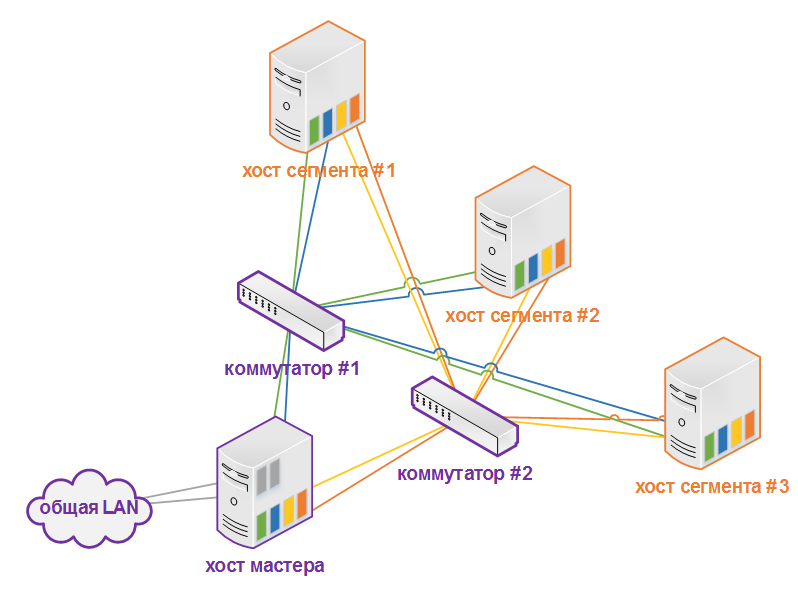

Резервность интерконнекта может быть достигнуто путём развёртывания в вашей сети двух коммутаторов 10 Gigabit Ethernet и резервных подключений 10 Gigabit к серверу мастера RT.Warehouse и хост-серверам сегментов.

¶ 3.3.2 Конфигурация сетевого интерфейса

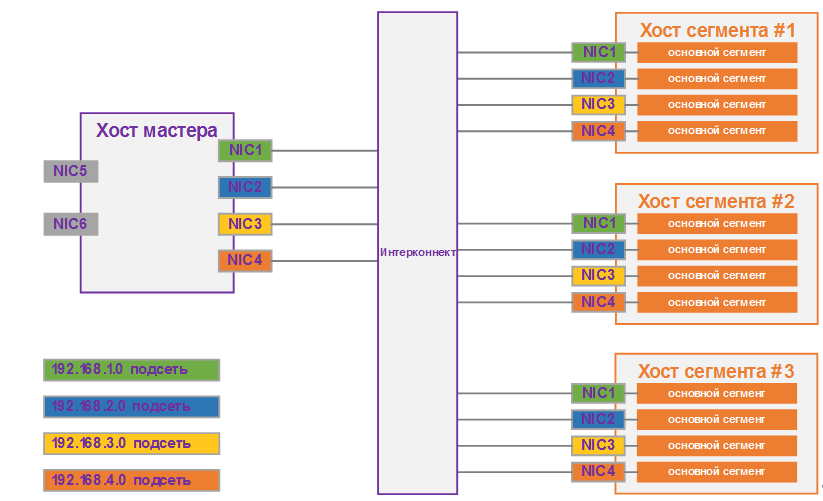

Хост сегмента обычно имеет несколько сетевых интерфейсов, предназначенных для межсетевого трафика RT.Warehouse. Хост мастера обычно имеет дополнительные внешние сетевые интерфейсы в дополнение к интерфейсам, используемым для межсетевого трафика.

В зависимости от количества доступных интерфейсов вы должны распределить сетевой трафик интерконнекта по количеству доступных интерфейсов. Это делается путем присвоения инстансов сегментов конкретному сетевому интерфейсу и обеспечения равномерного распределения основных сегментов по количеству доступных интерфейсов.

Это делается путем создания отдельных имён адресов хостов для каждого сетевого интерфейса. Например, если у хоста четыре сетевых интерфейса, то у него будет четыре соответствующих адреса хоста, каждый из которых соответствует одному или нескольким инстансам основного сегмента. Файл /etc/hosts следует настроить так, чтобы он содержал не только имя хоста каждой машины, но также все адреса хостов интерфейса для всех хостов RT.Warehouse (мастера, резервного мастера, сегментов и хостов ETL).

При такой конфигурации операционная система автоматически выбирает лучший путь к месту назначения. RT.Warehouse автоматически балансирует сетевые назначения для максимального параллелизма.

¶ 3.3.3 Конфигурация коммутатора

При использовании нескольких коммутаторов 10 Gigabit Ethernet в массиве RT.Warehouse равномерно разделите количество подсетей между каждым коммутатором.

В этом примере конфигурации, если бы у нас было два коммутатора, NIC 1 и NIC 2 на каждом хосте использовали бы коммутатор 1, а NIC 3 и NIC 4 на каждом хосте использовали бы коммутатор 2. Для хоста мастера имя хоста, привязанное к NIC 1 (и, следовательно, с помощью коммутатора 1) — это эффективное имя хоста мастера для массива.

Таким образом, при развёртывании сервера резервного мастера для целей резервирования он должен отображаться на NIC, который использует другой коммутатор, чем основной мастер.

¶ 3.4 Хосты ETL для загрузки данных

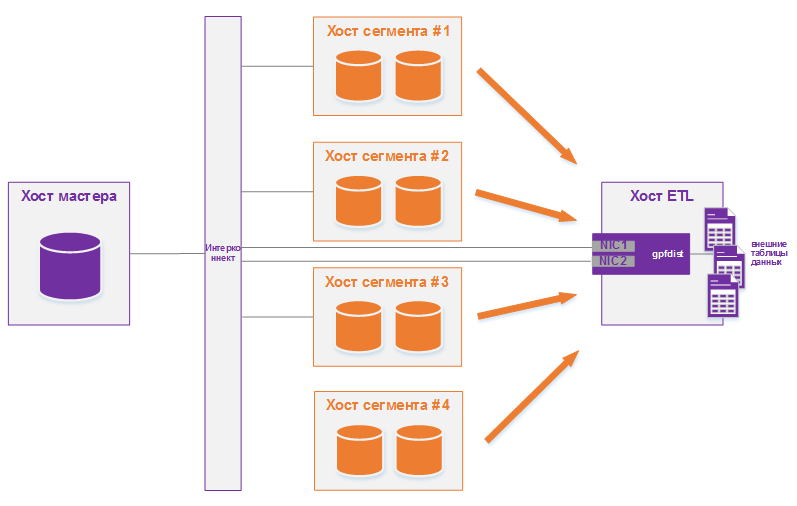

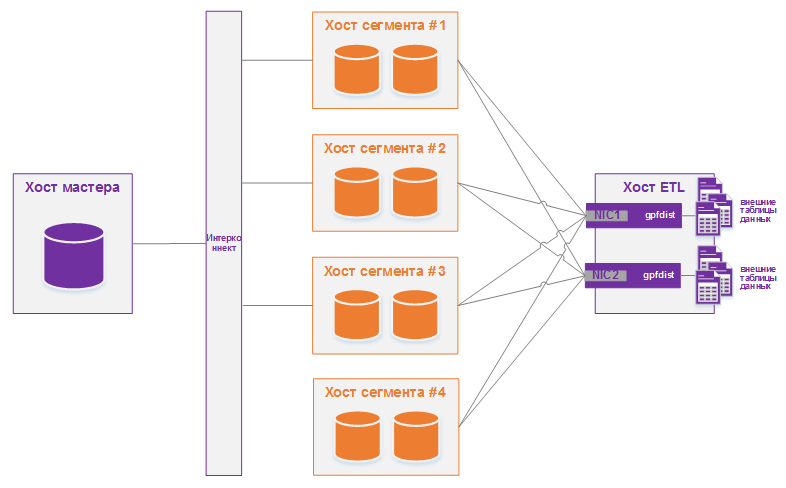

RT.Warehouse поддерживает быструю параллельную загрузку данных с помощью функции внешних таблиц. Используя внешние таблицы в сочетании с параллельным файловым сервером RT.Warehouse (gpfdist), администраторы могут добиться максимального распараллеливания и загрузки полосы пропускания из своей системы RT.Warehouse. Многие производственные системы развёртывают выделенные серверы ETL для загрузки данных. На этих машинах работает параллельный файловый сервер RT.Warehouse (gpfdist), но не инстансы RT.Warehouse.

Одним из преимуществ использования программы файлового сервера gpfdist является то, что она гарантирует, что все сегменты в вашей системе RT.Warehouse полностью используются при чтении из файлов данных внешней таблицы.

Программа gpfdist может передавать данные инстансам сегмента со средней скоростью около 350 МБ/с для файлов с разделителями в текстовом формате и 200 МБ/с для файлов в формате CSV. Поэтому при запуске gpfdist вам следует учитывать следующие параметры, чтобы максимизировать пропускную способность сети ваших систем ETL:

1. Если ваш ETL-сервер сконфигурирован с несколькими сетевыми интерфейсными картами (NIC), как описано в разделе Конфигурация сетевого интерфейса, запустите один инстанс gpfdist на вашем ETL-хосте, а затем определите определение вашей внешней таблицы, чтобы имя хоста каждого NIC было объявлено в параметре LOCATION. Это позволяет сетевому трафику между хостами сегмента RT.Warehouse и ETL-хостом использовать все NIC одновременно.

2. Запустите несколько инстансов gpfdist на своем ETL-хосте и разделите файлы внешних данных поровну между каждым инстансом. Например, если у вас есть система ETL с двумя сетевыми картами (NIC), вы можете запустить два инстанса gpfdist на этом сервере, чтобы максимизировать производительность нагрузки. Затем вы должны равномерно разделить файлы данных внешней таблицы между двумя программами gpfdist.

¶ 4. ОЦЕНКА ЁМКОСТИ ХРАНИЛИЩА

Чтобы оценить, сколько данных может вместить ваша система RT.Warehouse, используйте данные измерения в качестве рекомендаций.

Также имейте в виду, что вам может потребоваться дополнительное пространство для размещения файлов резервных копий и файлов загрузки данных на каждом хосте сегмента.

¶ 4.1 Расчет полезной ёмкости диска

Чтобы вычислить, сколько данных может вместить система RT.Warehouse, вы должны рассчитать полезную ёмкость диска для каждого хоста сегмента, а затем умножить полученное число на количество хостов сегмента массива RT.Warehouse. Начните с необработанной ёмкости физических дисков на хосте сегмента, которые доступны для хранения данных (raw_capacity), а именно:

disk_size * number_of_disksУчитывайте накладные расходы на форматирование файловой системы (примерно 10%) и уровень RAID, который вы используете. Например, при использовании RAID-10 расчёт будет следующим:

(raw_capacity * 0.9) / 2 = formatted_disk_spaceДля оптимальной производительности не заполняйте диски полностью, а используйте 70% или ниже. Помня об этом, рассчитайте доступное дисковое пространство следующим образом:

formatted_disk_space * 0.7 = usable_disk_spaceПосле того, как вы отформатировали дисковые массивы RAID и учли максимальную рекомендуемую ёмкость (usable_disk_space), вам нужно будет рассчитать, сколько пространства фактически доступно для пользовательских данных (U). Если для избыточности данных используются зеркала RT.Warehouse, размер ваших пользовательских данных увеличится вдвое (2*U). RT.Warehouse также требует, чтобы некоторое пространство было зарезервировано в качестве рабочей области для активных запросов. Рабочее пространство должно составлять примерно одну треть размера ваших пользовательских данных (рабочее пространство = U/3):

With mirrors: (2 * U) + U/3 = usable_disk_space

Without mirrors: U + U/3 = usable_disk_spaceРекомендации по временному файловому пространству и пространству пользовательских данных предполагают типичную аналитическую рабочую нагрузку. Рабочие нагрузки с высокой степенью одновременного выполнения или рабочие нагрузки с запросами, требующими очень большого количества временного пространства, могут выиграть от резервирования большей рабочей области. Как правило, общая пропускная способность системы может быть увеличена при уменьшении использования рабочей области за счёт надлежащего управления рабочей нагрузкой. Кроме того, временное пространство и пользовательское пространство можно изолировать друг от друга, указав, что они находятся в разных табличных пространствах.

¶ 4.2 Расчёт размера пользовательских данных

Как и во всех базах данных, размер необработанных данных будет немного больше после их загрузки в базу данных. В среднем необработанные данные будут занимать примерно в 1,4 раза больше на диске после загрузки в базу данных, но могут быть меньше или больше в зависимости от используемых типов данных, типа хранения таблиц, сжатия в базе данных и т.д.

- Page Overhead — когда ваши данные загружаются в RT.Warehouse, они делятся на страницы по 32 КБ каждая. Каждая страница имеет 20 байт служебных данных.

- Row Overhead — в обычной таблице хранения 'heap' каждая строка данных имеет 24 байта служебных данных строки. Таблица хранения 'append-optimized' имеет только 4 байта служебных строк.

- Attribute Overhead — для самих значений данных размер, связанный с каждым значением атрибута, зависит от выбранного типа данных. Как правило, можно использовать минимально возможный тип данных для хранения (при условии, что известны возможные значения, которые будет иметь столбец).

- Indexes — в RT.Warehouse индексы распределяются по хостам сегментов, как и данные таблицы. Тип индекса по умолчанию в RT.Warehouse — B-tree. Поскольку размер индекса зависит от количества уникальных значений в индексе и данных, которые нужно вставить, предварительный расчёт точного размера индекса невозможен. Однако с помощью этих формул можно приблизительно оценить размер индекса.

B-tree: unique_values * (data_type_size + 24 bytes)

Bitmap: (unique_values * number_of_rows * 1 bit * compression_ratio / 8) + (unique_values * 32)¶ 4.3 Расчёт требований к пространству для метаданных и журналов

На каждом хосте сегмента необходимо учесть пространство для файлов журналов и метаданных RT.Warehouse:

1. Системные метаданные — для каждого инстанса сегмента RT.Warehouse (основного или зеркального) или инстанса мастера, работающего на хосте, оставьте приблизительно 20 МБ для системных каталогов и метаданных.

2. Write Ahead Log — для каждого сегмента RT.Warehouse (основного или зеркального) или инстанса мастера, работающего на хосте, выделите место для Write Ahead Log (WAL). WAL разделён на файлы сегментов по 64 МБ каждый. Максимальное количество файлов WAL вычисляются так:

2 * checkpoint_segments + 1Вы можете использовать эту формулу для оценки потребности в пространстве для WAL. По умолчанию параметр checkpoint_segments для инстанса RT.Warehouse равен 8, что означает 1088 МБ пространства WAL, выделенного для каждого сегмента или инстанса мастера на хосте.

3. Файлы журналов RT.Warehouse — каждый инстанс сегмента и инстанс мастера создают файлы журнала базы данных, которые со временем будут расти. Для этих файлов журналов следует выделить достаточно места, и следует использовать какой-либо тип ротации журналов, чтобы файлы журналов не становились слишком большими.

4. Данные командного центра — агенты сбора данных, используемые командным центром, работают на том же наборе хостов, что и инстанс RT.Warehouse, и используют системные ресурсы этих хостов. Потребление ресурсов процессами агента сбора данных на этих хостах минимально и не должно существенно влиять на производительность базы данных. Исторические данные, собранные агентами сбора, хранятся в его собственной базе данных Command Center (с именем gpperfmon) в вашей системе RT.Warehouse. Собранные данные распределяются так же, как и обычные данные базы данных, поэтому вам нужно будет учитывать дисковое пространство в расположениях каталогов данных ваших инстансах сегментов RT.Warehouse. Требуемый объём места зависит от количества исторических данных, которые вы хотите сохранить. Исторические данные не сокращаются автоматически. Администраторы баз данных должны настроить политику сокращения, чтобы поддерживать размер базы данных Command Center.

¶ 5. НАСТРОЙКА ВАШЕЙ СИСТЕМЫ

Раздел описывает, как подготовить среду операционной системы для установки программного обеспечения RT.Warehouse.

Выполните следующие задачи по порядку:

- Убедитесь, что ваши хост-системы соответствуют требованиям, описанным в разделе 1.

- Отключите SELinux и файрвол.

- Задайте необходимые параметры операционной системы.

- Синхронизируйте системные часы.

- Создайте учётную запись gpadmin.

Если не указано иное, эти задачи должны выполняться для всех хостов в массиве RT.Warehouse (мастера, резервного мастера и хостов сегментов).

Соглашение об именах хоста RT.Warehouse для хоста мастера — mdw, а для хоста резервного мастера — smdw.

Соглашение об именах хостов сегментов — sdwN, где sdw — префикс, а N — целое число. Например, имена хостов сегментов будут sdw1, sdw2 и так далее. Связывание NIC рекомендуется для хостов с несколькими интерфейсами, но когда интерфейсы не связаны, по соглашению к имени хоста добавляется тире (-) и номер. Например, sdw1-1 и sdw1-2 — это два имени интерфейса для хоста sdw1.

|

Примечание. Автоматизация шагов настройки, описанных в этом разделе, и установка программного обеспечения RT.Warehouse с помощью инструмента подготовки системы, такого как Ansible, Chef или Puppet, могут сэкономить время и обеспечить надежную и повторяемую установку RT.Warehouse. |

¶ 5.1 Отключение программного обеспечения SELinux и файрвола

Для всех хост-систем RT.Warehouse под управлением РЕД ОС, RHEL/CentOS необходимо отключить SELinux. Выполните следующие действия:

1. Как пользователь root проверьте статус SELinux:

# sestatus

SELinuxstatus: disabled2. Если SELinux не отключён, отключите его, отредактировав файл /etc/selinux/config. От имени пользователя root измените значение параметра SELINUX в файле конфигурации следующим образом:

SELINUX=disabled3. Если в ваших системах установлен System Security Services Daemon (SSSD), отредактируйте файл конфигурации SSSD и установите для параметра selinux_provider значение none, чтобы предотвратить связанные с SELinux отказы аутентификации SSH, которые могут возникать даже при отключённом SELinux. Отредактируйте /etc/sssd/sssd.conf как root и добавьте следующий параметр:

| selinux_provider=none |

4. Перезагрузите систему, чтобы применить все внесённые изменения, и убедитесь, что SELinux отключён.

Вам также следует отключить программное обеспечение файрвола, такое как iptables (в таких системах, как РЕД ОС, RHEL/CentOS), firewalld (в таких системах, как РЕД ОС, RHEL/CentOS) или ufw (в системах Ubuntu отключено по умолчанию).

Если вы решили включить iptables в RT.Warehouse в целях безопасности, см. [ОПЦИОНАЛЬНО] ВКЛЮЧЕНИЕ IPTABLES.

Чтобы отключить iptables, выполните следующие действия:

1. Как пользователь root проверьте состояние iptables:

# /sbin/chkconfig --list iptablesЕсли iptables отключён, вывод команды будет следующим:

iptables 0:off 1:off 2:off 3:off 4:off 5:off 6:off2. При необходимости выполните эту команду от имени пользователя root, чтобы отключить iptables.

/sbin/chkconfig iptables offПосле применения изменений вам потребуется перезагрузить систему.

3. Для систем с firewalld проверьте состояние firewalld с помощью команды:

# systemctl status firewalldЕсли firewalld отключён, вывод команды будет следующим:

* firewalld.service - firewalld - dynamic firewall daemon

Loaded: loaded (/usr/lib/systemd/system/firewalld.service; disabled; vendor preset: enabled)

Active: inactive (dead)4. При необходимости выполните следующие команды от имени пользователя root, чтобы отключить firewalld:

# systemctl stop firewalld.service

# systemctl disable firewalld.serviceДополнительную информацию о настройке программного обеспечения файрвола смотрите в документации по файрволу или вашей операционной системе.

¶ 5.2 Рекомендуемые настройки параметров ОС

RT.Warehouse требует, чтобы определённые параметры операционной системы (ОС) Linux были установлены на всех хостах в вашей RT.Warehouse (мастера и сегментов).

Как правило, необходимо изменить следующие категории параметров системы:

- Shared Memory — инстанс RT.Warehouse не будет работать, если сегмент разделяемой памяти для вашего ядра не имеет надлежащего размера. Большинство установок ОС по умолчанию имеют слишком низкие значения общей памяти для RT.Warehouse. В системах Linux вы также должны отключить убийцу OOM (out of memory).

- Сеть — в системах RT.Warehouse большого объёма необходимо установить определённые параметры настройки, связанные с сетью, чтобы оптимизировать сетевые соединения, выполняемые интерконнектом RT.Warehouse.

- Пользовательские ограничения — пользовательские ограничения управляют ресурсами, доступными процессам, запускаемым оболочкой пользователя. RT.Warehouse требует более высокого ограничения на допустимое количество файловых дескрипторов, которые может открыть один процесс. Настройки по умолчанию могут привести к сбою некоторых запросов к RT.Warehouse, поскольку в них закончились файловые дескрипторы, необходимые для обработки запроса.

В частности, вам необходимо отредактировать следующие параметры конфигурации Linux:

- Файл hosts.

- Файл sysctl.conf.

- Ограничения системных ресурсов.

- Параметры монтирования XFS.

- Настройки дискового ввода-вывода.

- Опережающее чтение;

- Планировщик дискового ввода-вывода.

6. Transparent Huge Pages (THP).

7. Удаление объекта IPC.

8. Лимит подключений по SSH.

¶ 5.2.1 Файл hosts

Отредактируйте файл /etc/hosts и убедитесь, что он включает имена хостов и все имена адресов интерфейсов для каждой машины, участвующей в вашей системе RT.Warehouse.

¶ 5.2.2 Файл sysctl.conf

Параметры sysctl.conf, перечисленные в этом разделе, предназначены для обеспечения производительности, оптимизации и согласованности в самых разных средах. Измените эти настройки в соответствии с вашей конкретной ситуацией и настройками.

Задайте параметры в файле /etc/sysctl.conf и перезагрузите его с помощью sysctl -p:

# kernel.shmall = _PHYS_PAGES / 2 # См. Страницы общей памяти

kernel.shmall = 197951838

# kernel.shmmax = kernel.shmall * PAGE_SIZE

kernel.shmmax = 810810728448

kernel.shmmni = 4096

vm.overcommit_memory = 2 # См. Память хоста сегмента

vm.overcommit_ratio = 95 # См. Память хоста сегмента

net.ipv4.ip_local_port_range = 10000 65535 # См. Настройки порта

kernel.sem = 500 2048000 200 4096

kernel.sysrq = 1

kernel.core_uses_pid = 1

kernel.msgmnb = 65536

kernel.msgmax = 65536

kernel.msgmni = 2048

net.ipv4.tcp_syncookies = 1

net.ipv4.conf.default.accept_source_route = 0

net.ipv4.tcp_max_syn_backlog = 4096

net.ipv4.conf.all.arp_filter = 1

net.core.netdev_max_backlog = 10000

net.core.rmem_max = 2097152

net.core.wmem_max = 2097152

vm.swappiness = 10

vm.zone_reclaim_mode = 0

vm.dirty_expire_centisecs = 500

vm.dirty_writeback_centisecs = 100

vm.dirty_background_ratio = 0 # См. Системная память

vm.dirty_ratio = 0

vm.dirty_background_bytes = 1610612736

vm.dirty_bytes = 4294967296¶ 5.2.2.1 Страницы общей памяти

RT.Warehouse использует разделяемую память для связи между процессами postgres, которые являются частью одного и того же инстанса postgres.kernel.shmall устанавливает общий объём разделяемой памяти в страницах, который может использоваться в масштабе всей системы. kernel.shmmax устанавливает максимальный размер одного сегмента разделяемой памяти в байтах.

Установите значения kernel.shmall и kernel.shmax в зависимости от физической памяти вашей системы и размера страницы. Как правило, значение обоих параметров должно составлять половину физической памяти системы.

Используйте переменные операционной системы _PHYS_PAGES и PAGE_SIZE, чтобы установить параметры.

kernel.shmall = ( _PHYS_PAGES / 2)

kernel.shmmax = ( _PHYS_PAGES / 2) * PAGE_SIZEЧтобы вычислить значения для kernel.shmall и kernel.shmax, выполните следующие команды, используя команду getconf, которая возвращает значение переменной операционной системы.

$ echo $(expr $(getconf _PHYS_PAGES) / 2)

$ echo $(expr $(getconf _PHYS_PAGES) / 2 \* $(getconf PAGE_SIZE))В качестве наилучшей практики рекомендуется установить следующие значения в файле /etc/sysctl.conf, используя вычисленные значения. Например, в хост-системе установлено 1583 ГБ памяти, и она возвращает следующие значения: _PHYS_PAGES = 395903676 и PAGE_SIZE = 4096. Это будут значения kernel.shmall и kernel.shmmax:

kernel.shmall = 197951838

kernel.shmmax = 810810728448Если у мастера RT.Warehouse конфигурация разделяемой памяти отличается от конфигурации хостов сегмента, значения _PHYS_PAGES и PAGE_SIZE могут отличаться, а значения kernel.shmall и kernel.shmax на хосте мастера будут отличаться от значений на хостах сегмента.

¶ 5.2.2.2 Память хоста сегмента

Параметр ядра Linux vm.overcommit_memory используется ОС для определения объёма памяти, который можно выделить для процессов. Для RT.Warehouse этот параметр всегда должен иметь значение 2.

vm.overcommit_ratio — это процент RAM, который используется для процессов приложений, а остальная часть зарезервирована для операционной системы. По умолчанию в Red Hat Enterprise Linux установлено значение 50.

¶ 5.2.2.3 Настройки порта

Чтобы избежать конфликтов портов между RT.Warehouse и другими приложениями во время инициализации RT.Warehouse, обратите внимание на диапазон портов, указанный параметром операционной системы net.ipv4.ip_local_port_range.

При инициализации RT.Warehouse с использованием файла конфигурации кластера gpinitsystem не указывайте порты RT.Warehouse в этом диапазоне.

Например, если net.ipv4.ip_local_port_range = 10000 65535, установите эти значения для номеров базовых портов RT.Warehouse.

PORT_BASE = 6000

MIRROR_PORT_BASE = 7000Для получения информации о файле конфигурации кластера gpinitsystem см. раздел 8.

Для развёртываний Azure с RT.Warehouse избегайте использования порта 65330; добавьте в sysctl.conf следующую строку:

net.ipv4.ip_local_reserved_ports=65330¶ 5.2.2.4 Системная память

Для хост-систем с объёмом памяти более 64 ГБ рекомендуются следующие настройки:

vm.dirty_background_ratio = 0

vm.dirty_ratio = 0

vm.dirty_background_bytes = 1610612736 # 1.5GB

vm.dirty_bytes = 4294967296 # 4GBДля хост-систем с 64 ГБ памяти или меньше удалите vm.dirty_background_bytes и vm.dirty_bytes и установите для двух параметров отношения следующие значения:

vm.dirty_background_ratio = 3

vm.dirty_ratio = 10Увеличьте vm.min_free_kbytes, чтобы запросы PF_MEMALLOC от сетевых драйверов и драйверов хранилища были легко удовлетворены. Это особенно важно для систем с большим объёмом системной памяти. В этих системах значение по умолчанию часто слишком мало. Используйте эту команду awk, чтобы установить для vm.min_free_kbytes рекомендуемые 3% системной физической памяти:

awk 'BEGIN {OFMT = "%.0f";} /MemTotal/ {print "vm.min_free_kbytes =", $2 * .03;}'

/proc/meminfo >> /etc/sysctl.confНе устанавливайте для vm.min_free_kbytes значение выше 5% системной памяти, так как это может привести к нехватке памяти.

¶ 5.2.3 Ограничения системных ресурсов

Задайте следующие параметры в файле /etc/security/limits.conf:

* soft nofile 524288

* hard nofile 524288

* soft nproc 131072

* hard nproc 131072Для систем РЕД ОС, RHEL/CentOS значения параметров в файле /etc/security/limits.d/90-nproc.conf (РЕД ОС, RHEL/CentOS) или /etc/security/limits.d/20-nproc.conf (РЕД ОС, RHEL/CentOS) переопределяет значения в файле limits.conf. Убедитесь, что для всех параметров в файле переопределения установлено необходимое значение. Модуль Linux pam_limits устанавливает ограничения для пользователей, считывая значения из файла limits.conf, а затем из файла переопределения. Для получения информации о PAM и пользовательских лимитах смотрите документацию по PAM и pam_limits.

Выполните команду ulimit -u на каждом хосте сегмента, чтобы отобразить максимальное количество процессов, доступных каждому пользователю. Убедитесь, что возвращаемое значение — 131072.

¶ 5.2.4 Параметры монтирования XFS

XFS является предпочтительной файловой системой хранения данных на платформах Linux. Используйте команду mount со следующими рекомендуемыми параметрами монтирования XFS:

rw,nodev,noatime,nobarrier,inode64Параметры XFS также можно установить в файле /etc/fstab. В этом примере записи из файла fstab указаны параметры XFS.

/dev/data /data xfs nodev,noatime,nobarrier,inode64 0 0¶ 5.2.5 Настройки дискового ввода-вывода

1. Значение опережающего чтения.

Каждый файл дискового устройства должен иметь значение упреждающего чтения (blockdev) 16384. Чтобы проверить значение упреждающего чтения дискового устройства:

# /sbin/blockdev --getra devnameНапример:

# /sbin/blockdev --getra /dev/sdbЧтобы установить blockdev (упреждающее чтение) на устройстве:

# /sbin/blockdev --setra bytes devnameНапример:

# /sbin/blockdev --setra 16384 /dev/sdb

|

Примечание. Команда blockdev --setra не является постоянной, её нужно запускать каждый раз при перезагрузке системы. Как запустить команду, зависит от вашей системы, но вы должны убедиться, что параметр упреждающего чтения устанавливается каждый раз при перезагрузке системы. |

2. Планировщик дискового ввода-вывода

Планировщик дискового ввода-вывода Linux для доступа к диску поддерживает различные политики, такие как CFQ, AS и deadline.

Рекомендуется использовать планировщик deadline. Чтобы указать планировщик до следующей перезагрузки системы, выполните следующее:

# echo schedulername > /sys/block/devname/queue/schedulerНапример:

# echo deadline > /sys/block/sbd/queue/scheduler

|

Примечание. Использование команды echo для установки политики планировщика дискового ввода-вывода не является постоянным, поэтому вы должны убедиться, что команда запускается при каждой перезагрузке системы. Как запустить команду, зависит от вашей системы. |

Один из способов установить политику планировщика ввода-вывода во время загрузки — использовать параметр ядра elevator. Добавьте параметр elevator=deadline в команду ядра в файле /boot/grub/grub.conf, файле конфигурации загрузчика GRUB. Это пример команды ядра из файла grub.conf в РЕД ОС, RHEL/CentOS. Команда состоит из нескольких строк для удобства чтения.

kernel /vmlinuz-2.6.18-274.3.1.el5 ro root=LABEL=/

elevator=deadline crashkernel=128M@16M quiet console=tty1

console=ttyS1,115200 panic=30 transparent_hugepage=never

initrd /initrd-2.6.18-274.3.1.el5.imgЧтобы указать планировщик ввода-вывода во время загрузки в системах, использующих grub2, таких как РЕД ОС, RHEL/CentOS, используйте системную утилиту grubby. Эта команда добавляет параметр при запуске от имени пользователя root.

# grubby --update-kernel=ALL --args="elevator=deadline"После добавления параметра перезагрузите систему.

Команда grubby отображает настройки параметров ядра.

# grubby --info=ALLДополнительные сведения об утилите grubby смотрите в документации к операционной системе. Если команда grubby не обновляет ядра, см. примечание в Лимит подключений по SSH.

¶ 5.2.6 Transparent Huge Pages (THP)

В системах, использующих grub2, таких как РЕД ОС, RHEL/CentOS используйте системную утилиту grubby. Эта команда добавляет параметр при запуске от имени пользователя root.

# grubby --update-kernel=ALL --args="transparent_hugepage=never"После добавления параметра перезагрузите систему.

Для систем Ubuntu установите пакет hugepages и выполните эту команду от имени пользователя root:

# hugeadm --thp-neverЭта команда cat проверяет состояние THP. Вывод показывает, что THP отключён.

$ cat /sys/kernel/mm/*transparent_hugepage/enabled

always [never]Дополнительную информацию о THP или утилите grubby смотрите в документации по операционной системе. Если команда grubby не обновляет ядра, см. примечание в Лимит подключений по SSH.

¶ 5.2.7 Удаление объекта IPC

Отключите удаление объекта IPC для RHEL/CentOS или Ubuntu. Параметр systemd по умолчанию RemoveIPC=yes удаляет IPC-соединения при выходе из системы несистемных учётных записей пользователей. Это приводит к сбою утилиты gpinitsystem RT.Warehouse с ошибками семафоров. Чтобы избежать этой проблемы, выполните одно из следующих действий.

- Когда вы добавляете учётную запись пользователя операционной системы gpadmin в мастере в п. 4.4, создайте пользователя как системную учётную запись.

- Отключите RemoveIPC. Установите этот параметр в /etc/systemd/logind.conf в хост-системах RT.Warehouse.

RemoveIPC=noНастройка вступает в силу после перезапуска службы systemd-login или перезагрузки системы. Чтобы перезапустить службу, запустите эту команду от имени пользователя root.

service systemd-logind restart¶ 5.2.8 Лимит подключений по SSH

Некоторые утилиты управления RT.Warehouse, включая gpexpand, gpinitsystem и gpaddmirrors, для выполнения своих задач используют соединения secure shell (SSH) между системами. В развёртываниях больших RT.Warehouse, облачных развёртываниях или развёртываниях с большим количеством сегментов на хост эти утилиты могут превышать максимальный лимит для неаутентифицированных соединений на хостах. Когда это происходит, вы получаете такие ошибки, как: ssh_exchange_identification: Connection closed by remote host.

Чтобы увеличить этот порог подключения для вашей системы RT.Warehouse, обновите параметр конфигурации SSH MaxStartups в одном из файлов конфигурации демона SSH /etc/ssh/sshd_config или /etc/sshd_config.

Если вы укажете MaxStartups с использованием единственного целочисленного значения, вы определите максимальное количество одновременных неаутентифицированных подключений. Например:

MaxStartups 200Если вы укажете MaxStartups с использованием синтаксиса "start:rate:full", вы включите случайное раннее прерывание соединения с помощью демона SSH. start определяет максимальное количество разрешённых попыток SSH-соединения без аутентификации. По достижении start числа попыток подключения без аутентификации демон SSH отклоняет процент последующих попыток подключения rate. full определяет максимальное количество попыток подключения без аутентификации, после которых все попытки отклоняются. Например:

Max Startups 10:30:200Подробную информацию о параметрах конфигурации SSH смотрите в документации по SSH для вашего дистрибутива Linux.

|

Примечание. Если команда grubby не обновляет ядра системы РЕД ОС 7.x, RHEL/CentOS вы можете вручную обновить все ядра в системе. Например, чтобы добавить параметр transparent_hugepage=never ко всем ядрам в системе. 1. Добавьте параметр в строку GRUB_CMDLINE_LINUX в параметре файла в /etc/default/grub.

2. От имени пользователя root запустите команду grub2-mkconfig, чтобы обновить ядра.

3. Перезагрузите систему. |

¶ 5.3 Синхронизация системных часов

Вы должны использовать NTP (Network Time Protocol) для синхронизации системных часов на всех хостах, составляющих вашу систему базы данных RT.Warehouse. См. www.ntp.org для получения дополнительной информации о NTP.

NTP на хостах сегмента должен быть настроен на использование хоста мастера в качестве основного источника времени и резервного мастера в качестве вторичного источника времени. На хостах мастера и реервного мастера настройте NTP так, чтобы он указывал на выбранный вами сервер времени.

¶ 5.3.1 Настройка NTP

Чтобы настроить NTP, выполните следующие действия:

1. На хосте мастера войдите в систему как root и отредактируйте файл /etc/ntp.conf. Установите параметр server, чтобы он указывал на сервер времени NTP вашего центра обработки данных. Например (если IP-адрес NTP-сервера вашего центра обработки данных — 10.6.220.20):

server 10.6.220.202. На каждом хосте сегмента войдите в систему как root и отредактируйте файл /etc/ntp.conf. Установите первый параметр server так, чтобы он указывал на хост мастера, а второй параметр server, чтобы указывать на хост резервного мастера. Например:

server mdw prefer

server smdw3. На хосте резервного мастера войдите в систему как root и отредактируйте файл /etc/ntp.conf. Установите первый параметр server так, чтобы он указывал на хост основного мастера, а второй параметр server — на сервер времени NTP вашего центра обработки данных. Например:

server mdw prefer

server 10.6.220.204. На хосте мастера используйте демон NTP для синхронизации системных часов на всех хостах RT.Warehouse. Например, используя gpssh:

# gpssh -f hostfile_gpssh_allhosts -v -e 'ntpd'¶ 5.4 Создание пользователя с правами администратора RT.Warehouse

Создайте специальную учётную запись пользователя операционной системы на каждом хосте для запуска и администрирования RT.Warehouse. Эта учётная запись пользователя по соглашению называется gpadmin.

|

Внимание. Вы не можете запустить сервер RT.Warehouse от имени пользователя root. |

Пользователь gpadmin должен иметь разрешение на доступ к службам и каталогам, необходимым для установки и запуска RT.Warehouse.

Пользователь gpadmin на каждом хосте RT.Warehouse должен иметь установленную пару ключей SSH и иметь возможность подключаться по SSH с любого хоста в кластере к любому другому хосту в кластере без ввода пароля или ключевой фразы (так называемый "passwordless SSH"). Если вы включите SSH без пароля с хоста мастера на все остальные хосты в кластере ("1-n passwordless SSH"), вы можете позже использовать утилиту командной строки RT.Warehouse gpssh-exkeys, чтобы включить беспарольный SSH с каждого хоста на любой другой хост ("n-n passwordless SSH").

При желании вы можете предоставить пользователю gpadmin привилегию sudo, чтобы вы могли легко администрировать все хосты в кластере RT.Warehouse как gpadmin с помощью команд sudo, ssh/scp и gpssh/gpscp.

Следующие шаги показывают, как настроить пользователя gpadmin на хосте, установить пароль, создать пару ключей SSH и [опционально] включить возможность sudo. Эти действия должны выполняться с правами root на каждом хосте кластера RT.Warehouse. (Для большого кластера RT.Warehouse вам нужно автоматизировать эти шаги, используя инструменты подготовки вашей системы.)

|

Примечание. См. ПРИМЕР ANSIBLE PLAYBOOK для примера, который показывает, как автоматизировать задачи по созданию пользователя gpadmin и установке программного обеспечения RT.Warehouse на всех хостах в кластере. |

1. Создайте группу и пользователя gpadmin.

|

Примечание. Если вы устанавливаете RT.Warehouse на RHEL/CentOS и хотите отключить удаление объекта IPC, создав пользователя gpadmin в качестве системной учётной записи, укажите как параметр -r (создание пользователя как системной учётной записи), так и параметр -m (создание домашнего каталога) для команды useradd. В системах Ubuntu вы должны использовать параметр -m с командой useradd, чтобы создать домашний каталог для пользователя. |

В этом примере создаётся группа gpadmin, создаётся пользователь gpadmin как системная учётная запись с домашним каталогом и как член группы gpadmin, а также создаётся пароль для пользователя.

# groupadd gpadmin

# useradd gpadmin -r -m -g gpadmin

# passwd gpadmin

New password: <changeme>

Retype new password: <changeme>

|

Примечание. Убедитесь, что у пользователя gpadmin одинаковые номера идентификатора пользователя (uid) и идентификатора группы (gid) на каждом хосте, чтобы предотвратить проблемы со скриптами или службами, которые используют их для идентификации или разрешений. Например, резервное копирование RT.Warehouse на некоторые сетевые файловые системы или устройства хранения может завершиться ошибкой, если у пользователя gpadmin разные номера uid или gid на разных хостах сегмента. Когда вы создаете группу и пользователя gpadmin, вы можете использовать параметр groupadd -g, чтобы указать номер gid, и параметр useradd -u, чтобы указать номер uid. Используйте команду id gpadmin, чтобы увидеть uid и gid для пользователя gpadmin на текущем хосте. |

2. Переключитесь на пользователя gpadmin и сгенерируйте пару ключей SSH для пользователя gpadmin.

$ su gpadmin

$ ssh-keygen -t rsa -b 4096

Generating public/private rsa key pair.

Enter file in which to save the key (/home/gpadmin/.ssh/id_rsa):

Created directory '/home/gpadmin/.ssh'.

Enter passphrase (empty for no passphrase):

Enter same passphrase again:При появлении запроса на парольную фразу нажмите Enter, чтобы для соединений SSH не требовалось вводить парольную фразу.

3. [Опционально] Предоставьте sudo доступ пользователю gpadmin.

В RHEL/CentOS запустите visudo и раскомментируйте запись группы %wheel.

%wheel ALL=(ALL) NOPASSWD: ALLУбедитесь, что вы расскомментировали строку с ключевым словом NOPASSWD.

Добавьте пользователя gpadmin в группу wheel с помощью команды.

# usermod -aG wheel gpadmin¶ 6. УСТАНОВКА ПРОГРАММНОГО ОБЕСПЕЧЕНИЯ RT.WAREHOUSE

Раздел описывает, как установить бинарные файлы программного обеспечения RT.Warehouse на все хосты, которые будут составлять вашу систему RT.Warehouse, как включить SSH без пароля для пользователя gpadmin и как проверить установку.

¶ 6.1 Установка RT.Warehouse

Вы должны установить RT.Warehouse на каждом хост-компьютере системы RT.Warehouse. Вы можете настроить минимальную систему RT.Warehouse для работы в одной хост-системе с инстансом мастера и инстансами сегмента, работающими в одной хост-системе.

Выпуски RT.Warehouse доступны в виде tar-архивов исходного кода, установщиков RPM для РЕД ОС, RHEL/CentOS и пакетов DEB для Debian и Ubuntu. Для операционной системы Ubuntu Greenplum также предлагает бинарный файл, который можно установить с помощью команды apt-get в системе Ubuntu Personal Package Archive.

Перед тем как приступить к установке RT.Warehouse, убедитесь, что вы выполнили действия, описанные в разделе 4, для настройки каждой из хост-машин мастера, резервного мастера и сегментов для RT.Warehouse.

|

Внимание. После установки RT.Warehouse необходимо установить переменные среды RT.Warehouse. См. п. 8.3. |

См. раздел 15, в котором показан пример сценария, показывающий, как можно автоматизировать создание пользователя gpadmin и установку RT.Warehouse.

Следуйте этим инструкциям, чтобы установить RT.Warehouse из предварительно созданного бинарного файла.

|

Внимание. Вам потребуется доступ sudo или root для установки из предварительно созданного бинарного файла. |

1. Загрузите и скопируйте пакет RT.Warehouse в домашний каталог пользователя gpadmin на хост-машины мастера, резервного мастера и сегментов. Имя файла дистрибутива имеет формат greenplum-db-<version>-<platform>.rpm для систем РЕД ОС, RHEL/CentOS или greenplum-db-<version>-<platform>.deb для систем Ubuntu, где <platform> похож на rhel7-x86_64 (Red Hat 7 64-bit).

2. С помощью sudo (или от имени пользователя root) установите пакет RT.Warehouse на каждый хост-компьютер с помощью программного обеспечения управления пакетами вашей системы.

- Для систем РЕД ОС, RHEL/CentOS выполните команду yum:

$ sudo yum install ./greenplum-db-<version>-<platform>.rpm

- Для систем Ubuntu выполните команду apt:

$ sudo apt install ./greenplum-db-<version>-<platform>.debКоманда yum или apt устанавливает зависимости программного обеспечения, копирует файлы программного обеспечения RT.Warehouse в каталог для конкретной версии /usr/local/greenplum-db-<version> и создаёт символическую ссылку /usr/local/greenplum-db на каталог установки.

3. Измените владельца и группу установленных файлов на gpadmin:

$ sudo chown -R gpadmin:gpadmin /usr/local/greenplum*¶ 6.2 Включение SSH без пароля

Пользователь gpadmin на каждом хосте RT.Warehouse должен иметь возможность подключаться по SSH с любого хоста в кластере к любому другому хосту в кластере без ввода пароля или ключевой фразы (так называемый "passwordless SSH"). Если вы включите SSH без пароля с хоста мастера на все остальные хосты в кластере ("1-n passwordless SSH"), вы можете использовать утилиту командной строки RT.Warehouse gpssh-exkeys, чтобы включить беспарольный SSH с каждого хоста на любой другой хост ("n-n passwordless SSH").

- Войдите на хост мастера как пользователь gpadmin.

- Найдите файл пути в каталоге установки RT.Warehouse.

$ source /usr/local/greenplum-db-<version>/greenplum_path.sh

|

Примечание. Добавьте указанную выше исходную команду в .bashrc пользователя gpadmin или другой файл запуска оболочки, чтобы путь к RT.Warehouse и переменные среды устанавливались при каждом входе в систему как gpadmin. |

3. С помощью команды ssh-copy-id добавьте открытый ключ пользователя gpadmin в SSH-файл authorized_hosts на всех остальных хостах кластера.

$ ssh-copy-id smdw

$ ssh-copy-id sdw1

$ ssh-copy-id sdw2

$ ssh-copy-id sdw3

. . .Команда включает "1-n passwordless SSH". Вам будет предложено ввести пароль пользователя gpadmin для каждого хоста. Если у вас есть команда sshpass в вашей системе, вы можете использовать следующую команду, чтобы избежать запроса:

$ SSHPASS=<password> sshpass -e ssh-copy-id smdw4. В домашнем каталоге gpadmin создайте файл с именем hostfile_exkeys, который содержит настроенные на компьютере имена хостов и адреса хостов (имена интерфейсов) для каждого хоста в вашей системе RT.Warehouse (хостов мастера, резервного мастера и сегментов). Убедитесь, что нет пустых строк или лишних пробелов. Проверьте файл /etc/hosts в вашей системе на предмет правильных имён хостов для использования в вашей среде. Например, если у вас есть мастер, резервный мастер и три хоста сегмента с двумя несвязанными сетевыми интерфейсами на хост, ваш файл будет выглядеть примерно так:

mdw

mdw-1

mdw-2

smdw

smdw-1

smdw-2

sdw1

sdw1-1

sdw1-2

sdw2

sdw2-1

sdw2-2

sdw3

sdw3-1

sdw3-25. Запустите утилиту gpssh-exkeys с файлом hostfile_exkeys, чтобы включить "n-n passwordlessSSH" для пользователя gpadmin.

$ gpssh-exkeys -f hostfile_exkeys¶ 6.3 Подтверждение вашей установки

Чтобы убедиться, что программное обеспечение RT.Warehouse было установлено и настроено правильно, выполните следующие шаги подтверждения с хоста мастера RT.Warehouse. При необходимости исправьте любые проблемы, прежде чем переходить к следующей задаче.

- Войдите на хост мастера как gpadmin:

$ su - gpadmin2. С помощью утилиты gpssh проверьте, можете ли вы войти на все хосты без запроса пароля, и убедитесь, что программа RT.Warehouse была установлена на всех хостах. Используйте файл hostfile_exkeys, который вы использовали для настройки SSH без пароля. Например:

$ gpssh -f hostfile_exkeys -e 'ls -l /usr/local/greenplum-db-<version>'Если установка прошла успешно, вы сможете войти на все хосты без запроса пароля. Все хосты должны показать, что у них одинаковое содержимое в их каталогах установки, и что каталоги принадлежат пользователю gpadmin.

Если вам будет предложено ввести пароль, выполните следующую команду, чтобы повторить обмен ключами ssh:

$ gpssh-exkeys -f hostfile_exkeys¶ 6.4 Об установке базы данных RT.Warehouse

- greenplum_path.sh — файл, содержащий переменные среды для RT.Warehouse. См. п. 8.3;

- bin — каталог, который содержит утилиты управления RT.Warehouse. Этот каталог также содержит клиентские и серверные программы PostgreSQL, большинство из которых также используются в RT.Warehouse;

- docs/cli_help — каталог, содержащий файлы справки для утилит командной строки RT.Warehouse;

- docs/cli_help/gpconfigs — каталог, содержащий образцы файлов конфигурации gpinitsystem и файлы хоста, которые можно изменять и использовать при установке и инициализации системы RT.Warehouse;

- ext — связанные программы (например, Python), используемые некоторыми утилитами RT.Warehouse;

- include — файлы заголовков C для RT.Warehouse;

- lib — файлы RT.Warehouse и библиотеки PostgreSQL;

- sbin — вспомогательные/внутренние скрипты и программы;

- share — общие файлы для RT.Warehouse.

¶ 7. СОЗДАНИЕ ОБЛАСТЕЙ ХРАНЕНИЯ ДАННЫХ

Раздел описывает, как создать расположение каталогов, где хранятся данные RT.Warehouse для каждого инстанса мастера, резервного мастера и сегментов.

¶ 7.1 Создание областей хранения данных на хостах мастера и резервного мастера

На хостах мастера и резервного мастера RT.Warehouse требуется область хранения данных для хранения системных данных RT.Warehouse, таких как данные каталога и другие метаданные системы.

¶ 7.1.1 Создание расположения каталога данных на мастере

Расположение каталога данных на мастере отличается от местоположения в сегментах. Мастер не хранит никаких пользовательских данных, только таблицы системного каталога и системные метаданные хранятся на мастере, поэтому вам не нужно назначать столько места для хранения, сколько в сегментах.

1. Создайте или выберите каталог, который будет служить вашей областью хранения основных данных. Этот каталог должен иметь достаточно места на диске для ваших данных и принадлежать пользователю и группе gpadmin. Например, выполните следующие команды от имени пользователя root:

# mkdir -p /data/master2. Измените право собственности на этот каталог на пользователя gpadmin. Например:

# chown gpadmin:gpadmin /data/master3. С помощью gpssh также создайте местоположение каталога основных данных на сервере резервного мастера. Например:

# source /usr/local/greenplum-db/greenplum_path.sh

# gpssh -h smdw -e 'mkdir -p /data/master'

# gpssh -h smdw -e 'chown gpadmin:gpadmin /data/master'¶ 7.2 Создание областей хранения данных на хостах сегментов

На хостах сегмента RT.Warehouse для основных сегментов требуются области хранения данных. Для зеркальных сегментов требуются отдельные места для хранения.

¶ 7.2.1 Создание расположения каталогов данных на всех хостах сегмента

1. На хосте мастера войдите как root:

2. Создайте файл с именем hostfile_gpssh_segonly. В этом файле должно быть указано только одно имя хоста, настроенное для каждого хоста сегмента. Например, если у вас есть три хоста сегмента:

sdw1

sdw2

sdw33. С помощью gpssh создайте основные и зеркальные каталоги данных на всех хостах сегмента одновременно, используя только что созданный файл hostfile_gpssh_segonly. Например:

# source /usr/local/greenplum-db/greenplum_path.sh

# gpssh -f hostfile_gpssh_segonly -e 'mkdir -p /data/primary'

# gpssh -f hostfile_gpssh_segonly -e 'mkdir -p /data/mirror'

# gpssh -f hostfile_gpssh_segonly -e 'chown -R gpadmin /data/*'¶ 8. ПРОВЕРКА ВАШИХ СИСТЕМ

Проверьте свое оборудование и производительность сети. RT.Warehouse предоставляет утилиту управления под названием gpcheckperf, которую можно использовать для выявления проблем аппаратного и системного уровня на машинах в массиве RT.Warehouse. gpcheckperf запускает сеанс на указанных хостах и выполняет следующие тесты производительности:

- Производительность сети (gpnetbench*);

- Производительность дискового ввода-вывода (dd test);

- Пропускная способность памяти (stream test).

Перед использованием gpcheckperf настройте доверенность хостов между хостами, участвующими в тесте производительности. Вы можете использовать утилиту gpssh-exkeys для обновления известных файлов хоста и обмена открытыми ключами между хостами, если вы этого ещё не сделали. Обратите внимание, что gpcheckperf вызывает gpssh и gpscp, поэтому эти утилиты RT.Warehouse должны быть в вашем $PATH.

- Проверка производительности сети.

- Проверка дискового ввода-вывода и пропускной способности памяти.

¶ 8.1 Проверка производительности сети

Чтобы проверить производительность сети, запустите gpcheckperf с одним из вариантов запуска теста сети: тест параллельной пары (-r N), тест последовательной пары (-r n) или полный матричный тест (-r M). Утилита запускает программу тестирования производительности сети, которая передает 5-секундный поток данных с текущего хоста на каждый удалённый хост, включённый в тест. По умолчанию данные передаются параллельно каждому удалённому хосту, а минимальная, максимальная, средняя и медианная скорость передачи данных по сети указывается в мегабайтах в секунду (МБ/с). Если итоговая скорость передачи ниже ожидаемой (менее 100 МБ/с), вы можете запустить тест сети последовательно, используя параметр -r n, чтобы получить результаты для каждого хоста. Чтобы запустить полноматричный тест пропускной способности, вы можете указать -r M, который заставит каждый хост отправлять и получать данные с любого другого указанного хоста. Этот тест лучше всего использовать для проверки того, может ли коммутационная матрица выдерживать полноматричную рабочую нагрузку.

Большинство систем в массиве RT.Warehouse сконфигурировано с несколькими сетевыми интерфейсными картами (NIC), каждая из которых находится в своей собственной подсети. При тестировании производительности сети важно тестировать каждую подсеть индивидуально. Например, учитывая следующую конфигурацию сети с двумя NIC на хост:

Таблица 2— Пример конфигурации сетевого интерфейса

| Хост RT.Warehouse | NIC подсети 1 | NIC подсети 2 |

|---|---|---|

| Сегмент 1 | sdw1-1 | sdw1-2 |

| Сегмент 2 | sdw2-1 | sdw2-2 |

| Сегмент 3 | sdw3-1 | sdw3-2 |

Вы должны создать четыре отдельных файла хоста для использования с сетевым тестом gpcheckperf:

Таблица 3— Пример содержимого файла хоста для проверки сети

|

hostfile_gpchecknet_ic1 |

hostfile_gpchecknet_ic2 |

|---|---|

| sdw1-1 | sdw1-2 |

| sdw2-1 | sdw2-2 |

| sdw3-1 | sdw3-2 |

Затем вы должны запустить gpcheckperf один раз для каждой подсети. Например (при тестировании чётного числа хостов запустите в режиме тестирования параллельных пар):

$ gpcheckperf -f hostfile_gpchecknet_ic1 -r N -d /tmp > subnet1.out

$ gpcheckperf -f hostfile_gpchecknet_ic2 -r N -d /tmp > subnet2.outЕсли у вас нечётное количество хостов для тестирования, вы можете запустить его в режиме последовательного тестирования (-r n).

¶ 8.2 Проверка дискового ввода-вывода и пропускной способности памяти

Чтобы проверить производительность диска и пропускной способности памяти, запустите gpcheckperf с параметрами тестового запуска диска и потока (-r ds). При тестировании диска используется команда dd (стандартная утилита UNIX) для проверки последовательной пропускной способности логического диска или файловой системы. Тест памяти использует программу тестирования STREAM для измерения устойчивой пропускной способности памяти. Результаты сообщаются в МБ в секунду (МБ/с).

Чтобы запустить дисковый и потоковый тесты:

1. Войдите в систему на хосте мастера как пользователь gpadmin.

2. Загрузите файл пути greenplum_path.sh из вашей установки RT.Warehouse. Например:

$ source /usr/local/greenplum-db/greenplum_path.sh3. Создайте файл хоста с именем hostfile_gpcheckperf с одним именем хоста для каждого хоста сегмента. Не включайте хост мастера. Например:

sdw1

sdw2

sdw3

sdw44. Запустите утилиту gpcheckperf, используя только что созданный файл hostfile_gpcheckperf. Используйте параметр -d, чтобы указать файловые системы, которые вы хотите протестировать на каждом хосте (у вас должен быть доступ для записи в эти каталоги). Вам нужно будет протестировать все расположения каталогов данных основного и зеркального сегментов. Например:

$ gpcheckperf -f hostfile_gpcheckperf -r ds -D \

-d /data1/primary -d /data2/primary \

-d /data1/mirror -d /data2/mirror5. Утилите может потребоваться время для выполнения тестов, поскольку она копирует очень большие файлы между хостами. Когда он будет завершён, вы увидите сводные результаты тестов Disk Write, Disk Read и Stream.

¶ 9. ИНИЦИАЛИЗАЦИЯ СИСТЕМЫ RT.WAREHOUSE

Раздел описывает, как инициализировать систему RT.Warehouse.

Инструкции в этом разделе предполагают, что вы уже подготовили свои хосты, как описано в разделе 4, и установили программное обеспечение RT.Warehouse на всех хостах в системе в соответствии с инструкциями в разделе 5.

¶ 9.1 Обзор

Поскольку RT.Warehouse является распределённой, процесс инициализации системы управления базой данных (СУБД) RT.Warehouse включает в себя инициализацию нескольких отдельных инстансов базы данных PostgreSQL (называемых инстансами сегментов в RT.Warehouse).

Каждый инстанс базы данных (мастер и все сегменты) должен быть инициализирован на всех хостах в системе таким образом, чтобы все они могли работать вместе как единая СУБД. RT.Warehouse предоставляет свою собственную версию initdb под названием gpinitsystem, которая заботится об инициализации базы данных на инстансах мастера и всех сегментов и запуске каждого инстанса в правильном порядке.

После инициализации и запуска системы баз данных RT.Warehouse вы можете создавать базы данных и управлять ими, как в обычной СУБД PostgreSQL, подключившись к мастеру RT.Warehouse.

¶ 9.2 Инициализация RT.Warehouse

Для инициализации RT.Warehouse необходимо выполнить высокоуровневые задачи:

- Убедитесь, что вы выполнили все задачи по установке, описанные в разделах 4 и 5.

- Создайте файл хоста, содержащий адреса хостов ваших сегментов. См. п. 8.2.1.

- Создайте файл конфигурации системы RT.Warehouse. См. п. 8.2.2.

- По умолчанию RT.Warehouse инициализируется с использованием локали хоста мастера системы. Убедитесь, что это правильный языковой стандарт, который вы хотите использовать, поскольку некоторые параметры локали не могут быть изменены после инициализации. Дополнительные сведения см. в разделе 10.

- Запустите утилиту инициализации RT.Warehouse на хосте мастера. См. п. 8.2.3.

- Установите часовой пояс RT.Warehouse. См. п. 8.2.5.

¶ 9.2.1 Создание файла хоста инициализации

Утилите gpinitsystem требуется файл хоста, содержащий список адресов для каждого хоста сегмента. Утилита инициализации определяет количество инстансов сегмента на хост по количеству адресов хостов, перечисленных для каждого хоста, умноженному на количество местоположений каталогов данных, указанных в файле gpinitsystem_config.

Этот файл должен содержать только адреса хостов сегмента (не мастера или резервного мастера). Для сегментных машин с несколькими несвязанными сетевыми интерфейсами в этом файле должны быть перечислены имена адресов хостов для каждого интерфейса — по одному в каждой строке.

|

Примечание. Соглашение об именах хостов сегмента RT.Warehouse — sdwN, где sdw — префикс, а N — целое число. Например, sdw2 и т.д. Если хосты имеют несколько несвязанных сетевых адаптеров (NIC), по соглашению к имени хоста добавляется тире (-) и номер. Например, sdw1-1 и sdw1-2 — это два имени интерфейса для хоста sdw1. Однако для создания отказоустойчивой сети с балансировкой нагрузки рекомендуется использовать NIC. |

Чтобы создать файл хоста инициализации:

1. Войдите в систему как gpadmin.

$ su - gpadmin2. Создайте файл с именем hostfile_gpinitsystem. В этом файле добавьте имя/имена адреса хоста интерфейсов хоста вашего сегмента, по одному имени в строке, без лишних строк или пробелов. Например, если у вас есть четыре хоста сегмента с двумя несвязанными сетевыми интерфейсами каждый:

sdw1-1

sdw1-2

sdw2-1

sdw2-2

sdw3-1

sdw3-2

sdw4-1

sdw4-23. Сохраните и закройте файл.

|

Примечание. Если вы не уверены в именах хостов и/или именах адресов интерфейсов, используемых вашими машинами, загляните в файл /etc/hosts. |

¶ 9.2.2 Создание файла конфигурации RT.Warehouse

Файл конфигурации RT.Warehouse сообщает утилите gpinitsystem, как вы хотите настроить систему RT.Warehouse. Пример файла конфигурации можно найти в $GPHOME/docs/cli_help/gpconfigs/gpinitsystem_config.

Чтобы создать файл gpinitsystem_config:

1. Войдите как gpadmin.

$ su - gpadmin2. Сделайте копию файла gpinitsystem_config для использования в качестве отправной точки. Например:

$ cp $GPHOME/docs/cli_help/gpconfigs/gpinitsystem_config \

/home/gpadmin/gpconfigs/gpinitsystem_config3. Откройте только что скопированный файл в текстовом редакторе.

Установите все необходимые параметры в соответствии с вашей средой. Система RT.Warehouse должна содержать инстанс мастера и как минимум два инстанса сегмента (даже при настройке системы с одним хостом).

Параметр DATA_DIRECTORY определяет, сколько сегментов будет создано на каждом хосте. Если хосты ваших сегментов имеют несколько сетевых интерфейсов, и вы использовали их имена адресов интерфейсов в своём файле хоста, количество сегментов будет равномерно распределено по количеству доступных интерфейсов.

Чтобы указать PORT_BASE, просмотрите диапазон портов, указанный в параметре net.ipv4.ip_local_port_range в файле /etc/sysctl.conf.

Вот пример обязательных параметров в файле gpinitsystem_config:

ARRAY_NAME="Greenplum Data Platform"

SEG_PREFIX=gpseg

PORT_BASE=6000

declare -a DATA_DIRECTORY=(/data1/primary /data1/primary /data1/primary /data2/primary /data2/primary /data2/primary)

MASTER_HOSTNAME=mdw

MASTER_DIRECTORY=/data/master

MASTER_PORT=5432

TRUSTED_SHELL=ssh

CHECK_POINT_SEGMENTS=8

ENCODING=UNICODE4. [Опционально] Если вы хотите развернуть зеркальные сегменты, раскомментируйте и установите параметры зеркалирования в соответствии с вашей средой. Чтобы указать MIRROR_PORT_BASE, просмотрите диапазон портов, указанный в параметре net.ipv4.ip_local_port_range в файле /etc/sysctl.conf. Вот пример дополнительных параметров зеркала в файле gpinitsystem_config:

MIRROR_PORT_BASE=7000

declare -a MIRROR_DATA_DIRECTORY=(/data1/mirror /data1/mirror /data1/mirror /data2/mirror /data2/mirror /data2/mirror)

|

Примечание. Вы можете инициализировать систему RT.Warehouse только с основными сегментами, а позже развернуть зеркала с помощью утилиты gpaddmirrors. |

5. Сохраните и закройте файл.

¶ 9.2.3 Запуск утилиты инициализации

Утилита gpinitsystem создаст систему RT.Warehouse, используя значения, определённые в файле конфигурации.

¶ 9.2.3.1 Запуск утилиты

Для запуска утилиты инициализации:

1. Выполните следующую команду, указав путь и имя файла конфигурации инициализации (gpinitsystem_config) и файла хоста (hostfile_gpinitsystem). Например:

$ cd ~

$ gpinitsystem -c gpconfigs/gpinitsystem_config -h gpconfigs/hostfile_gpinitsystemДля полностью резервированной системы (с резервным мастером и конфигурацией расширенного зеркала) укажите параметры -s и ‑S. Например:

$ gpinitsystem -c gpconfigs/gpinitsystem_config -h gpconfigs/hostfile_gpinitsystem \

-s standby_master_hostname -S2. Утилита проверит вашу информацию о настройке и убедится, что она может подключиться к каждому хосту и получить доступ к каталогам данных, указанным в вашей конфигурации. Если все предварительные проверки прошли успешно, утилита предложит вам подтвердить вашу конфигурацию. Например:

=> Continue with Greenplum creation? Yy/Nn3. Нажмите y, чтобы начать инициализацию.

4. Затем утилита начнёт настройку и инициализацию инстанса мастера и каждого инстанса сегмента в системе. Каждый инстанс сегмента настраивается параллельно. В зависимости от количества сегментов этот процесс может занять некоторое время.

5. По завершении успешной установки утилита запустит вашу систему RT.Warehouse. Вы должны увидеть:

=> RT.Warehouse instance successfully created.¶ 9.2.3.2 Устранение неполадок при инициализации

Если утилита обнаружит какие-либо ошибки при настройке инстанса, весь процесс завершится ошибкой и может оставить вас с частично созданной системой. Обратитесь к сообщениям об ошибках и журналам, чтобы определить причину сбоя и место в процессе сбоя. Файлы журнала создаются в ~/gpAdminLogs.

В зависимости от того, когда в процессе возникла ошибка, вам может потребоваться очистить её, а затем снова попробовать утилиту gpinitsystem. Например, если некоторые инстансы сегментов были созданы, а некоторые из них вышли из строя, вам может потребоваться остановить процессы postgres и удалить все каталоги данных, созданные утилитой, из ваших областей хранения данных. Скрипт возврата создаётся, чтобы при необходимости помочь с этой очисткой.

¶ 9.2.4 Использование скрипта возврата

Если утилита gpinitsystem выйдет из строя, она создаст следующий скрипт возврата, если она оставила вашу систему в частично установленном состоянии:

~/gpAdminLogs/backout_gpinitsystem_<user>_<timestamp>Вы можете использовать этот скрипт для очистки частично созданной системы RT.Warehouse. Этот скрипт возврата удалит все каталоги данных, созданные утилитой, процессы postgres и файлы журналов. После исправления ошибки, которая привела к сбою gpinitsystem, и запуска скрипта возврата, вы должны быть готовы повторить попытку инициализации массива RT.Warehouse.

В следующем примере показано, как запустить скрипта возврата:

$ sh backout_gpinitsystem_gpadmin_20071031_121053¶ 9.2.5 Установка часового пояса RT.Warehouse

Рекомендуется настроить RT.Warehouse и хост-системы на использование известного поддерживаемого часового пояса. RT.Warehouse использует часовой пояс из набора внутренних часовых поясов PostgreSQL. Установка часового пояса RT.Warehouse не позволяет RT.Warehouse выбирать часовой пояс при каждом перезапуске кластера и устанавливает часовой пояс для инстансов мастера и сегментов.

Используйте утилиту gpconfig, чтобы показать и установить часовой пояс RT.Warehouse. Например, эти команды показывают часовой пояс RT.Warehouse и устанавливают часовой пояс US/Pacific.

# gpconfig -s TimeZone

# gpconfig -c TimeZone -v 'US/Pacific'После изменения часового пояса необходимо перезапустить RT.Warehouse. Команда gpstop -ra перезапускает RT.Warehouse. Представление каталога pg_timezone_names предоставляет информацию о часовом поясе RT.Warehouse.

Дополнительные сведения о часовом поясе RT.Warehouse см. в разделе 10.

¶ 9.3 Установка переменных сред RT.Warehouse

Вы должны настроить свою среду на мастере RT.Warehouse (и резервном мастере). В вашем каталоге $GPHOME находится файл greenplum_path.sh с настройками переменных среды для RT.Warehouse. Вы можете получить этот файл в профиле оболочки запуска пользователя gpadmin (например, .bashrc).

Утилиты управления RT.Warehouse также требуют, чтобы была установлена переменная среда MASTER_DATA_DIRECTORY. Это должно указывать на каталог, созданный утилитой gpinitsystem в расположении каталога основных данных.

|

Примечание. Скрипт greenplum_path.sh изменяет операционную среду для поддержки работы утилит, специфичных для RT.Warehouse. Эти же изменения в среде могут негативно повлиять на работу других утилит системного уровня, таких как ps или yum. Используйте отдельные учётные записи для выполнения системного администрирования и администрирования базы данных, вместо того, чтобы пытаться выполнять обе функции как gpadmin. |

Чтобы настроить пользовательскую среду для RT.Warehouse:

1. Убедитесь, что вы вошли как gpadmin:

$ su - gpadmin2. Откройте файл профиля (например, .bashrc) в текстовом редакторе. Например:

$ vi ~/.bashrc3. Добавьте в этот файл строки для исходного файла greenplum_path.sh и установите переменную среды MASTER_DATA_DIRECTORY. Например:

source /usr/local/greenplum-db/greenplum_path.sh

export MASTER_DATA_DIRECTORY=/data/master/gpseg-14. [Опционально] Вы также можете установить некоторые переменные среды клиентского сеанса, такие как PGPORT, PGUSER и PGDATABASE для удобства. Например:

export PGPORT=5432

export PGUSER=gpadmin export PGDATABASE=default_login_database_name5. [Опционально] Если вы используете РЕД ОС 7, RHEL/CentOS добавьте следующую строку в конец файла .bashrc, чтобы включить использование команды ps в среде greenplum_path.sh:

export LD_PRELOAD=/lib64/libz.so.1 ps6. Сохраните и закройте файл.

7. После редактирования файла профиля загрузите его, чтобы изменения вступили в силу. Например:

$ source ~/.bashrc8. Если у вас есть хост резервного мастера, скопируйте файл среды также на резервный мастер. Например:

$ cd ~

$ scp .bashrc standby_hostname:`pwd`

|

Примечание. Файл .bashrc не должен выводить никаких сообщений. Если вы хотите, чтобы сообщения отображались для пользователей при входе в систему, используйте вместо этого файл .profile. |

¶ 9.4 Следующие шаги

После того, как ваша система настроена и работает, выполните шаги, представленные ниже.

¶ 9.4.1 Разрешение клиентских подключений

После первой инициализации RT.Warehouse она будет разрешать только локальные подключения к базе данных из роли gpadmin (или любого другого системного пользователя, запускающего gpinitsystem). Если вы хотите, чтобы другие пользователи или клиентские машины могли подключаться к RT.Warehouse.

¶ 9.4.2 Создание баз данных и загрузка данных

После проверки вашей установки вы можете начать создавать базы данных и загружать данные.

¶ 10. УСТАНОВКА ДОПОЛНИТЕЛЬНЫХ ПОСТАВЛЯЕМЫХ МОДУЛЕЙ

Дистрибутив RT.Warehouse включает несколько модулей contrib, полученных из PostgreSQL и RT.Warehouse, которые вы можете установить.

Каждый модуль обычно упаковывается как расширение RT.Warehouse. Вы должны зарегистрировать эти модули в каждой базе данных, в которой хотите их использовать. Например, чтобы зарегистрировать модуль dblink в базе данных с именем testdb, используйте команду: